近年、生成AI(Generative AI)の進化によって、画像、音声、テキストといった多様な形式のコンテンツ生成が可能になり、さまざまな業界で革新的なサービスが実現されています。しかし、その高度なAIモデルをリアルタイムで運用するためには、膨大な計算リソースと、これらを効率よく管理・スケーリングするための柔軟なインフラが必要となります。本記事では、NVIDIAのDynamoとAmazon EKS(Elastic Kubernetes Service)を組み合わせることで、生成AIの推論(inference)処理を高速かつ効率的に行うためのアプローチに焦点を当て、その仕組みとメリットを詳しく解説します。

生成AI推論の課題と必要性

大規模言語モデル(LLM)や画像生成モデルなど、高精度な生成AIはそのトレーニングフェーズで莫大な計算負荷をかけることが知られていますが、実際にアプリケーションとしてサービス化する際には「推論性能」の最適化が不可欠です。生成AIモデルは、その性質上、計算パターンが複雑で、バッチ処理だけでなく、低レイテンシーかつ高同時接続数に対応するリアルタイム処理が求められるため、一般的なクラウドインフラでの運用ではスケーリングの課題やリソースのオーバーヘッドがしばしば発生します。

こうした背景から、「AI推論の高速化」「インフラの効率化」「リソースコストの削減」が生成AIを運用するうえで重視されるテーマとなっています。

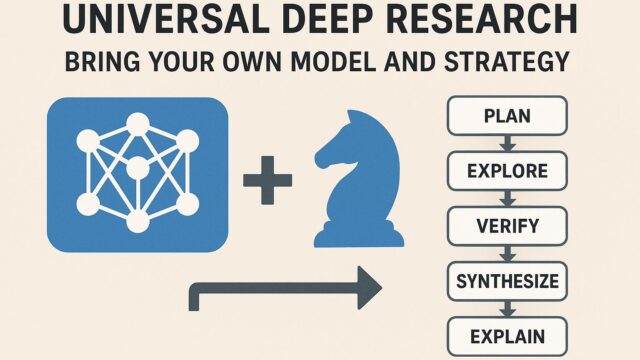

NVIDIA Dynamoとは

NVIDIA Dynamoは、GPUハードウェアと密に連携しながら、生成AIモデルの推論処理を最適化するランタイム環境およびツールチェーンです。具体的には、以下のような要素で構成されています:

– NVIDIAのTensorRTと連携した高度なモデル最適化

– マルチテナント環境でのリソース共有を効率化するGPUメモリ管理

– Stable DiffusionやGPTなどの代表的な生成モデルのプリセットサポート

– 高スループットと低レイテンシーを両立するマイクロバッチ処理の自動調整

開発者はDynamoを用いることで、既存の生成AIモデルを再トレーニングせずに最適化された形式で推論利用できるようになります。特に複数のユーザーリクエストを同時に効率よく処理する機能が強化されており、オンラインサービスへの組み込みに向いた設計と言えます。

Amazon EKSの役割

Amazon EKSは、AWS上でKubernetesクラスターを簡単にデプロイ・管理できるマネージドサービスです。生成AIのような複雑なワークロードでは、コンテナベースのスケーラブルな環境が非常に有効です。EKSは、以下のような利点を提供します:

– Kubernetesネイティブの自動スケーリング機能

– GPUベースのワーカーノード配置への対応

– ネットワーク、セキュリティ、IAMとの統合による運用効率の向上

– Fargateなどのサーバーレスオプションによる柔軟性の確保

EKSを使用することで、AI推論の処理単位をコンテナとして抽象化でき、ジョブ単位で柔軟にスケールアップ・スケールダウンが可能になるため、システム全体の効率化とコスト最適化が実現します。

DynamoとAmazon EKSの連携

NVIDIA Dynamoは単体でも強力ですが、Amazon EKSと組み合わせることでさらにポテンシャルを高めることができます。EKS上でDynamoを稼働させる構成にすることで、以下のような利点が生まれます:

1. 自動スケーリングによる需要変動への即時対応

AI推論リクエストが時間帯やイベントによって変動する場合でも、EKSのオートスケーリング機能によって、Dynamo推論エンジンを含むPod数を自動的に調整することができます。これにより、リクエストのラグやタイムアウトを最小限に抑えることが可能です。

2. ワークロード分離とマルチテナント対応

異なるAIモデルやユーザーグループごとに独立したネームスペースやNodeグループを設けることで、ワークロードの分離とセキュリティ確保がしやすくなります。GPU割り当てのコントロールが容易になり、多様なユースケースに対して柔軟に最適化可能です。

3. ロギングとモニタリングが容易

Amazon CloudWatchやPrometheus、Grafanaなどのツールと連携することで、生成AIモデルの挙動や利用状況をリアルタイムで可視化・分析できます。問題発生時にも迅速な対応が可能になり、可用性の高い運用がサポートされます。

4. モデルのホットアップデートが可能

新しいバージョンのAIモデルを逐次デプロイし、トラフィックを段階的に制御する「カナリアリリース」や「ブルーグリーンデプロイメント」といった手法が使用できるため、ユーザーに影響を与えずにモデルの改善を進めることができます。

ユースケースと実装の概要

実際のユースケースでは、以下のようなステップでDynamoとEKSの統合が行われています:

– まず、NVIDIA NGC(NVIDIA GPU Cloud)からDynamoのDockerコンテナイメージを取得し、自前のEKS環境にデプロイ。

– MLOpsパイプラインに連携させ、CI/CDでモデルの更新を自動化。

– Kubernetes上でHelmチャートを利用し、モデルごとにPodテンプレートを定義。

– インファレンスAPIのリクエストは、AWS ALB(Application Load Balancer)を通じてEKSクラスターにルーティング。

– 需要に応じてGPUノードが動的に追加され、最適スループットで推論が実行。

このように、DynamoとEKSの組み合わせは、限られたGPUリソースを最大限に活用しながら、スケーラブルで信頼性の高い生成AIサービス基盤を構築するのに理想的な選択肢と言えるでしょう。

まとめ:スケーラブルで効率的な生成AIインフラの実現

生成AIは今後さらに多くのユースケースで利用されることが想定されており、それに伴って高速かつスケーラブルなインフラの重要性も高まっています。NVIDIAのDynamoは、推論性能を最大化するための最適化されたランタイムを提供し、Amazon EKSはその基盤として高い柔軟性と拡張性を発揮します。

この2つのテクノロジーを連携させることで、開発者や企業は、高品質かつリアルタイムに近い応答性を持つ生成AIサービスを、効率よく構築・展開することができます。今後のAI活用に向けて、こうした新しいアーキテクチャの導入をぜひ検討してみてはいかがでしょうか。