近年、自然言語処理(NLP)の進歩により、大規模言語モデル(LLM)の性能が飛躍的に向上しています。多くの企業や研究者が独自のユースケースに応じたモデルを構築するにあたり、「ファインチューニング(fine-tuning)」は非常に重要なステップとなっています。しかし、このファインチューニングは高い計算コストや長いトレーニング時間、専門的な知識の必要性など、多くの課題を抱えています。

そんな中、Hugging Faceのブログ記事「Faster fine-tuning using TRL & Unsloth」では、こうした課題を克服するための画期的なソリューションが紹介されています。本記事では、この最新技術である「Unsloth」と、それを補完する「TRL(Transformers Reinforcement Learning)」ライブラリの活用によって、いかにしてファインチューニングのスピードと効率を向上させることができるのかについて、読み解いていきます。

Unslothとは何か?

まず、「Unsloth(アンスロース)」とは、非常に高速かつメモリ効率の良い形で大規模言語モデルのファインチューニングを可能にするオープンソースのツールです。特に注目すべきは、UnslothがLoRA(Low-Rank Adaptation)を活用した効率的なパラメータチューニングを行い、わずかなメモリと計算資源でも高品質な学習を実現している点です。

LoRAは、モデルの全てのパラメータを学習させるのではなく、ごく一部の「低ランク」なパラメータのみを更新することで、モデルの出力に大きな影響を与える仕組みです。これにより、従来のファインチューニングに比べ、大幅なリソース削減を実現しています。

Unslothの最大の特徴は、その軽量性です。記事によれば、UnslothはMetaのLLaMA 2やMistralのような高度に最適化されたモデルに対応しており、より低スペックのGPUやノートパソコンにおいてもスムーズにファインチューニングを開始できるとのことです。従来であればハイエンドなGPUを複数枚用意する必要があったケースでも、Unslothを使えばエントリーレベルのGPU(例:RTX 2060)のような構成でも、現実的な時間で学習を終えることができます。

TRLとの連携による強力なサポート

Unslothの実用性をさらに高めるのが、Hugging Faceが提供するライブラリ「TRL(Transformers Reinforcement Learning)」です。これは、トランスフォーマーモデルを用いた強化学習のフレームワークで、主に報酬モデルの構築やRLHF(Reinforcement Learning from Human Feedback:人間からのフィードバックをもとにした強化学習)において使われてきました。

近年注目されているRLHFは、ChatGPTのようなインタラクティブAIにおいて非常に重要な技術です。実際、OpenAIがChatGPTの調整に使っている過程でもRLHFが使われています。その一部の技術が、Hugging FaceのTRLライブラリとして整備されており、開発者が手軽に同様のアプローチを採用できる環境が整っています。

UnslothとTRLを組み合わせることで、LoRAによる省リソースなファインチューニングと、報酬に基づいた生成制御のアルゴリズムを同時に活用できるため、より高性能で応答性の良いAIエージェントを作成することが可能になります。

実際の使用例とチュートリアル

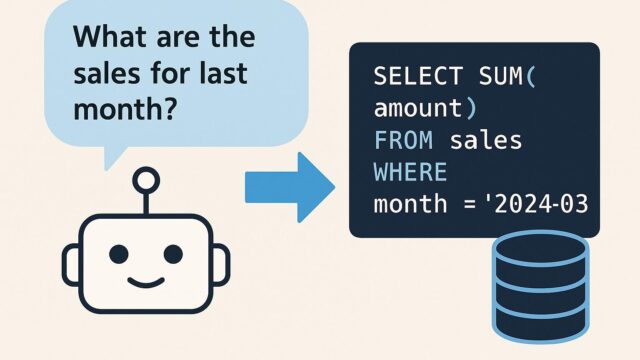

記事では、UnslothとTRLを活用した非常に簡便な使用例も紹介されています。Pythonのコードにおいても、その使いやすさは際立っており、わずか数行のコードでモデルの読み込みからLoRAの適用、そしてトレーニングの実行までが完結しています。

以下はその概略です:

1. HuggingFaceのモデルAPIから必要なモデル(例えばLLaMA 2やMistral)をダウンロード

2. Unslothを使ってモデルをロードし、LoRAによりトレーニング可能な状態にする

3. データセットをロードし、事前に定義されたスクリプトまたは独自の学習ステップでトレーニング

4. 必要に応じてTRLのPPOTrainerなどを導入して、特定の応答性を高める調整を行う

この手順に従えば、エンジニアや研究者だけでなく、個人の技術者やスタートアップなどにも、最小限の投資で高度なAIモデルを構築・実験することが可能となります。

実際のパフォーマンスとベンチマーク

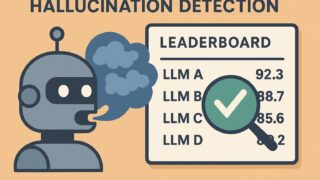

Unslothの性能についても、記事ではいくつかのベンチマークが紹介されています。ある比較では、同じハードウェア上でHugging Face Transformers、PEFT、Unslothを使ったLoRA学習を行ったところ、Unslothが最も高速なトレーニング速度と最小メモリ使用量を記録したとのことです。例えば、Colab環境において、7Bスケールのモデルが1.5倍から2倍近く高速にトレーニングを終えるという結果が出ています。

このように、Unslothは速度面でもメモリ面でも他の手法に比べて優れており、TRLとの相性も抜群であることがわかります。

今後の展望と開発の可能性

Unslothはまだ比較的新しいプロジェクトですが、既に多くの実用性を持ち、多方面での応用が期待されています。将来的には、マルチGPUサポート、他のAIフレームワーク(TensorFlowやJAXなど)への対応、さらに新しい形式のLoRA実装へと進化する可能性も示唆されています。

また、コミュニティベースでの改善も進んでおり、GitHub上ではプルリクエストも活発に行われています。開発陣も柔軟な姿勢を取り続けており、多くのユーザーからのフィードバックがプロジェクトに即座に反映されている点も、今後の普及において大きな強みとなるでしょう。

まとめ:誰もが高性能モデルを扱える時代へ

大規模言語モデルを自分好みにカスタマイズし、実際のプロジェクトや研究に応用することは、これまでハードルの高い工程でした。しかし、UnslothとTRLの登場によって、これが格段に簡単かつ効率よく可能となりました。

特に個人開発者や小規模チームにとっては、これまでの高性能AI開発にかかる予算やハードルが大きく下がることで、新たなアイデアや製品が次々に生まれる土壌が整ったと言えるでしょう。

私たちは今、AI技術がますます身近になり、あらゆる分野での応用が加速する大きな変化の始まりに立ち会っています。UnslothとTRLは、その変革を支える重要な技術であり、これからの時代に欠かせないツールとなることでしょう。興味を持った方は、ぜひ実際に使ってみてその性能を体感してみてください。未来のAIは、より多くの人々の手で創られていくのです。