RAG(Retrieval-Augmented Generation)を本番環境で最適化する:Amazon SageMaker JumpStartとAmazon OpenSearch Serviceを活用した実践的アプローチ

生成AIの台頭により、企業はより洗練された自然言語処理(NLP)ソリューションの導入に注力しています。この中核となる技術の一つが、RAG(Retrieval-Augmented Generation)です。RAGは、大規模言語モデル(LLM)と既存の情報検索技術を組み合わせて、文脈に根ざした高品質なコンテンツ生成を可能にする新たなアーキテクチャです。

とはいえ、RAGはその高度な機能性と柔軟性から、開発と本番環境への移行において多くの技術的課題も伴います。特に、モデルのデプロイ、セキュアなデータ管理、パフォーマンスの最適化といった側面での配慮が求められます。

この記事では、AWSが提供するAmazon SageMaker JumpStartとAmazon OpenSearch Serviceを活用して、RAGの本番運用を効率的かつスムーズに行うためのベストプラクティスとソリューションをご紹介します。

RAGとは何か?基礎から理解する

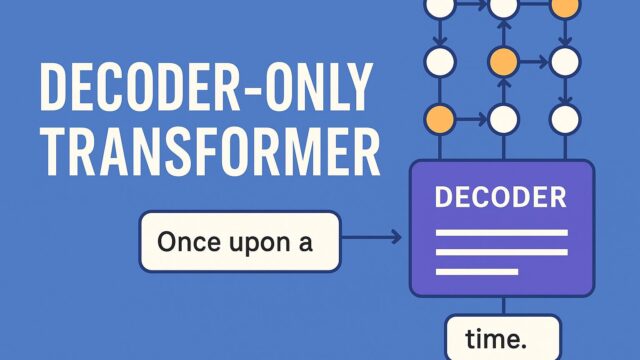

従来の生成モデルは、訓練データに基づいた内容しか出力できず、最新情報や外部データソースの取り込みが困難でした。これに対してRAGは、「外部データソースから情報を検索し、それを元に文章を生成する」アプローチを取ります。簡単に言えば、質問に対してより正確で具体的な応答を生成するために、検索フェーズと生成フェーズを組み合わせる方式です。

RAGの一般的なアーキテクチャは以下の3つの主要コンポーネントから成り立ちます:

1. データの取得(Retrieval):外部データソース、特にベクトル検索エンジンから関連情報を取得。

2. コンテキスト統合:取得された情報をコンテキストとして大規模言語モデルに入力。

3. 応答生成:そのコンテキストを元に、LLMが最終的な出力や応答を生成。

この方式により、ユーザーは常に最新かつ状況に即した回答を得ることができます。

本番環境におけるRAG導入の課題

RAGのアーキテクチャは柔軟ですが、そのまま本番環境に導入するとなると、多くの運用上の課題に直面します。例えば:

– データパイプラインの管理:大量のドキュメントやドメイン固有の知識をベクトル化し、効率的に検索できるように構造化する必要があります。

– モデルの調整とデプロイ:生成精度や応答品質を保ちながら、低レイテンシでスケーラブルなモデルデプロイが求められます。

– セキュリティとガバナンス:社内知識や顧客情報など、センシティブな情報を扱う場合は、権限管理、暗号化、データのライフサイクル管理が必須です。

このような課題を克服するため、AWSのサービス群がどう活用できるかを次に見ていきましょう。

Amazon SageMaker JumpStartで簡単にRAGソリューションを立ち上げる

Amazon SageMaker JumpStartは、機械学習の導入を簡素化するためのテンプレートやビルディングブロックを提供するサービスです。従来は手動で構築していた複雑なパイプラインも、JumpStartを使えば数クリックで構築することが可能になります。

今回紹介されたSageMaker JumpStartのRAGソリューションテンプレートは、以下のような特徴を持っています:

– オープンソースLLM(例:Falcon 7B-Instruct)を活用し、幅広い環境で自由にカスタマイズが可能。

– 最初からRAGアーキテクチャに必要なコンポーネントが統合されたオールインワン構成。

– ドキュメントの取り込み、分割、ベクトル化などの前処理が自動化されており、コードの記述なしで設定可能。

加えて、開発者向けのステップバイステップガイドも用意されており、初心者でも迷うことなく利用を開始できます。

Amazon OpenSearch Serviceによるセキュアかつ高速なデータ検索

RAGのパフォーマンスに大きく影響を与えるコンポーネントが「検索」です。ここで登場するのがAmazon OpenSearch Serviceです。オープンソースプロジェクトであるOpenSearchをベースに、AWSがマネージドサービスとして提供しています。

RAGアーキテクチャにおいては、以下のような形でOpenSearchが活用されます:

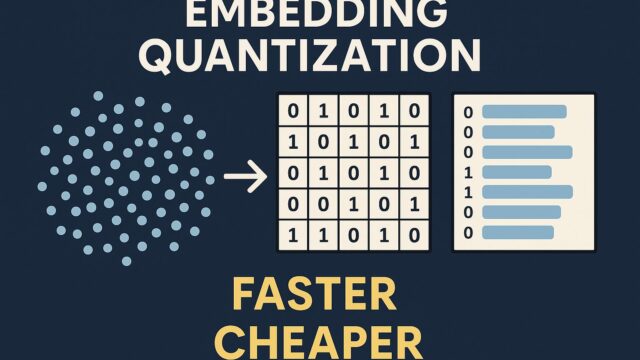

– ベクトルデータのインデックス化:ドキュメントをベクトル形式に変換し、セマンティックサーチに対応。

– ANN(Approximate Nearest Neighbor)による高速検索:膨大なデータから関連性の高いドキュメントを迅速に抽出。

– セキュリティ機能:IAMとの統合やTLS暗号化、アクセスコントロールなど、企業レベルのセキュリティを実現。

以前はテキストベースでのキーワード検索が主流でしたが、ベクトル検索の導入により、より文脈に即した意味的なマッチングが可能となり、RAGの応答精度も大幅に向上します。

RAGソリューションの典型的なワークフロー

今回のAWS公式ブログでは、RAGソリューションの標準的な構成も紹介されています。全体の流れは以下のようになります:

1. ドキュメントの取り込み:PDFやテキストファイルなどの生データをS3にアップロード。

2. データ処理:JumpStart上でドキュメントを分割し、OpenSearch用にベクトル変換。

3. インデックス作成:OpenSearch Serviceによりドキュメントベクトルをインデックス化。

4. クエリ実行:ユーザーからの入力をベクトル化してOpenSearchに対してクエリを実行。

5. コンテキスト抽出と生成:検索結果をLLMに渡して文脈を添えた応答を生成。

6. UIまたはAPI経由でユーザーに返答。

この一連の流れは、すべてエンドツーエンドで自動化されており、SageMaker Studioなどの開発環境からも直感的に操作できます。

ワークショップと拡張可能性

記事の後半では、SageMaker Studio LabやノートブックベースでのRAG導入のワークフローも紹介されています。以下のような価値を提供しています:

– ハンズオン形式で学習可能:サンプルコードやノートブックを利用して、RAGの仕組みを実体験。

– ドメイン別の拡張容易性:法務、ヘルスケア、金融などの分野に合わせたカスタマイズが可能。

– 他サービスとの統合:LambdaやAPI Gatewayと組み合わせることで、ChatbotやFAQ Botへの応用も現実的。

今後の展開と可能性

このように、AWSのマネージドサービス群を組み合わせることで、RAGの導入に伴う複雑な構成や運用負荷を大幅に軽減できます。特に、SageMaker JumpStartのテンプレートとOpenSearch Serviceとの統合により、以下のような利点が実現できます:

– 環境構築の迅速化

– 本番レベルでの信頼性とセキュリティ

– スケーラブルかつ低レイテンシ

今後、生成AIはさらに多様な業務領域への適用が進むと予測されます。RAGを活用することで、ユーザーとのインタラクションは一層パーソナライズされ、ビジネス上の洞察や判断もより高度なものへと進化します。

まとめ:RAGの本番導入が実現可能な時代へ

これまで、生成AIを本格的に業務に組み込むには多くのハードルが存在していました。しかし、Amazon SageMaker JumpStartとAmazon OpenSearch Serviceの登場により、RAGのような高度なアーキテクチャも現実的な選択肢となりました。

ドキュメントの取り込みから応答生成まで、ほぼすべてのプロセスがマネージドで提供されており、高速なプロトタイピングと本番移行が可能です。データセキュリティ、スケーラビリティ、応答の質──そのすべてが担保された形で、今、ビジネスの成長を加速する鍵としてRAGが注目を集めているのです。

生成AIとRAGの融合による次世代アプリケーションの可能性を、ぜひ貴社のビジネスに取り入れてみてはいかがでしょうか。AWSのツール群なら、それを現実のものとする環境がすでに整っています。