要旨:AI対応企業の“次の常識”

与えられた記事タイトル「Building the AI-enabled enterprise of the future」から読み取れる主眼は、AIを単なるツール導入ではなく、事業の運営様式そのものを刷新するテコとして組み込むことです。典型的には、データ基盤の整備、責任あるAIガバナンス、スケーラブルなMLOps/LLMOps、そして人とプロセスの再設計までが一体で語られます。本稿では一般に流通する“主流解釈”と記事の示唆がズレる点を3つ挙げ、その意味を短期・中期の二軸で整理します。加えて、日本企業特有の文脈に接続し、実務に落とし込む勘所を提示します。

主流解釈と記事のズレ:3つのポイント

- 「モデル中心」から「コンテキスト中心」へ

主流解釈:強力な基盤モデルを採用すれば多くの課題は解ける。

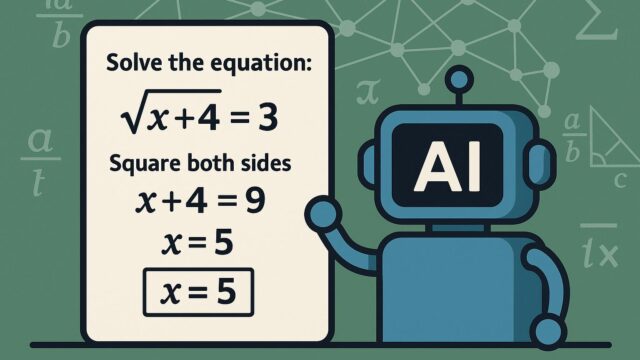

記事の示唆:モデル単体では価値が出にくく、ドメイン知識・社内文書・業務メタデータを織り込む“コンテキスト運用”(RAG、ナレッジグラフ、ベクトルDB、評価データセット)が決定的。時に小さなモデル+良質な文脈が最短距離になる。 - 「PoC量産」から「AIプロダクト化」へ

主流解釈:まずPoCをたくさん回し、うまくいったものを拡張する。

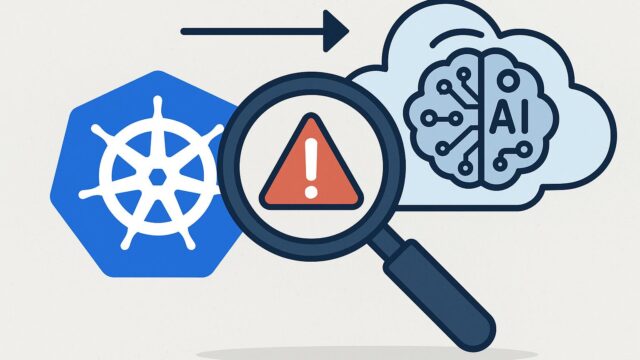

記事の示唆:PoC劇場を抜けるには、再利用可能なコンポーネント(プロンプト資産、評価パイプライン、セキュリティ・監査)を共通化した“AIプラットフォーム/AIファクトリー”が必須。初手から“作って終わり”ではなく“運用して育てる”設計がいる。 - 「スキル採用」から「オペレーティングモデル刷新」へ

主流解釈:プロンプトエンジニアやデータサイエンティストを採用すれば前に進む。

記事の示唆:鍵は役割横断(AIプロダクトマネージャー、ドメインオーナー、法務・監査、SRE/セキュリティ、現場リーダー)で回す運営モデル。人事・評価・教育・権限設計まで含めた“組織の作り替え”が避けられない。

そのズレが意味すること:短期と中期の視点

短期(今後数週間〜数ヶ月)

- 投資の重心が「GPU確保」から「データ・評価基盤」へシフト。データ品質、メタデータ管理、プロンプト/評価セットのバージョニング、可観測性(トレーシング)に予算が向かう。

- “ガバナンス内蔵”が前提化。モデル選定時にセキュリティ、プライバシー、法令適合(著作権・個人情報)、プロンプトインジェクション対策、出力監査を同時に設計する。

- 価値の出やすい横断ユースケースに集中。顧客対応、コード支援、ナレッジ検索、自動要約、定型文書の起案など、RAGで即効性が出る領域から着実に。

中期(1〜3年)

- “エージェント化”の進展。複数システムを跨ぐ自律タスク実行(発注・精算・在庫照合など)が現実味を増し、権限設計・人間の最終承認点・責任分界が経営課題になる。

- 人と仕事の再定義。職務記述書が“AI補助前提”で書き換わり、評価軸も成果×AI活用能力へ。再教育(リスキリング)は全職種に波及。

- ベンダーロックインと主権的AIの均衡。コスト・レイテンシ・データ保護要件に応じ、クラウド×オンプレ(エッジ含む)のハイブリッドが常態化。

日本・グローバル経済との接点

- 日本の課題:レガシーシステムと紙/押印の残存、縦割りデータ、厳格な品質文化。強みは現場改善力と長期的関係性。AIは“現場の暗黙知を外化し、反復学習する仕組み”として適合度が高い。

- グローバルの論点:規制(AI法・プライバシー法)、データ移転、サプライチェーン分断、エネルギー消費。とくに電力・冷却・カーボンの制約がクラウド/エッジ選択を左右。

私の独自解釈:AIファクトリーより「コンテキスト・ファクトリー」

ここが独自解釈だ——鍵はモデル工場より“コンテキスト工場”を先に整備することだと考えます。具体的には、共通のナレッジグラフ(語彙・同義・関係)、埋め込みストア、品質ラベル付きのドキュメント群、評価データセット、データリネージ(来歴)を中央集約し、どのモデルを差し替えても性能が劣化しない“文脈供給パイプライン”を社内標準にする。これにより、モデル進化の波に呑まれず、サプライヤーを跨いだ持続的な改善が可能になるはずです。

見逃されがちなポイント(補足)

- 評価こそプロダクトの一部:人手評価と自動指標(正確性、逸脱、毒性、PII漏えい、ソース提示率)をCI/CDに組み込み、変更のたびに“品質の差分”が見える状態に。

- プロンプトの知財・機密性:優秀なプロンプトは社内資産。アクセス権限、リーク監査、テンプレートの標準化が必要。

- データライセンスの健全性:学習/微調整/検索対象に用いるデータの権利関係を明確化。商用可否、再配布可否、保存期間のルール化が肝。

- 運用の手触り:現場導入は“速度×安全×説明責任”の三立が前提。最終承認点をUIに明示し、想定外動作の報告チャネルを常設する。

実装への道筋:初手のチェックリスト

- ユースケース選定:顧客接点、ソフトウェア開発、社内検索のいずれかで事業インパクトとデータ可用性の高いものを。

- データインベントリ:社内文書の所在、更新頻度、機密区分、メタデータの有無を棚卸し。検索可能な形に正規化。

- 最小プラットフォーム:RAG、プロンプト/評価管理、監査ログ、権限管理を備えた共通基盤を用意。小規模でも“共通”が重要。

- 責任あるAI:リスク分類、レビュー基準、異常検知、説明ポリシーを明文化。モデル更新の承認プロセスも定義。

- 人材と運営:AIプロダクトマネージャー、ドメインオーナー、セキュリティ/法務を含むスクワッドで回す。評価は“改善速度”も見る。

日本企業への現実解:エッジ×本社の二段構え

製造・流通・インフラなど現場が強い日本では、エッジAIの即効性が高いケースが多いです。検査・安全・省エネ・需要予測など“現場の判断”にAIを足すと投資対効果が見えやすい。まずは小型のエッジAI端末で実データを回し、並行して本社側でナレッジ検索や文書作成の共通基盤を整える“二段構え”が現実的です。

最後に:いま決めるべき一点

“モデルを選ぶか”より“文脈をつくるか”。この優先順位を明確にした企業が、変化の激しいAI潮流でもぶれない強さを手に入れるはずです。AIは魔法ではなく、設計思想の総合格闘技。焦らず、しかし止まらず、文脈ファーストで積み上げていきましょう。

本記事の問題解決に役立つ製品

- エッジAIのPoCに:NVIDIA Jetson Orin Nano Developer Kit(Amazon) / (楽天)