地球を脅かす太陽嵐とは?

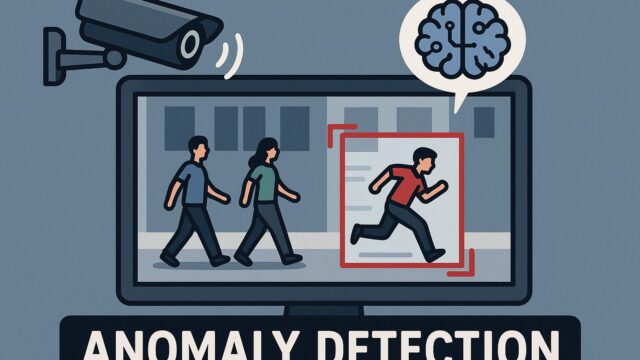

太陽嵐(ソーラーストーム)は、太陽で発生する爆発的なエネルギー放出により、荷電粒子が地球に到達する現象です。これにより、電力網の障害やGPS精度の低下、通信の途絶といった問題が発生することがあります。現代社会のインフラは宇宙天気の影響を受けやすく、太陽嵐の早期予測と対策は急務です。

NASAとIBM、AIで挑む太陽嵐予測

NASAとIBMは、人工知能(AI)の技術を活用して、太陽嵐が地球に到達する正確なタイミングを予測するモデルを開発しました。このAIは、NASAの「Thinker」研究開発チームと、IBMのAI基盤であるWatsonxをベースに構築されたものです。

モデルの仕組みと革新性

この新たに開発されたAIモデルは、コロナ質量放出(CME:Coronal Mass Ejection)と呼ばれる太陽の表面から放出されたプラズマの動きを解析します。従来の物理ベースのモデルではCMEの地球到達時間を予測するのに時間がかかり精度も課題がありましたが、AIは事前の観測データを学習して数分で予測する能力を持っています。

このモデルの最大の特徴は、結果だけでなく予測の根拠を説明できる「説明可能なAI(Explainable AI)」であること。これにより、専門家がその予測を精査し、意思決定に活用することができるようになりました。

社会的な意義と今後の展望

このAIモデルは、今後国際宇宙天気予報センターなど地球環境を監視する機関に応用される予定です。特に航空機の航行や人工衛星の運用、安全保障など、広範囲な分野でのリスク軽減が見込まれます。

NASAとIBMの連携は、科学と技術の境界を越えた協力の好例であり、今後ますますAIが宇宙科学の現場で活用されていくことが期待されています。

まとめ

太陽嵐の予測は、これまで十分に実現されていなかった科学的課題でしたが、NASAとIBMのAI技術により、地球環境と生活インフラの保護に大きな一歩が踏み出されました。私たちの暮らしを見えない宇宙の脅威から守る——その背後に、日々進化するテクノロジーの力があるのです。