はじめに

近年、AI技術の進歩は目覚ましく、特に推論能力を加速・簡素化する自然言語処理モデルの開発が急速に進んでいます。そんな中で、NVIDIAが発表したNemotron Nano 2は、軽量かつ高精度な自然言語推論を実現するモデルとして注目を集めています。本記事では、この革新的なモデルについて、その技術的背景や実装の特徴、実用性について詳しく解説していきます。

Nemotron Nano 2とは?

Nemotron Nano 2は、NVIDIAが開発した小型かつ高性能な言語モデルであり、TransformerとMambaという2つのアーキテクチャのハイブリッド構成が採用されています。このアプローチにより、従来のモデルと比べて少ない計算資源で高精度な推論を実現しています。

- サイズ感: 最大3.8Bパラメータという、中規模モデルであるにも関わらず卓越した性能を発揮

- 複合アーキテクチャ: Transformerによる高精度学習とMambaによる長距離依存性処理の融合

- FP8推論対応: 実行効率に優れており、エッジデバイスやモバイル環境でも活用が可能

Mambaとは何か?

Nemotron Nano 2の中核をなす技術のひとつがMambaです。これは、State Space Model(SSM)に基づく新しい系列処理モデルで、Transformerのような注意機構を用いずに時系列データを扱う特徴を持っています。これにより計算効率が飛躍的に向上し、特に長文処理において大きな効果をもたらします。

Nemotron Nano 2の特徴と強み

本モデルの大きな特徴は以下の通りです。

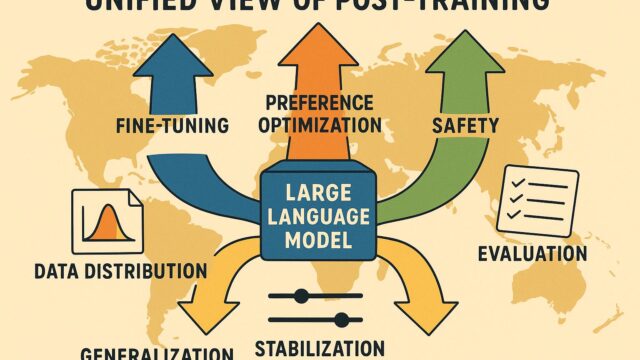

- Hybridアーキテクチャ: TransformerとMambaのハイブリッドにより、柔軟かつ効率的な情報処理が可能

- スケールの最適化: モデルサイズが大きくならなくても優れた性能を発揮

- ファインチューニング対応: DollyやAlpacaなどの指示フォーマットでファインチューニングが可能

- 高い推論精度: 各種ベンチマークテスト(GSM8K、MMLU等)で従来の軽量モデルを上回る精度を達成

応用範囲と実用性

Nemotron Nano 2は、その小型かつ高性能という特性から、多くの実用アプリケーションでの利用が期待されています。エッジAIやモバイルAI、組み込み機器における自然言語処理、大規模言語モデルによる補助生成など、幅広いタスクに対応可能です。

加えて、オープンソースとして利用が可能であり、研究者や開発者にも扱いやすく、実験やプロトタイピングにも最適です。

まとめ

NVIDIA Nemotron Nano 2は、AIモデルの軽量化と高性能化を両立させた代表的な開発成果です。これまで処理速度や精度のトレードオフに悩まされていた小型モデルの限界を乗り越え、次世代の自然言語処理のスタンダードとなる可能性を秘めています。特にFP8による省リソース実行、Hybridアーキテクチャによる柔軟性、そして様々な使用環境への適応力は、多くの技術者にとって新たな選択肢となるでしょう。

AIの民主化が進む中で、Nemotron Nano 2の登場はその実現をさらに加速させるものといえるでしょう。