生成AIアプリケーションを評価するためのカスタムメトリクスの活用 ー Amazon Bedrockによる高品質なAI体験の実現

生成AI(Generative AI)は、自然言語生成、画像生成、コード生成など多様な形で私たちの生活やビジネスを変革しつつあります。企業がよりよい生成AI体験を顧客に提供しようとする中で、AIモデルのパフォーマンスをどのように測定・改善するかは極めて重要な課題です。特に、単に「モデルが動作すること」以上に、「期待される品質で正確かつ倫理的に応答を返すかどうか」は、ユーザー体験やブランド信頼性に直結する要素です。

この記事では、Amazon Bedrockを活用し、カスタムメトリクスを用いて生成AIアプリケーションの品質評価を行う方法について、Amazon公式ブログの内容をもとに解説します。これにより、開発者や企業は、既存のユースケースに特化した評価指標を構築し、実際のアプリケーションに不可欠な品質保証を行えるようになります。

Amazon Bedrockとは?

Amazon Bedrockは、生成AIアプリケーションの開発を容易にするマネージドサービスであり、複数の高品質な基盤モデル(Foundation Models、以下FMs)— 例えばAnthropicのClaude、AI21 LabsのJurassic、Stability AI、MetaのLlama、CohereのCommandなど — を一つのAPIで利用可能にします。何より、これらのモデルはAWSのインフラ上で安全かつスケーラブルに実行されるため、インフラの管理に悩まされることなく、迅速にプロトタイピングと本番環境への展開が可能となります。

生成AIアプリケーションの品質評価の必要性

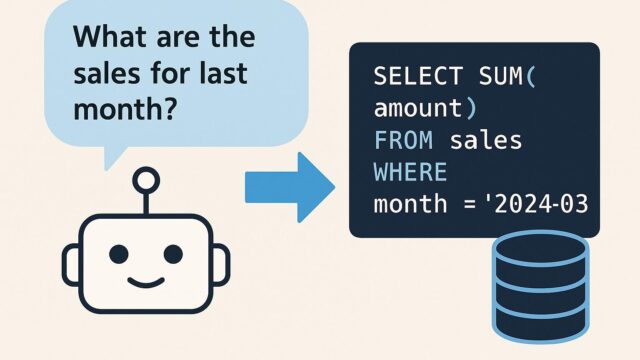

従来のAIモデル、例えば画像分類や構造化データの予測モデルでは、正解ラベルに基づいた評価(AccuracyやPrecision、Recallなど)が一般的でした。しかし、生成AIで扱う自然言語や画像といった非構造データにおいては、「正解」が一つとは限らず、評価がより曖昧になる特徴があります。

たとえば、ユーザーがカスタマーサポートチャットボットに「請求書をもう一度送ってもらえますか?」と聞いたとき、モデルは複数の異なる表現で適切に応答することが可能です。この場合、応答の品質とは「文法的正しさ」だけでなく、「文脈理解」「情報の正確性」「トーンや感情の適切さ」など複雑な要素に依存します。そのため、事前定義された一律の評価方法では限界があり、カスタマイズされた評価指標、すなわちカスタムメトリクスが必要になります。

カスタムメトリクスを使った生成AI評価の構造

Amazon Bedrockでは、カスタムメトリクスを用いた生成AI評価を行うためのフレームワークが提供されています。これにより以下のような評価構成が可能になります。

1. 評価指標の定義:

アプリケーションの目的に応じて、必要な指標を定めます。たとえば「応答の一貫性」「情報の正確性」「ユーザー対応の適切さ」などを独自に設定可能です。

2. 評価対象データの準備:

評価にはHuman-in-the-loop(人間のレビューアー)または自動化された評価ロジックに基づいて、テキストの出力とその正解(ゴールドスタンダード)データを比較します。

3. 評価方法の選択:

– ヒューリスティック評価(ルールベース)

– 大規模言語モデル(LLM)によるアノテーション

– 人的評価

これらを組み合わせることで、柔軟かつ現実に即した評価が行えます。

評価する側をモデル自身にする:LLM-as-a-Judge

Amazon Bedrockでは、「LLMを評価者として使う」方法も提案されています。これは「LLM-as-a-Judge」という考え方で、大規模な言語モデルをジャッジとして活用し、他のモデルが生成した回答の質を判断させるというものです。これにより、より一貫性のある評価指標が得られるうえ、人手に頼ること無く大規模なテストデータの自動評価が可能になります。

Amazon Bedrock上での評価ワークフロー

Amazon Bedrockで生成AIのカスタム評価を行うためのプロセスは以下の通りです。

1. 評価シナリオの定義:

テストするユースケースを明確にし、評価対象とする入力(プロンプト)と期待する出力を定義します。

2. テストデータと期待回答(ゴールドスタンダード)の作成:

多くの場合、複数の参考回答や典型的な誤回答も用意しておくと評価の信頼性が向上します。

3. Amazon BedrockのEvaluatorを用いた自動実行:

Bedrockが提供する”model evaluation”機能では、指定したモデルに対して、指定した評価ロジックを用いて統一的に複数のデータセットを評価できます。

4. 結果の可視化:

評価結果は、Amazon CloudWatch や Amazon Athena、QuickSightなどと連携することでダッシュボード化され、視覚的に性能を分析することができます。

カスタム評価の活用事例

あるeコマース企業を想定すると、以下のようなカスタムメトリクスが考えられます:

– 応答時間の短さ

– 制約された語彙やガイドラインの遵守(例:敬語や商品名の表記統一)

– 不適切な返答の有無(例:「在庫あります」と誤って回答しないこと)

これらの評価は、既存の自動テストツールでは難しい部分であり、Bedrockの評価機能とカスタムメトリクスならではの柔軟性が活きる場面です。

さらに、異なる基盤モデル間の比較も容易なため、「どのFMが自社サービスに最も適しているか」という観点での選定にも活用できる点は、多くの企業にとって有益なポイントです。

継続的な品質改善への応用

生成AIのプロダクトは、一度開発しただけでは完成しません。ユーザー体験を向上させ続けるためには、継続的な評価と改善が不可欠です。Amazon Bedrockでは、これらのプロセスを自動化し、CI/CDパイプラインと統合することで、評価から修正、再デプロイまでを一連のフローとして構築できます。

また、Bedrock APIと連携して、日々のユーザーインタラクションから高品質なデータを収集することで、自社独自の評価基準モデルを強化することも可能です。

まとめ

生成AIの活用はますます広がりを見せており、それとともにユーザーの期待値も高まっています。ただ「コンテンツを生成できること」以上に、「正確で信頼されるコンテンツが提供されること」がビジネスにとっては重要です。

Amazon Bedrockは、複数の基盤モデルへのアクセスだけでなく、それを品質管理するための堅牢なカスタム評価基盤を提供しています。特に「自社のユースケースに即した評価ができる」という点で、生成AIを本番運用する企業にとって非常に心強い存在です。

カスタムメトリクスを用いた評価アプローチを採用することで、ユーザーが本当に求めている品質の生成AIサービスが実現され、より優れた顧客体験とブランド信頼の構築へと繋がっていくでしょう。今後、生成AIを用いたアプリ開発に携わるすべての技術者にとって、この評価手法の理解と実装は不可欠なスキルとなることが期待されます。