近年、ChatGPTやCopilotといった大規模言語モデル(LLM:Large Language Model)は、ソフトウェア開発、創作活動、ビジネス文書の自動化といった分野で爆発的に普及しています。しかしその一方で、サイバーセキュリティという極めて重要な分野におけるLLMの応用は、まだ十分に進んでいないのが現状です。

この流れを変えるために登場したのが、「Foundation-Sec-8B」という最新のLLMです。本モデルはMetaが開発したLlama 3.1アーキテクチャをベースにしており、特にサイバーセキュリティ分野に特化して強化学習されたのが特徴です。今回の技術報告書では、このFoundation-Sec-8Bの性能や技術的意義について詳細に解説されています。

■ Foundation-Sec-8Bとは何か?

Foundation-Sec-8Bは、パラメータ数が約8B(80億)という中規模な大規模言語モデルです。基盤となったLlama 3.1は、その高い言語能力と計算効率性で知られており、これにサイバーセキュリティ関連の知識を注入する形でさらなる性能向上が図られました。

具体的には、以下のような領域に対応しています:

– マルウェア分析

– ネットワークトラフィックの解析

– セキュリティアラートの分類

– 脆弱性(CVE)の特定と要約

– 悪意のあるコードの検出

– セキュリティポリシー文書の理解と生成

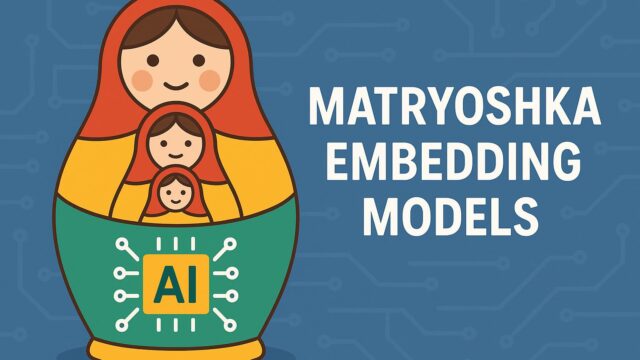

ここで重要なのは、汎用的なモデルでは得られにくい「セキュリティ分野固有の知識」がしっかりと前提学習(pretraining)されているという点です。これは医療や法律など、他の「専門知識を要求する分野」との類似性も感じさせます。

■ 学習データと技術的工夫

通常のLLMは、Webから取得した汎用的な膨大なテキストを学習しますが、Foundation-Sec-8Bはこれに加えて、セキュリティ専門の文書やベンチマークデータ、掲示板上のセキュリティ分析、CVEデータベース、学術論文などを独自にキュレート・拡張し、モデルに学習させています。

これは極めて重要な点で、一般的なWebテキストでは得られない、

– マルウェア検体の特徴解析

– バイナリ構造の理解

– 攻撃ベクトルのパターン

– セキュリティ・イベントの時系列的因果関係

といった定量的・構造的な知識の獲得を目指しているところが、従来モデルとは一線を画しています。

さらに、モデルの評価には従来の自然言語推論のベンチマークだけでなく、セキュリティ分野で実際に使われる以下のような課題セットを採用しています:

– CyberSecEval:セキュリティ固有の質問応答テスト

– CVE-QA:脆弱性に基づいた説明生成とリスク分析

– Code-Injection Detection:コードベースの攻撃特定

– Threat Intelligence QA:セキュリティレポートの要約と復号

こうしたタスクで、Foundation-Sec-8BはLlama 3.1-70B(なんとパラメータ数が約9倍!)や、OpenAIのGPT-4o-miniに匹敵、あるいは上回る結果を達成しています。これは、モデルサイズよりも専門的な知識の「深さ」が重要であることを示す好例です。

■ セキュリティ分野への波及効果とは?

技術的な観点からみても、このモデルの意義は多岐にわたります。例えば:

● セキュリティオペレーションセンター(SOC)での活用

リアルタイムのログ監視や、異常な挙動の検出といったセキュリティ運用の自動化に使われれば、人的負荷の軽減やインシデントの早期発見に大きく貢献できます。

● 自動コードレビューや脆弱性チェック

生成AIがコードを書くだけでなく、それをセキュリティの観点でレビューし、危険箇所を指摘したり修正案を提示する「AIコードセキュリティ監査員」としても期待できます。

● インシデント対応レポートの効率化

多くのセキュリティ専門家が苦労する、攻撃の分析や対策の報告書作成において、LLMが自然言語でわかりやすくまとめる手助けを行えるようになります。

■ 今後の課題と展望

とはいえ、Foundation-Sec-8Bが万能だというわけではありません。その弱点もいくつか予想されます:

– モデルの設計上、事実の正確性や最新情報の反映に不確実性がある

– 学習データの偏りが攻撃検知の誤判定につながる恐れ

– 利用環境での機密情報や実データとの連携方法に課題がある

特にセキュリティという分野は直接的に命や国の安全に関わるため、AIによる「説明可能性」や「トレーサビリティ」が不可欠になります。つまり、モデルがどんな根拠で判断を下したのか、追跡して確認できることが大切です。

その意味で、オープンに公開されたFoundation-Sec-8Bは非常に希望の持てる存在です。研究者のみならず、企業のセキュリティ部門やインシデントレスポンスチームなど、幅広いユーザーがこのモデルを自由に評価・導入・改善できる土壌が今、整いつつあります。

■ 結論:AIはセキュリティの「敵」ではなく「盾」になる

サイバー空間では、常に新しい攻撃手法が生まれ、その対応に人間だけで追いつくのは困難になっています。その点、このような専門領域に特化したLLMの登場は、AIがセキュリティ分野において「使える道具」へと進化し始めている証といえます。

単なるジェネレーティブなテキスト生成から、実務的かつ高度な「分析力」を備えたAIへ。Foundation-Sec-8Bは、その転換点になる可能性を秘めたモデルです。今後、より多くの専門業界向けAIが生まれるきっかけと考えると、技術者にとっても見逃せないトピックといえるでしょう。