- Amazon: Raspberry Pi 5 8GB

- Amazon: NVIDIA Jetson Orin Nano Developer Kit

- Amazon: Natural Language Processing with Transformers(英語)

- 楽天: Raspberry Pi 5 8GB

- 楽天: NVIDIA Jetson Orin Nano 開発者キット

- 楽天: Natural Language Processing with Transformers(英語)

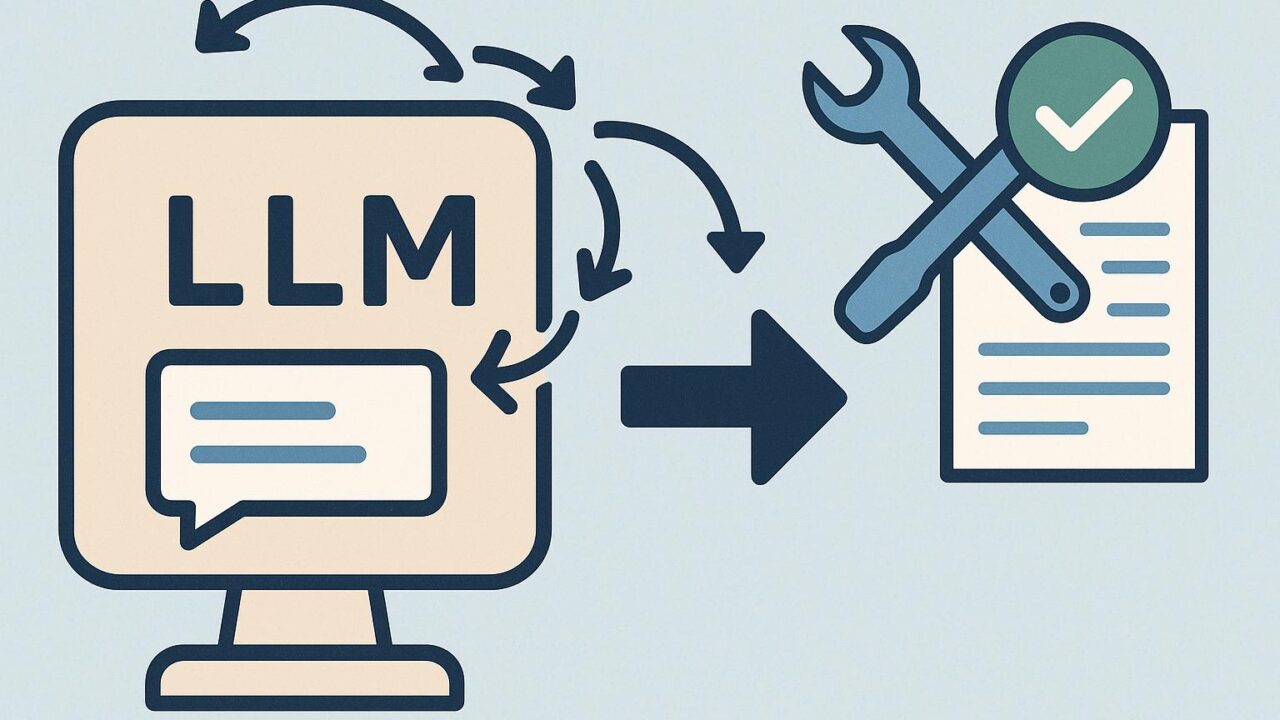

要旨:In-Tool Learningとは何か

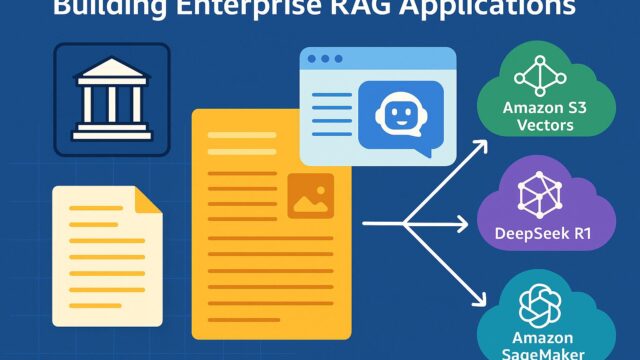

「In-Tool Learning(ツール内学習)」は、大規模言語モデル(LLM)がコード実行環境、検索・RAG、スプレッドシート、データベース、プランナーなどの外部ツールを使いながら、そのツールの中で得られるフィードバックを手掛かりに自分の振る舞い(プロンプト、サブポリシー、短期メモリ、ハイパーパラメータ)を段階的に適応させていく枠組みを指します。単なる「ツール呼び出し」ではなく、ツールが返す実行結果・エラー・スコアを利用して次の試行をより良くする点が特徴です。

論文タイトルが示すポイント(直感的な読み解き)

- 多段タスクでの誤り伝播を抑える:段階ごとにツールから得る客観的なシグナル(テスト通過/失敗、照合一致、コスト、制約違反)で探索を修正できるため、初期の小さなミスが後段で肥大化するのを抑制できます。

- サンプル効率の改善:同分布のタスクを繰り返すうちに、ツール内の短期メモリやルールが洗練され、少ない試行で正解に到達しやすくなります(メタラーニング的な効果)。

- 計算資源の活用でモデルの負担を軽減:プログラム実行や検索など計算の重い部分をツールにオフロードできるため、LLM自体を過度に巨大化させなくても高精度化が可能になります。

- 安全性・堅牢性の向上余地:ツールからの検証機構(型チェック、ユニットテスト、ルールエンジン)を組み合わせることで、生成の暴走や幻覚の影響を検出・是正しやすくなります。

「ツールを使う」と「ツール内で学ぶ」の違い

- ツール使用のみ:プロンプト→ツール呼び出し→結果取得、で一発勝負。改善ループは設計者側の手作業に頼りがち。

- ツール内学習:プロンプトやサブポリシーをツールの信号で自動微調整。失敗から次の一手が学習され、同様のタスクに再利用される。

身近なユースケース例

- コードエージェント:テスト結果と例外ログを根拠にパッチを自動反復。テスト通過率がステップごとに改善。

- RAG QA:検索ヒットの再ランキング精度を、引用整合性スコアで逐次補正。無関係文献の混入を抑制。

- 表計算アシスタント:関数提案の当たり外れをユーザ操作から学習し、部署固有の命名規則に短期適応。

実装のコア設計パターン

- 短期メモリ(Tool-local Memory):直近の成功プロンプト、良い中間解、禁止例をキャッシュ。キーはタスク特徴(API名、列名、ドメイン)。

- ツール原生の報酬設計:ユニットテスト合格数、正規表現マッチ、スキーマ検証、コスト制約など「数値化しやすい評価」を用意。

- 軽量な方策更新:バンディットやスコア付きテンプレート切替で、重い再学習なしに挙動を更新。

- 安全ガード:静的解析、型チェック、サンドボックス、レート制限を標準装備し、失敗からの学習と安全を両立。

- 観測と再現性:各ステップの入出力、採択/棄却理由、ツールの状態をログ化し、後から回帰検証できるようにする。

評価とチューニングの勘所

- リーク防止:テスト用の短期メモリをリセットし、真の汎化を確認。

- クレジット割当:どの更新が効いたかを分離評価(例:プロンプト改良 vs 検索クエリ改良)。

- 探索制御:試行回数の上限、早期打ち切り条件、コスト予算を明示的に設ける。

- ツール信頼度の差:不確実なツール(Web検索など)は、アンサンブルや再照合で頑健化。

すぐに始めるためのチェックリスト

- ツールが返せる客観評価(テスト、スキーマ検証、引用整合性)を先に整備。

- 成功/失敗例の短期メモリ設計(キー設計、TTL、サイズ上限)。

- 軽量更新の仕組み(テンプレートAB、スコア閾値、再試行ポリシー)。

- ログと再現パイプライン(ID、乱数種、ツール状態スナップショット)。

現場にもたらす実利

ツール内学習は、試行錯誤のたびに現場の文脈へ素早く適応し、運用初期の立ち上げコストを抑えつつ精度を引き上げます。特に、反復可能なワークフロー(QA、レポーティング、コード修正、データ整形)では、同種タスクが積み重なるほど効果が蓄積しやすいでしょう。短いループで「測る→直す」が回るため、モデルの大改造なしでもユーザ価値を着実に押し上げられます。

学習・検証を支えるおすすめ製品

ローカルでエージェントやツール連携の実験を回すなら、小型計算機が便利です。以下のリンクから入手できます。

- Amazon: Raspberry Pi 5 8GB(ローカルRAGや軽量モデルの実運用検証に)

- Amazon: NVIDIA Jetson Orin Nano Developer Kit(GPUが必要なエージェントの試作に)

- Amazon: Natural Language Processing with Transformers(英語)(Transformer理解と実装の基礎固めに)

- 楽天: Raspberry Pi 5 8GB

- 楽天: NVIDIA Jetson Orin Nano 開発者キット

- 楽天: Natural Language Processing with Transformers(英語)

ツール内学習は「実行結果に学ぶ」という非常に現場的な発想です。正確に測り、素早く直す。これを小さなループで積み上げる設計が、LLM活用の成功率を大きく引き上げます。自組織のツールやデータに合わせて、まずは評価軸と短期メモリから整えることをおすすめします。

- Amazon: Raspberry Pi 5 8GB

- Amazon: NVIDIA Jetson Orin Nano Developer Kit

- Amazon: Natural Language Processing with Transformers(英語)

- 楽天: Raspberry Pi 5 8GB

- 楽天: NVIDIA Jetson Orin Nano 開発者キット

- 楽天: Natural Language Processing with Transformers(英語)