- Amazon: ゼロから作るDeep Learning 1 / 機械学習デザインパターン / 機械学習のための特徴量エンジニアリング

- 楽天: ゼロから作るDeep Learning 1 / 機械学習デザインパターン / 機械学習のための特徴量エンジニアリング

要点まとめ:予測型ML × 生成AIエージェントを現場で使う

大規模言語モデル(LLM)を使ったエージェントは、検索やデータベース照会、ツール実行など外部機能を呼び出すことで真価を発揮します。特にビジネスでは、チャーン予測、需要予測、リスクスコアリングなどの予測型機械学習(ML)が意思決定の要です。本稿では、Amazon SageMaker AIでホストした予測モデルを、Model Context Protocol(MCP)を使ってAIエージェントから安全・一貫・再利用可能に呼び出すアーキテクチャと実装の勘所を解説します。

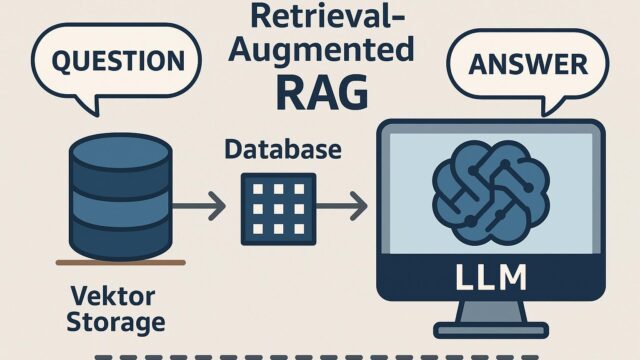

MCPとは何か:ツール接続の標準プロトコル

MCPは、エージェントと外部ツール・データソースを結ぶためのオープンなプロトコルです。クライアント(エージェント)側から見ると、ツールの機能や入出力スキーマが標準化されており、どの実装でも同じ手順で呼び出せます。サーバー(ツール)側は、実体がRESTでもSDKでも構いません。つまり、SageMakerの推論エンドポイントをMCPサーバーでラップすれば、さまざまなエージェント環境から同じ手順で予測機能を使えます。

全体アーキテクチャ

- エージェント(LLM)… ユーザー要求を理解し、必要に応じてツールを選択。

- MCPクライアント… エージェントがMCPツールを呼び出す実行レイヤー。

- MCPサーバー… 「需要予測」「チャーン確率推定」などのツールを定義。背後でSageMaker推論を実行。

- Amazon SageMaker AI… 学習済みモデルをリアルタイム推論エンドポイントとして提供。監視・スケーリング・セキュアな実行を担保。

実装の流れ(現場で外さない5ステップ)

- モデルを用意:SageMaker JumpStartや独自学習でXGBoostやTabTransformerなどをデプロイ。入力特徴量と出力スキーマ(例:{customer_id, features[]}→{churn_probability})を明文化。

- MCPサーバーを実装:Python/Node.jsなどで、ツール名(predict_churn等)、引数(JSON Schema)、戻り値(JSON)を定義。内部でboto3/SDKによりSageMaker Runtimeへリクエスト。タイムアウト、再試行、エラー整形を実装。

- 認証とネットワーク:最小権限のIAMロールを割り当て、必要ならVPC内エンドポイントで閉域化。環境変数や認証情報管理(AWS Secrets Manager)を徹底。

- エージェントのツール選択:プロンプト内で「この状況では予測ツールを使う」基準を明記。入力前処理と後処理(数値の丸め、単位、閾値判断)も記述し、一貫した判断を促す。

- 観測・改善:CloudWatchでレイテンシ・エラー率を監視。フィーチャードリフト検知、モデルバージョニング、カナリアデプロイ、A/Bで品質を継続評価。

ユースケース別の設計ポイント

- チャーン予測:出力は確率だけでなく「主要寄与要因(SHAP等)」も返すと、エージェントが解約抑止施策を自然言語で説明しやすい。

- 需要予測:区間予測(上下限)を返して在庫判断の不確実性を提示。閾値に応じて追加発注やプロモ提案まで自動化。

- 与信・不正検知:レイテンシ重視ならサーバーレス推論やマルチモデルエンドポイントでコスト・性能のバランスを最適化。

品質と信頼性を高めるベストプラクティス

- スキーマ駆動:MCPツールの引数・返却値をJSON Schemaで厳格化。バリデーションに通らない入力は即座にリカバリ。

- 決定ログ:どのツールをいつ・どの入力で呼んだか、推論IDと合わせて追跡可能に。監査・再現性に直結。

- フェイルセーフ:推論不可時はエージェントが代替案(経験則の目安や追加データ要求)を提示するガードレールを用意。

- コスト管理:キャッシュやバッチ推論の併用、Auto Scalingの上限設定で運用コストを見える化。

最小サンプルの設計イメージ

ツール名:predict_demand

入力:{ sku, store_id, horizon, context_features }

戻り値:{ point_forecast, lower, upper, model_version }

プロンプト方針:

・意思決定前にhorizonと在庫制約を確認

・不確実性が大きい場合は追加データを要求

・返答は根拠(予測要因)と共に簡潔に

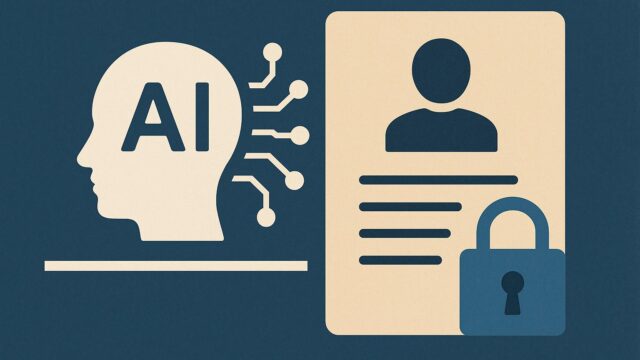

セキュリティとプライバシー

- PIIはMCPサーバー側でマスキングし、必要最小限の特徴量のみ推論に送付。

- KMSによる暗号化、IAM最小権限、VPCエンドポイントでの閉域化。

- プロンプトに機密を含めない運用ルールと自動検出(DLP)の併用。

まとめ:エージェントに“意思決定の芯”を与える

生成AIは表現力に優れますが、ビジネス判断の芯は予測型MLが担います。Amazon SageMaker AIにホストしたモデルをMCPで標準化すれば、複数のエージェントやアプリから同じ品質で再利用でき、保守も容易です。スキーマ駆動・監視・バージョニングの基本を押さえ、まずは単一ユースケースから小さく始めて育てていきましょう。

学習と実装を加速するおすすめ書籍

- Amazon: ゼロから作るDeep Learning 1 / 機械学習デザインパターン / 機械学習のための特徴量エンジニアリング

- 楽天: ゼロから作るDeep Learning 1 / 機械学習デザインパターン / 機械学習のための特徴量エンジニアリング