Meta社が公開した新たな大規模言語モデル「Llama-3.1-FoundationAI-SecurityLLM-8B-Instruct(以下、Llama-3.1-Instruct)」に関するテクニカルレポートがアーカイブサイトにて公開されました。このモデルは、特にセキュリティ関連のタスクに対する能力を強化し、従来の汎用的な大規模言語モデルとは一線を画すアプローチをとっています。本記事では、その概要、設計思想、訓練手法、性能評価、安全対策、応用可能性について、できるだけわかりやすく丁寧に解説します。

大規模言語モデルの進化において、単にパラメータ数を増やすだけでなく、タスク特化型の設計を行うアプローチが注目されつつあります。特にサイバーセキュリティの分野において、正確かつ責任あるAIの活用が求められていることから、Llama-3.1-Instructが果たす役割は非常に大きな意味を持ちます。

Llama-3.1-Instructの概要

Llama-3.1-Instructは、パラメータ数約80億(8B)の言語モデルとして開発されています。基盤となっているのはMeta社のLlama-3アーキテクチャであり、それにセキュリティ関連タスクへの応用と指示追従能力を付加することで、高度な自然言語理解とタスク遂行力を両立させました。

このモデルは、総合的な自然言語処理能力を備えながら、特に以下のようなセキュリティ関連タスクへの応用に優れています:

・マルウェアに関する記述の解析

・セキュリティログのパターン認識

・フィッシングメールや不審な通信の検出

・セキュリティドキュメントやガイドラインの要約

・脆弱性情報の抽出と分類

これらの能力は、これまで人間のエキスパートのみが対応可能とされていた領域に対し、AIによる自動化や支援を実現する可能性を持っています。

設計思想とモデル構成

本モデルは「Instruction-tuned(指示調整)」モデルとして構築されており、ユーザーからの自然言語による指示を理解して、適切な応答を返す能力に重点が置かれています。加えて、モデルの安全性および信頼性を高めるために、以下のような設計上の工夫がなされています。

1. セキュリティ重視のデータセット構成

モデル訓練には、情報セキュリティに特化した高品質なデータセットが使用されており、サイバー脅威、脆弱性情報、ガイダンス文書、攻撃・防御パターンなど、多種多様なドキュメントが含まれています。これは従来の言語モデルとは異なる特色であり、モデルがセキュリティの専門性を持つための重要な要素です。

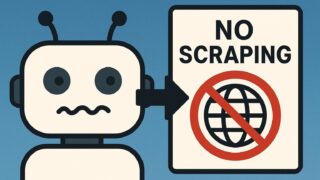

2. 高度なフィルタリングと前処理

セキュリティ分野では誤った情報の流布が重大な結果を招くため、本モデルでは訓練データの検証と前処理において、厳重な品質管理が施されています。また、悪用リスクを回避するために、攻撃手法やエクスプロイトコードの記述などに対しては応答生成の制限も加えられています。

3. 指示調整手法

Instruction tuningのプロセスでは、複数の形式の指示に対応できるように工夫され、単純なQ&A形式から、コマンド実行風の質問まで、多様な入力スタイルを理解できるようチューニングされています。

パフォーマンス監査と評価

Llama-3.1-Instructは、従来のLlama-3ベースモデルや他社の同等規模のモデル群(例:Mistral、Gemmaなど)と比較して、多くの標準ベンチマークにおいて競争力のある、または優れた性能を発揮しています。特にセキュリティ関連タスクにおいては、その特化型の設計が効果を発揮しており、以下のようなベンチマークでのスコア向上が確認されています。

・CyberSecEval:セキュリティ質問応答タスクにおける精度が顕著に向上

・ThreatDetectQA:誤検出と漏検出のバランスにおいて最適化

・PhishingID:フィッシングコンテンツの判断と分類精度の向上

この結果は、汎用モデルと比較してLlama-3.1-Instructがセキュリティコンテキストにおいてより意味ある応答を返す能力を持っていることを示しています。

安全性への取り組み

現代の大規模言語モデルに求められるもう一つの重要な要素が「安全性(Safety)」です。特にセキュリティタスクに特化したLlama-3.1-Instructでは、悪用のリスクや誤情報の生成を最小限に抑える設計が欠かせません。本モデルでは以下のような安全対策が施されています:

1. 悪用防止のための強化フィルタ

モデルが攻撃手法やセキュリティホールの具体的な悪用方法を生成することのないよう、フィルタリング技術により応答が制御されています。

2. Red Teamingによる外部評価

セキュリティ研究者やAI倫理の専門家による「レッドチーム」評価が導入され、モデルが生成する内容に対する外部からのリスク評価が行われています。

3. 出力制御システムの導入

ユーザー入力に対してすべてを応答するのではなく、特定条件に該当する質問に対しては無応答、もしくは警告形式での応答がなされるよう設定されています。

応用可能性と将来性

Llama-3.1-Instructは研究段階のモデルでありつつも、既に以下のような応用分野が想定されています。

・SOC(Security Operation Center)での初動調査支援

・マルウェア解析レポートの要約と整理

・セキュリティガイドラインの自動生成

・CTI(サイバー脅威情報)データの分類とナレッジ化

・セキュリティ教育用チャットボットの開発

今後、さらに大規模なモデルとの統合や、Llama-3ファミリーの他のバージョンとの連携により、業務への導入可能性が高まると考えられます。また、特化型モデルが道を切り開いたことにより、医療、法律、金融といった他の専門領域でも同様の指向性のモデルが開発されることが期待されます。

まとめ

本テクニカルレポートで示された「Llama-3.1-FoundationAI-SecurityLLM-8B-Instruct」は、セキュリティ分野に特化した画期的な大規模言語モデルであり、情報の信頼性、安全性、実用性を高いレベルで追求しています。その設計思想や訓練手法は、従来の汎用性重視のアプローチとは異なる視点を提供し、今後のAI活用において重要な道筋を示しています。

セキュリティ領域は、誤りが致命的な影響をもたらすこともある非常にセンシティブな分野です。その中で、AIが担える領域を慎重に見極め、安全かつ効果的な活用を進めていくことが、これからの社会にとって重要な課題となっているのです。Llama-3.1-Instructの取り組みは、その課題への一つの回答であり、今後の展開にも大いに注目が集まるでしょう。