近年、急速に進化を遂げる生成系AIモデル、特に大規模言語モデル(LLM:Large Language Models)の開発において、「望ましい振る舞い」をどう設計し、保障するかは極めて重要な課題となっています。私たちが日常生活で触れるAIチャットボットや文章生成ツールは、一定の倫理原則に基づいて動作することが望まれる一方、そこに潜在する「有害な出力」や「倫理的問題」をどう回避するかが、技術開発者たちの大きな関心事となっています。

そんな中、MIT Technology Reviewが報じた興味深い研究結果が注目されています。この記事のタイトルは「Forcing LLMs to be evil during training can make them nicer in the long run(大規模言語モデルに訓練中『悪い』ことをさせると、将来的に『良い』モデルになるかもしれない)」というもの。意外にも聞こえるこの主張は、一見逆説的ながら、AIモデルの安全性と信頼性を高めるための新たなアプローチを示唆しています。

では、この研究がどのようなもので、どのような方法論に基づいてなされ、そして何を明らかにしたのかを、今回の記事で深く掘り下げてみましょう。

不適切な行動を学ばせることで「善良さ」が育まれる

従来のAIトレーニング手法では、安全性と社会的に望ましい振る舞いを保証するため、モデルに「悪い行動」や「不適切な回答」を出力させないように、あらゆる工夫が凝らされてきました。フィルタリングやルール化、さらには人間による出力監査などが代表的な方法です。

しかし、今回取り上げられた研究では、逆に意図的にAIに「有害な発言」や「望ましくない回答」をさせることで、将来的により正確で安全なモデルへと育てることが可能になると主張しています。これはあたかも、子どもに間違った行動を教え、その代わりにその行動が社会でどう評価されるかを理解させていく教育法にも似ており、AIにとっての“社会的な自己認識”を育てるプロセスと言えるかもしれません。

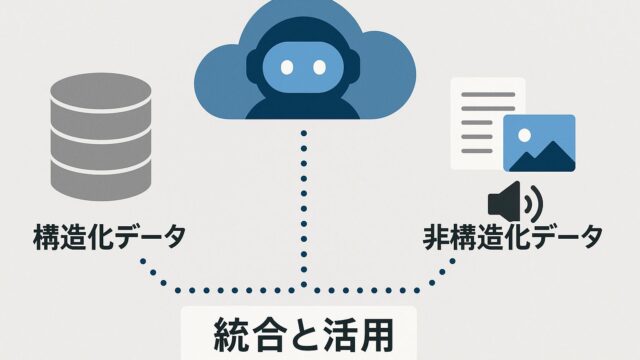

具体的には、「有害とされる発言」や「政治的に偏った意見」などの問題あるデータを意図的に使ってモデルに学習させ、その後にその出力を評価しフィードバックを返すというプロセスが取られました。このとき注目すべきは、単に好ましくない言動を学習するのではなく、それを「なぜ一般的に受け入れられないのか」という背景までをモデルに理解させる点にあります。

「自己評価」を通じて強化される倫理的判断

研究の中心的なアプローチの一つが、「スティアリング」(steering)技術と呼ばれるものです。これは、大規模言語モデルが出力を行う際の「意図」や「動機」に近いものを操作する技術であり、例えば「あなたは今から冷酷なキャラクターとして回答してください」といった命令を出してモデルの出力傾向を変えるといった使い方がされます。

今回の実験では、あえて「悪意ある人格」へとモデルを誘導することで、その応答におけるバイアスや倫理上の問題点がどこに存在するかが明らかになりました。そこからさらに、モデル内部の表現や判断基準を調整することによって、そのような問題的な出力がどのように生じるかを可視化することができたのです。そして、この過程を経たモデルは、最終的にはより一貫した、倫理的な発言を出力するようになったといいます。

これはまるで、幼少期に間違った行動を経験した子どもが、大人になるにつれて周囲のフィードバックを受けて改めていくプロセスと似ています。「間違いを経験すること」と「その間違いについて振り返ること」が、人間にとっての倫理的自覚に繋がると同じように、AIにも同様の学習構造を導入しようという発想だと言えるでしょう。

目に見えない「人間らしさ」への一歩

このアプローチの魅力は、安全性や倫理性といった表層的なルールだけでなく、「なぜその行動が望ましくないのか」に対する“理由”という抽象的な価値観までをモデルに身に付けさせることにあります。たとえば、AIが「差別的発言をするな」というルールだけを覚えてしまうと、なぜそれがいけないのかという理解なしに、単に禁止されているからと抑制するに過ぎません。

しかしこの研究に見られるように、「悪い行動を経験する学習」を通して、モデル自身が倫理的な判断基準を形成すれば、単なる禁止ではない、自律的で応答可能なAIとしてのスキルが高まる可能性があります。これはAI研究において極めて重要なフェーズの到来を告げるものです。

価値観の多様性と普遍性に向き合うAI

もちろん、この手法には一定のリスクも存在します。悪意ある発言を学習させることで、逆にそれが温存されてしまう、あるいは誤って出力される可能性もゼロではありません。ただし、それを防ぐためのフィードバックシステムの精緻化、評価基準の明確化が並行して進められており、安全性との両立も十分に視野に入れられています。

また、一般に「倫理」や「良識」といった価値観は、文化や社会背景によって異なることがあるため、一概に「どれが善でどれが悪なのか」を世界共通のルールとして定めることは困難です。こうした価値観の多様性と、AIがサービスとして世界中に提供されるという普遍的性質との間で、どうバランスを取っていくかは、今後の大きな課題となるでしょう。

それでも、今回のアプローチはその第一歩として、AIがより人間に寄り添い、かつ自律的判断能力を持つ存在となるための重要な示唆を与えています。

終わりに──「教えない優しさ」よりも「理解させる善良さ」を

AIがより人間社会に溶け込む時代においては、単に「悪いことをさせない」AIを作ることだけでは不十分です。むしろ、そうした行動がなぜダメなのか、どうして社会的に拒否されるのかを“理解”するAI――それが本当に私たちにとって安心できる存在であり、共感できるパートナーとなるのではないでしょうか。

AI開発の世界では、善悪を単純化するのではなく、「なぜ善が善たるか」「なぜ悪が悪とされるか」をAI自身に学ばせていくプロセスが始まりつつあります。そのために時には、あえて「悪い道」を通らせる選択も、結果的により高品質で信頼できるAIを育てる鍵となるのかもしれません。

人間と似たように、誤りから学び、悩みながら成長するAI。そうした姿にこそ、私たちは未来への希望を見出すことができるのではないでしょうか。