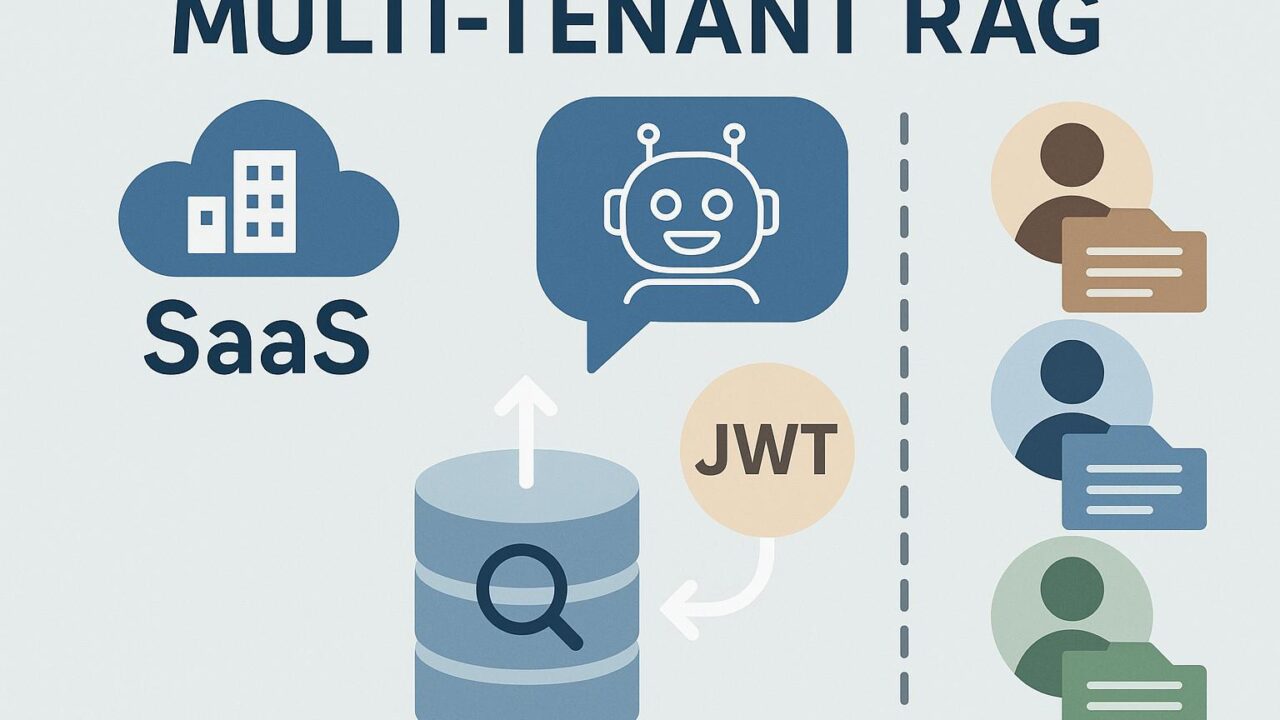

SaaSにおけるマルチテナントRAG実装:Amazon BedrockとAmazon OpenSearch Service、JWTを活用した最新手法

急速に進化するクラウド業界では、あらゆる規模の企業が生成AIの可能性に注目し、それを自社のサービスに活用しようとしています。特に、SaaS(Software as a Service)プロバイダにとっては、個々のテナント(ユーザー)に対してパーソナライズされたAI体験を安定して提供することが大きな課題ですが、同時に競争優位性を築く上での重要な鍵でもあります。

Amazon Web Services(AWS)が提唱した「Multi-tenant RAG(Retrieval-Augmented Generation)」の最新事例では、Amazon Bedrock、Amazon OpenSearch Service、そしてJWT(JSON Web Token)を組み合わせることで、拡張性が高く安全性にも優れたマルチテナント型RAGアーキテクチャを構築しています。本記事では、マルチテナント環境におけるRAG実装の核心部分を掘り下げつつ、その利点、構成要素、ユースケースについて詳しく解説していきます。

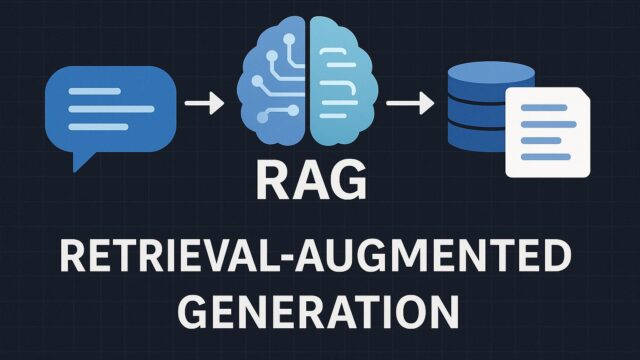

RAGとは何か?なぜ重要なのか?

RAGとは、Retrieval-Augmented Generationの略称で、検索ベースの文書取得と生成AIを組み合わせた仕組みです。通常の生成型AIモデル(たとえば、大規模言語モデル)は、その事前学習データをもとに応答を生成しますが、情報が最新でなかったり、特定ドメインに特化していない場合があります。

その点、RAGでは、まず検索エンジンを用いて関連文書を外部リソースから取り出し、次にそれらをAIモデルに渡して応答を生成させるため、ドメイン固有の知識や最新情報に基づいた正確で信頼性の高い生成が可能になります。

SaaSプロバイダにとって、RAGは顧客ごとに独自の知識データを参照しながら、自然言語による柔軟な対話を実現できるため、カスタマーサポートやヘルプデスク、コンサルティング自動化などに非常に有効とされています。

マルチテナンシーに特有の課題

SaaSサービスでは一般的に、複数の顧客(テナント)が同じインフラ上でアプリケーションを共有する「マルチテナント」の設計が採用されます。この方式はコスト効率とスケーラビリティに優れていますが、一方でセキュリティ、データ隔離、認証といった観点での工夫が必要不可欠です。

特にRAGシステムをマルチテナント環境で運用する際、各テナントのデータを確実に分離し、他の顧客からアクセスできないようにする必要があります。また、問い合わせに対して正しい知識ベースから回答を引き出すためには、ユーザーの所属するテナントを正確に識別し、関連するドキュメントのみに絞って検索結果を返す機構が求められます。

Amazon Bedrock、Amazon OpenSearch Service、JWTの統合による解決策

そこで、AWSでは以下の3つの要素を組み合わせて、マルチテナント対応のRAGアーキテクチャを提案しています。

1. Amazon Bedrock:フルマネージドの生成AI基盤

Amazon Bedrockは、主要な生成AIモデル(Anthropic Claude、Meta Llama 2、Mistral、Cohereなど)をAPI経由で利用可能にするサービスです。このため、インフラ管理やモデルのトレーニングなしに迅速なAI導入が可能です。Amazon Bedrockにより、一貫した生成プロセスと高い信頼性のもとで、テナントごとのカスタマイズも柔軟に行えるようになります。

2. Amazon OpenSearch Service:高性能検索エンジン

OpenSearchは、膨大なデータから関連性の高い情報を高速かつスケーラブルに検索できるエンジンです。マルチテナント環境では、インデックスをテナントごとに分離したり、ドキュメントレベルでのフィルタリングを行ったりすることで、データの隔離性とアクセス制御を担保することが可能です。

3. JWT(JSON Web Token):認証と認可の中心

JWTは、ユーザーの認証情報や属性を安全にトークン形式で渡す仕組みです。RAGプロセスにおいては、JWTからテナントIDを抽出し、それをもとに検索対象を限定したり、モデルに伝えるプロンプトに組み込んだりと、個別対応が実現されます。さらに、JWTによる認可ロジックを統合することで、ユーザーごとのアクセス制御を厳密に管理できます。

RAGワークフローの全体像

このアーキテクチャをもとにしたRAGシステムは、大まかに以下のような流れで構成されています。

ステップ1:ユーザーが自然言語による質問を送信(JWT含む)

SaaSアプリケーションの利用者が問い合わせを入力すると、フロントエンドでJWTが付与され、質問と共にバックエンドに送信されます。

ステップ2:JWTの検証とテナントID抽出

バックエンドでは、JWTの検証を行い、そこからテナント識別子(tenant_id)を抽出して、以降の処理に活用します。

ステップ3:OpenSearchから関連文書を取得

OpenSearch Serviceに対して、tenant_idでフィルターした状態で質問に関連する文書を検索します。これにより、他テナントの情報が検索対象になるリスクを排除しています。

ステップ4:Bedrockにプロンプトとコンテキストを渡して応答生成

得られた文書をコンテキストとしてAmazon BedrockのAIモデルに入力。ユーザーの質問を自然言語形式でプロンプトに組み込み、生成された回答を得て、ユーザーに返却します。

この一連の流れにより、各テナントにとって最も適した情報にもとづいた高品質なレスポンスを提供することができます。

開発者向けの実装ポイントと工夫

構築の中で特に開発者にとって有益な技術要素として以下が挙げられます:

・OpenSearchのIndex AliasとDocument Filtering:

テナントごとのデータ隔離は、物理的にインデックスを分割する方法だけでなく、索引エイリアスを使って論理的に分離しつつ、柔軟なルーティングを実現できます。また、文書レベルの属性(たとえば”tenant_id”フィールド)で検索結果をフィルタリングすることで、さらなる安全性と効率を得られます。

・JWTのカスタムクレーム活用:

JWTには標準的なフィールド(iss、sub、expなど)に加えて、カスタムクレームを追加することができます。テナント情報やユーザーのロール情報など、必要に応じてクレームを拡張することで、用途に応じたきめ細やかな認証・認可が実現できます。

・ベクトル検索とセマンティック検索:

OpenSearchでは、テキストをベクトル形式で検索できる機能(k-NNアルゴリズムなど)をサポートしています。これを活用することで、「キーワードベースの検索」だけでなく、「意味的に関連のある情報」の取得が可能となり、AIモデルの自然言語処理能力と高い親和性を示します。

主なメリットとSaaSプロバイダへの利点

・コスト効率の良いスケーラビリティ:BedrockとOpenSearchはフルマネージドで拡張性に優れ、SaaSサービスの規模が拡大しても堅牢な基盤を維持できます。

・セキュアなマルチテナント対応:JWT認証とOpenSearchのデータ隔離により、テナントごとのセキュリティが確保された安心設計です。

・時間とリソースの節約:ゼロから独自のモデル構築や検索エンジン開発をする必要がなく、開発チームはアプリケーションロジックに集中できます。

・パーソナルでインテリジェントなユーザー体験:各顧客の文脈に応じた応答を提供することで、エンドユーザーにとって役立つ知識サービスを生成できます。

まとめ:次世代SaaSにおける生成AIの道しるべ

マルチテナント環境におけるRAGの実装は、ただ単に生成AIを「導入する」ことではなく、いかにして「各顧客に合わせた価値ある知識体験を提供するか」という視点が重要です。

Amazon Bedrock、OpenSearch Service、JWTというAWSの先端テクノロジーを組み合わせることで、その高い拡張性、安全性、そして柔軟性を兼ね備えた形で、未来のSaaSにふさわしいAIプラットフォームの姿が具体化されています。

企業が自社のサービスにAIを取り入れる際、本記事で紹介したアーキテクチャはその一つの参考モデルとなるでしょう。そして何より重要なのは、技術的な正確さに加え、ユーザーにとって誠実で信頼できるAI体験を提供するという姿勢です。

信頼性と効率性を両立させたこの最新手法は、今後のSaaS開発に新しい可能性をもたらしてくれるに違いありません。