生成系AIモデルを評価する新たなアプローチ:Amazon Nova LLM-as-a-JudgeとAmazon SageMakerの活用法

生成系AI、特に大規模言語モデル(LLM)の登場により、自然言語処理の世界は大きな変革を遂げています。文章の生成、要約、翻訳、質問応答など、さまざまなタスクにおいてこれらのモデルは著しい進歩を遂げつつあります。しかしながら、一つの大きな課題として、異なるLLMの性能をどのように一貫して正確に評価するかという問題が挙げられます。

このような背景のもと、AWSが提供するAmazon SageMaker上に構築された評価フレームワーク「Amazon Nova LLM-as-a-Judge」は、生成系AIモデルのパフォーマンス評価に関する新たなスタンダードとして注目を集めています。本記事では、このNova LLM-as-a-Judgeが果たす役割やその仕組み、活用方法について詳しく解説していきます。

LLMの性能評価における課題

生成系AIモデルを評価するというタスクは、分類や回帰のような従来型のモデル評価とは大きく異なります。これらのモデルは自由形式のテキストを出力するため、その評価には以下のような課題が伴います。

– 客観的なスコアリングが困難:正解が一つではない自由回答形式においては、モデルの出力が「どれだけ正しいか」あるいは「どれだけ自然であるか」といった評価が主観的になりがちです。

– タスクごとに基準が曖昧:要約タスク、翻訳タスク、対話型タスクなど、目的が異なれば「良い出力」の定義も変わります。

– 人間による評価のコストと時間:最終的には人間による評価が必要とされる場合が多く、そのためのリソースを確保するのには多大なコストが発生します。

これらの課題を解決するために誕生したのが、Amazon Nova LLM-as-a-Judge(以下、LLM-as-a-Judge)です。

LLM-as-a-Judgeとは何か?

LLM-as-a-Judgeは、その名の通り、生成系のモデル出力を評価するために訓練された大規模言語モデルです。評価対象となるモデルが生成した回答を、基準となる回答(リファレンス)などと比較し、どちらの方が望ましい出力であるかを判断する機能を備えています。

この構造自体が生成モデルであるため、単なるスコアを出すだけでなく、その判断理由まで自然言語で説明できるという利点があります。たとえば、「モデルAの出力がモデルBよりもより的確で情報量が多かったため、高評価を付けました」といった具合に、”ジャッジメント(判断理由)”を伴う形式で評価が返されるのです。

また、LLM-as-a-Judgeは複数の評価指標に基づいた比較が可能であり、以下のような観点での評価が行えます。

– 応答の正確性(Correctness)

– 応答の完全性(Completeness)

– 応答の自然さ(Fluency)

– 応答の有用性(Helpfulness)

– 応答の毒性レベル(Toxicity)

これにより、単一のスコアに依存することなく、多面的にモデルの性能を評価できます。

Amazon SageMakerでの展開

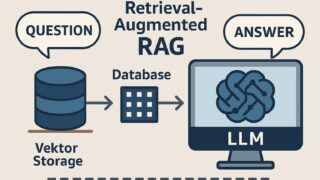

LLM-as-a-Judgeは、Amazon SageMaker上に展開することが可能であり、既存のMLワークフローに簡単に組み込めます。これにより、企業や開発組織は個別の生成モデルについて効率的に評価および比較を行うことができ、社内外の意思決定の質を高めることが可能になります。

特筆すべきは、この評価フレームワークがAmazon SageMaker JumpStartに統合されている点です。JumpStartは事前訓練されたMLモデルとテンプレートを提供するサービスであり、LLM-as-a-Judgeもテンプレートとして利用可能です。つまり、ユーザーは必要最小限のセットアップで、複雑な評価タスクを実行可能となります。

評価プロセスの具体的なステップ

LLM-as-a-Judgeを活用した評価プロセスは以下のようなステップで進みます。

1. 評価対象モデルの選定:

複数のLLM(例:モデルA・モデルB)の比較を行う場合、それぞれのモデルを推論できる環境を構築します。

2. 入力プロンプトの準備:

評価したいタスクに対する一貫性のある入力を用意します。翻訳文、対話プロンプトなど、タスクに応じた入力内容を準備します。

3. 各モデルによる応答生成:

入力プロンプトを用いて、各LLMに出力を生成させます。

4. LLM-as-a-Judgeによる評価リクエスト作成:

各モデルの応答とプロンプト情報を用いて、LLM-as-a-Judgeに「どの応答がより良いかを評価してほしい」とリクエストを送ります。

5. 評価結果の取得:

LLM-as-a-Judgeは自然言語で説明された評価結果を返します。さらに、必要に応じて評価理由も含まれるため、透明性の高い評価が実現します。

6. 分析と最適化:

評価結果を踏まえ、各モデルのパフォーマンスの相対的な差異を把握し、最終的な選定・改善に役立てます。

柔軟性とカスタマイズ性の高さ

LLM-as-a-Judgeのもう一つの強みは、その柔軟性にあります。特定のユースケースへの最適化やカスタム評価観点の追加も可能であり、自社独自の品質基準に基づいた再訓練も検討できます。

たとえば特定業界(法律、医療、金融など)に特化した言語スタイルや専門用語の理解が必要なモデル評価では、データセットを拡張して、より専門的な判断ができるように調整することも可能です。こういった機能の柔軟さは、現場のニーズに合った生成系AIの評価という点で大きなメリットとなります。

LLM-as-a-Judgeの活用によるメリット

LLM-as-a-Judgeの利用は、単にLLMのアウトプットを評価できるというだけでなく、以下のような実践的なメリットがあります。

– モデル選択の効率化:多数の候補モデルの中から、自動的かつ迅速に最適なモデルを評価して選定できます。

– 透明性と信頼性の向上:自然言語での評価レポートにより、誰もが判断根拠を理解できる透明性の高い環境が整います。

– テストの自動化とスケーラビリティ:従来の人手による評価から自動化されたプロセスへと移行できるため、大規模な評価も実現可能です。

– 品質向上のループ確立:評価により得られたフィードバックを活用し、モデルの改善サイクルを確立できます。

今後の展望と可能性

生成系AIとLLMの活用範囲は今後さらに広がっていくことが予想される一方で、それを安全かつ効率的に評価し、社会へ提供していくための取り組みもますます求められています。LLM-as-a-Judgeのようなツールが普及することで、モデルの品質管理が容易になり、信頼性の高いAIアプリケーションを構築できるようになるでしょう。

また、社内システムやプロダクトにLLMを導入する際にも、このような評価基盤があれば、エンジニアだけでなくプロダクトマネージャーやレビューアーなどの関係者が共通の基準を持って議論できるようになります。これはAI開発の透明性と説明可能性(Explainability)を高める上で非常に価値のあるポイントです。

まとめ

Amazonが提供するNova LLM-as-a-Judgeは、生成系AIの評価に革命を起こす仕組みとして、実用面でもアカデミック面でも注目されています。このソリューションを活用することで、従来は困難だった自由形式の応答評価がより正確かつ効率的に行えるようになり、AIシステムの信頼性と品質を大きく向上させることができます。

これから生成AIの社会実装がますます進んでいく中で、LLM-as-a-JudgeはAI開発者にとって不可欠な評価ツールとなることでしょう。Amazon SageMakerとの一体運用により、開発フローとスムーズに統合できる点もその大きな魅力の一つです。今後、LLM-as-a-Judgeのさらなる進化が、AI技術の持続可能な発展を後押ししてくれることに大いに期待が持てます。