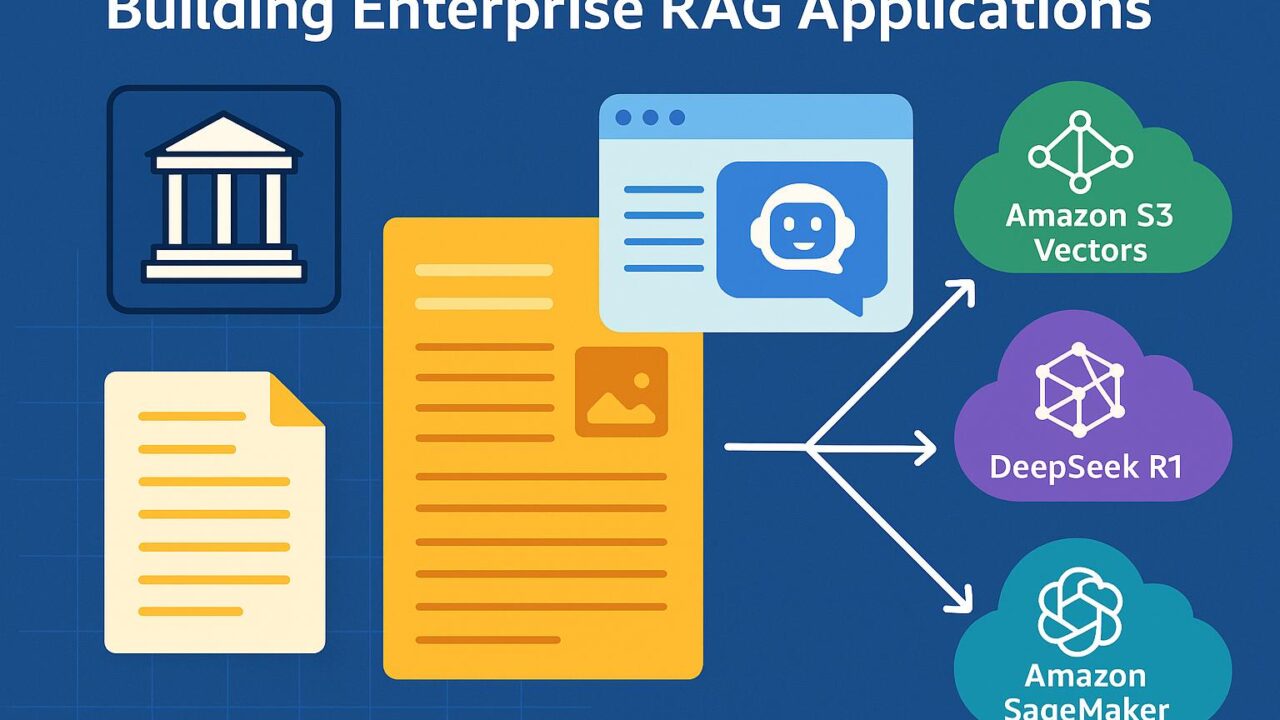

企業向けRAGアプリケーションの構築:Amazon S3 VectorsとDeepSeek R1、Amazon SageMakerを活用するアプローチ

近年、生成AIの活用は急速に進み、企業における業務効率化や知識共有の高度化に大きな貢献をしています。その中でも特に注目されている技術が、Retrieval Augmented Generation(RAG)です。RAGは、外部の知識ベースと大規模言語モデル(LLM)を組み合わせることで、より正確かつ信頼性の高い応答生成を実現します。一方で、企業規模のRAGアプリケーションの開発・運用には多くの課題が伴います。特に、データの規模、プライバシー保護、セキュリティ、パフォーマンス、コスト管理が大きなハードルとなります。

こうした背景の中、Amazon Web Services(AWS)では、Amazon S3 Vectors、DeepSeek R1、Amazon SageMaker JumpStartなどの先進技術を活用することで、エンタープライズスケールのRAGアプリケーション構築を支援する取り組みを進めています。本記事では、それらの技術の組み合わせがどのようにRAGアーキテクチャのパフォーマンスを高め、エンタープライズ向けの要件に応えているのかを解説します。

RAGの基礎と企業における活用の意義

RAG(検索拡張生成)は、情報検索能力と生成能力を組み合わせたアプローチで、LLMの制限を補完する技術です。RAGでは、まずプロンプトに関連する文書を情報ベースから検索し、それらを背景情報としてLLMに供給します。これにより、モデルが取り扱う知識の鮮度や企業固有のドメイン知識を反映した応答が可能になります。

企業のナレッジベースは、社内ドキュメント、顧客とのやり取り、FAQ、製品情報など多岐にわたり、量も膨大です。こうした情報すべてを構造的に整理し、必要に応じて迅速に取得する仕組みが求められます。RAGはこの課題に応えるソリューションであり、顧客対応の自動化、社内ヘルプデスク、業務支援ツールなど幅広いユースケースで活用が進んでいます。

Amazon S3 Vectors:大規模データに対応するスケーラブルなベクトルストレージ

RAGの中核技術として、情報検索のためのベクトル検索があります。これにはドキュメントや問い合わせ文をベクトル空間に変換し、類似度に応じて関連ドキュメントを選定するプロセスが含まれます。このベクトル検索のパフォーマンスと可用性を決定づけるのが、ベクトルの保存先と検索インフラです。

Amazon S3 Vectorsは、Amazon Simple Storage Service(S3)上でネイティブにベクトル検索を可能にするサービスです。従来のS3がファイル・オブジェクトストレージとして活用されてきたのに対し、S3 Vectorsではオブジェクトに対してベクトル情報を登録し、高速でスケーラブルなベクトル検索を実現します。

このS3 Vectorsの活用により、企業はすでにS3に保管している膨大な量の非構造化データを、効率よくRAGシステムに統合することができます。また、データのライフサイクル管理やアクセス制御、セキュリティといったS3の特長をそのまま活用できる点も大きなメリットとなります。

DeepSeek R1:オープンなLLMで高度な生成性能を実現

生成部分には、近年注目を集めているオープンソースの大規模言語モデル「DeepSeek R1」が利用されました。DeepSeek R1は、70Bパラメータを持つ高性能モデルで、その性能は数ある商用モデルに匹敵します。Hugging Face Transformersを通じて利用可能であり、AWS上でのデプロイやファインチューニングも容易に行うことができます。

LLMをクラウド上で安定的に運用するには、インフラの最適化が不可欠です。ここで有効なのがAmazon SageMaker JumpStartです。JumpStartは、SageMaker上で事前トレーニング済みのモデルを簡単にデプロイおよび実行できるプラットフォームで、DeepSeek R1のような大規模モデルを試す上での障壁を低減します。また、SageMakerはセキュリティ、スケーラビリティ、リージョン選択といったエンタープライズ要件に柔軟に対応できる点も評価されています。

これらの技術を活用することで、エンドユーザーは高品質な応答を得ることが可能になり、企業内部での意思決定プロセスや情報照会が飛躍的に効率化されます。

エンドツーエンドのアーキテクチャ設計

記事では、Amazon S3 Vectors、DeepSeek R1、Amazon SageMakerを組み合わせたエンドツーエンドのアーキテクチャが紹介されています。まず、企業内のドキュメントを前処理し、分割・クレンジングを経て、それぞれのセグメントをベクトル化します。このベクトル情報はS3 Vectorsに格納され、クエリが発生した際には該当するベクトルを高速検索し、関連文書を取得します。

その後、取得したコンテキスト情報はプロンプトテンプレートに挿入され、DeepSeek R1を通じて回答が生成されます。このプロセスはAPIやエンドユーザー向けダッシュボードを通じて可視化され、企業の一般ユーザーでも簡単に活用できる構成となっています。

さらに、Amazon BedrockやLangChainとの統合も示唆されており、今後さらに柔軟で連携性の高いRAGシステムへの展開が期待されています。

ユースケースとエンタープライズ環境への適用

このような高度に統合されたRAGアーキテクチャは、さまざまな業界での実用性を持ちます。

たとえば、法律事務所では過去の契約文書をもとに、類似の契約条項を自動抽出・要約するアプリケーションを構築できます。保険業界では、顧客の請求履歴や契約条件を参照しながら、カスタマイズされた応答を返すチャットボットが構築されるでしょう。また、製造業においても、技術仕様書やメンテナンスマニュアルの中から関連情報を抽出し、現場スタッフの作業効率向上に寄与するソリューションが実現可能です。

AWSのクラウドインフラにより、こうしたアプリケーションのセキュリティや可用性を担保できるため、コンプライアンスの厳しい業界でも安心して導入が進められます。

今後の展望と導入に向けたポイント

RAGアーキテクチャの企業導入に際しては、いくつかのポイントが存在します。まず、自社のナレッジベースについて、どの情報が検索・生成の対象になるかを明確にすることが重要です。次に、情報セキュリティやアクセス制御の観点から、データレイクの構造やポリシーの整備が求められます。

また、モデル選定も重要です。DeepSeek R1のようなオープンソースモデルは柔軟性があり、コスト管理にも有効ですが、運用管理の難易度も伴います。こうした課題を克服するには、Amazon SageMaker JumpStartを活用したデプロイや、あらかじめベストプラクティスに基づいたテンプレートの活用が鍵となります。

今後、RAG技術はさらに進化し、新たな開発ツールや統合プラットフォームとの親和性も高まっていくと考えられます。LangChainのようなフレームワークやAmazon Bedrockのような多様なLLM提供基盤との連携によって、さらに高度なユースケースへの発展が期待されます。

まとめ

企業向けの生成AI活用において、RAGアプローチはその正確性と柔軟性から非常に有効な手法とされています。本記事で紹介したAmazon S3 Vectors、DeepSeek R1、Amazon SageMaker JumpStartの組み合わせは、大規模なデータ処理と高性能モデルの運用を効率化し、企業におけるAI活用のハードルを大きく下げる技術的基盤となります。

生成AIの恩恵を広く享受するためには、適切なアーキテクチャ設計とそれを支えるクラウドサービスの選定が不可欠です。今後、さらに多くの企業がこのような進化したRAGアーキテクチャを活用し、よりスマートな業務環境を構築していくことが期待されます。技術の進歩に敏感に対応し、柔軟にRAGの最新動向を取り入れることで、業務効率だけでなく、イノベーションの加速にもつながるでしょう。