近年、AI(人工知能)の進化は目覚ましく、その能力は日々高まっています。とりわけ、生成AIと呼ばれるモデル――たとえばテキストを生成するAIや画像を生成するAIなど――は、驚くほど人間らしい出力ができるようになり、私たちの暮らしや仕事のあり方に大きな影響を与えつつあります。しかし、これらのAIがどのような「データ」を使って学習しているのかについては、これまで十分に明かされてこなかった側面があります。

最近、テクノロジーレビューの記事によって重要な事実が明るみに出ました。ある大規模AIトレーニングデータセットに、数百万件に及ぶ個人情報が含まれていたことが判明したのです。これは、AIによる未来に対し私たちが持つ期待と希望だけでなく、倫理やプライバシーといった懸念についても、改めて真剣に考えるべきタイミングが訪れていることを示しています。

この記事では、この件の背景や問題点、今後必要とされる取り組みについて、AIに詳しくない方にもわかりやすい形で紹介していきます。個人情報がAIに取り込まれていく現実とはどのようなものなのでしょうか。そして、私たちはそれにどう向き合うべきなのでしょうか。

AIトレーニングに使われるデータとは?

まず基本的な前提として、機械学習型のAIがどのようにして能力を獲得するのかを簡単に確認しましょう。AIは、人間が作成した膨大な量のテキスト、画像、音声、動画などの「データ」をもとに、一定のパターンやルールを学習します。これを機械学習またはトレーニングと呼びます。

つまり、AIが文を理解したり、絵を描いたり、質問に答えたりできるのは、それらの作業に関連する大量のデータを事前に学習しているからです。Facebookの投稿、ニュース記事、電子書籍、報告書、ウェブサイト、フォーラムのやりとりなど、ありとあらゆる情報がトレーニングデータの候補になります。

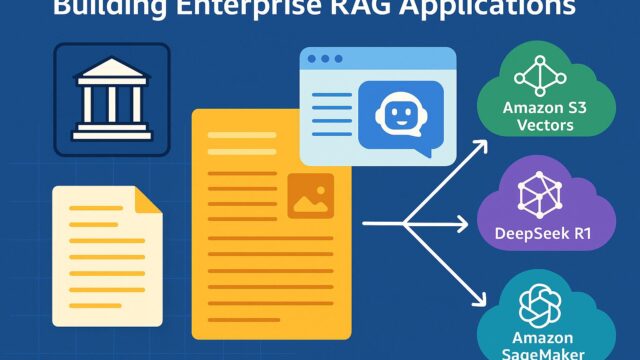

その中で、「データセット」と呼ばれるものは、AI学習のために特に選別・整理された情報の集合体です。開発者たちは、AIの性能を高めるためにできるだけ多くかつ多様な情報を集め、モデルに学習させます。今回の記事で問題となっているのは、その一つである「The Stack 2.0」という大規模データセットです。

The Stack 2.0に含まれていた個人情報

The Stack 2.0は、もともとオープンソースソフトウェアのコードを中心としたデータセットです。このようなデータは、プログラミングAIなどをトレーニングするために非常に有効で、世界中の開発者の努力の結晶をモデルが学習できる点で重要な役割を持ってきました。

ところが最近の調査により、このデータセットの中に、ソースコードとは無関係な形で個人情報が多数含まれていたことが明らかになりました。その一例として、運転免許証、パスポート、政府発行のID番号、医療記録、住所、電話番号、氏名、電子メールアドレスなどが含まれていたとされています。

こうした情報は、本来AIのトレーニングとは関係のないものであり、また本人の同意を得ずに使われていた可能性が高いと見られています。そればかりか、一部の情報はプライベートなチャットや履歴書の内容、さらには子どもが作成した個人記録など、極めてセンシティブなデータすら含まれていたというのです。

どのように個人情報が入り込んだのか?

では、なぜこのようなデータがデータセットに含まれてしまったのでしょうか。その要因のひとつは、オープンソースの世界が非常に広範囲で、多様性に富んでいることにあります。プログラミングの世界では、ソースコードを誰でも自由に共有できる仕組みがありますが、その一方で、意図せずに個人情報を含んだファイルが含まれることもあります。

例えば、こっそり保存した記録ファイルの中にパスワードや氏名が含まれていたり、誤ってスキャンした身分証や履歴書の画像がフォルダに格納されていたりすることもあります。人間の不注意が起点となり、結果的にそれらのファイルが学習データとして使われる事態が起き得るのです。

また、データセットを作成する過程で、このような不要あるいは危険なデータをきちんと除外するチェック体制が不十分であったことが要因として挙げられています。開発スピードを重視するあまり、安全性確認が後回しとなってしまうことは、テクノロジー業界では決して珍しくありません。

AI開発と倫理・プライバシーの課題

今回の問題は、AI開発における倫理とプライバシーの取り扱いについて、改めて考え直すべき契機を私たちに提供しています。AIが学習したデータが不適切であった場合、そのAIが出力する内容にもリスクが伴います。たとえば、個人の名前や連絡先が回答として出力されるとしたら、思わぬトラブルや情報漏洩の原因になりかねません。

しかも、AIは元になったデータがどこから来たかを明確に追跡しにくいという性質を持っており、一度学習してしまったら「忘れさせる」ことが難しいという技術的な課題もあります。これにより、不適切なデータの使用に気づいたとしても、迅速に修正できない恐れがあるのです。

このような現実を受け入れたうえで、AI開発に携わるすべての人がデータの扱いに慎重になり、倫理的な基準をより一層重視すべき段階に来ているとも言えるでしょう。

私たちはどうすべきか?

この話題は、AIの専門家だけに関係するものではありません。私たち一人ひとりが、AIの発展とどう向き合うかを考える上で、非常に重要なポイントを含んでいます。

まず、個人情報の管理に対する意識を持つことが第一歩です。不要なデータをネット上に公開しない、クラウドや共有システムに個人情報を保存するときは慎重になるなど、基本的な情報リテラシーを高めることが有効です。

また、私たちが利用するAIやアプリがどのような仕組みで動いているのか、どのようなデータを扱っているのかに関心を持つことも大切です。サービス利用時のプライバシーポリシーや利用規約に目を通し、自分のデータがどう使われているかを知ろうとする姿勢が、健全な技術利用を後押しします。

そして、企業や研究者に対しては、透明性と責任ある開発を求める声をあげていくことも必要です。AIの進歩が社会に大きな恩恵をもたらす反面、取り扱いを誤れば重大な問題にもつながります。だからこそ、多くの人の視点や価値観を反映した議論や制度が求められているのです。

未来のAIのあり方を、共に考えよう

AI開発における個人情報の混入は、過去にも何度か問題視されてきましたが、今回のように大規模でかつ実際に人々の生活に影響を与えるレベルのケースは非常に重大です。それは単なる技術上の失敗ではなく、「人間がどのようにAIと共存していくべきか」という問題を私たち全員に突きつけています。

私たちは、技術そのものを否定する必要はありませんし、AIの可能性を疑う必要もありません。しかし、AIが正しく使われるためには、透明性、倫理、プライバシーへの配慮といった基盤が必要です。それらを整えることで、AIはさらに多くの人にとって役立つ存在となるでしょう。

この問題に関心を持つことは、私たち自身の未来に責任を持つことに直結しています。AI技術の恩恵を受けながらも、そのリスクに適切に対応できる社会を、私たちは共に築いていくべきなのです。