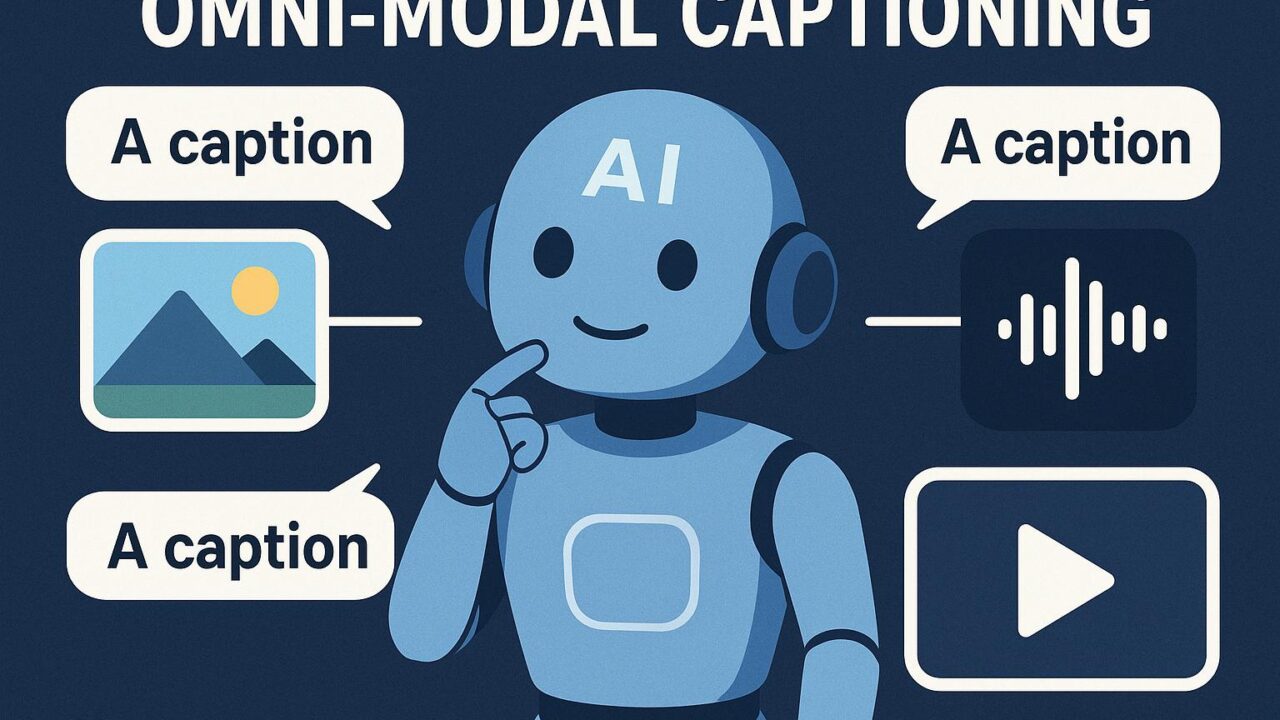

近年、人工知能(AI)技術の飛躍的な進歩に伴い、人と機械の自然な対話を実現するための手段として「マルチモーダルキャプショニング(Omni-modal Captioning)」の重要性が増しています。これは、画像や音声、動画といった多様な形式のデータに対して、意味を理解して自然言語で説明文(キャプション)を生成する技術であり、視覚障害者支援や情報検索、教育など、さまざまな社会的ニーズに応じた応用が期待されています。

そうした中で、最新の研究として注目を集めているのが「AnyCap Project」です。これは、「AnyCap: A Unified Framework, Dataset, and Benchmark for Controllable Omni-modal Captioning」という論文から提示された取り組みで、これまで個別に行われていたマルチモーダルデータのキャプショニングを、統一的かつ柔軟に制御できるかたちで実現するための新しいフレームワーク、データセット、ベンチマークを提供するものです。

今回は、この「AnyCap Project」がAI研究・開発にもたらす意義やその技術的な特徴、将来への影響について詳しく解説していきたいと思います。

Omni-modal Captioningとは何か?

これまで、画像にキャプションをつけるImage Captioningや、動画に説明を加えるVideo Captioning、音声に対してナレーションを生成するAudio Captioningなど、それぞれのモダリティに特化した研究が進んできました。しかし、これらは個別に開発・評価されることが多く、統一された方法論は存在しませんでした。また、与えられたデータに依存してキャプションを生成するため、説明文の文体や内容をユーザーが自由にコントロールすることも困難でした。

ここで登場するのが「Omni-modal Captioning(全方位的キャプショニング)」という概念です。これは、画像、動画、音声、3Dシーンといった複数のモダリティに柔軟に対応しつつ、ユーザーの意図に応じてキャプションの内容や文体をコントロール可能にするというものです。つまり、単なる情報記述ではなく、「どのような観点で説明してほしいか」「どんな調子で書いてほしいか」といった指示を加えることができます。

AnyCap Projectの目指すもの

AnyCapは、まさにこのOmni-modal Captioningの総合的な研究・開発を可能にするためのプロジェクトです。具体的には、以下の3つの柱から構成されています。

1. 統一されたフレームワーク(Unified Framework)

AnyCapでは、あらゆるモダリティに対応できる単一のアーキテクチャを提案しています。これにより、多様なデータタイプ(画像、映像、音声、3Dデータなど)を個別に処理するのではなく、一貫性のある方法でキャプションを生成できます。さらに、ユーザーからの制御指示(プロンプト)に応じて、出力されるキャプションの内容やスタイルを柔軟に変えることが可能です。

例えば、「この画像を専門家視点で説明してほしい」「この動画を子ども向けにわかりやすく解説してほしい」といったプロンプトに応じて、キャプションを自由自在に生成できます。従来の汎用モデルに比べて、ユーザーとの対話性が大きく向上している点が特筆すべき特徴です。

2. 包括的なデータセット(Unified Dataset)

AIの性能を飛躍的に向上させる鍵が「質の高い大規模データセット」です。AnyCapでは、多様なモダリティと制御タイプをカバーする世界初の統一キャプショニングデータセットを構築しました。このデータセットには、画像、映像、音声、3Dシーンといった多様な入力に対して、制御プロンプト付きのキャプションペアが含まれており、学習時にモデルが「どんな視点やスタイルで説明すればよいか」を学べるようになっています。

また、このデータはすべて高品質な、人手でアノテート(注釈付け)された情報で構成されており、機械学習モデルの学習に非常に適したものとなっています。今後の研究開発のベースデータとして活用されることが期待されています。

3. 統一ベンチマーク(Unified Benchmark)

技術を評価・比較するためには、統一された評価基準が欠かせません。AnyCapは、Omni-modal Captioningモデルを公平に評価するための統一ベンチマークも提案しています。これは、現在のさまざまなキャプショニングモデルを、制御可能性、表現力、正確性、多様性など、複数の観点から評価できるようにデザインされています。

これにより、今後登場するあらゆる新しい技術について、「どれだけ柔軟にキャプションが制御できるか」「どれだけリッチな説明が可能か」といった重要な基準で客観的比較ができるようになります。このベンチマークの存在は、研究者コミュニティにとって非常に意義深く、技術進歩の加速を助ける重要な一歩となるでしょう。

AnyCapの技術的ハイライト

AnyCapの背後には、最新のAI技術――とくに大規模言語モデル(LLM)とマルチモーダルトランスフォーマー――の活用があります。これにより、画像や動画といったビジュアル情報を理解し、それを自然言語で表現する能力が大幅に強化されています。さらに、ユーザーからの制御情報を符号化し、出力されるキャプションに反映させる「プロンプト制御」技術も高度に最適化されています。

また、一般的なLLMとは異なり、モダリティごとに特徴をもつデータを処理するために設計された「一元的な埋め込み空間(Unified Embedding Space)」が導入されており、異なる形式のデータも一貫して処理可能になっています。こうした設計により、高精度かつ柔軟性のあるキャプショニングが実現されています。

AnyCapによって実現される未来

AnyCapの登場により、AIによるキャプショニング技術は次のステージに進みつつあります。これまでは画像なら画像、動画なら動画、というように個別設計されたシステムが主流でしたが、今後はすべてのモダリティにまたがる「汎用キャプショニングモデル」が主流になっていく可能性があります。

これは、たとえば次のような応用範囲を実現可能にします:

– 視覚障害者向けに、現実世界を多モーダルで認識し、やさしく情報をナレーションする支援技術

– 教育現場で、映像教材を子ども向けや専門家志向で自動解説するAIアシスタント

– 映像や音声コンテンツの自動要約・説明によるアクセシビリティの向上

– プロフェッショナルの現場で、医療映像を専門的に説明する補助ツール など

しかも、ユーザーが「どういう説明を求めているか」「どんな目線で見てほしいか」を指定できるため、より対話的で人間らしい自然な理解と伝達が可能になります。

まとめ

AnyCap Projectは、マルチモーダルAIの世界において新たなパラダイムを示す革新的な取り組みです。統一されたフレームワーク、包括的なデータセット、高品質な評価ベンチマークを提供することで、キャプショニング技術を「制御可能で対話的な総合インターフェース」へと進化させています。

この研究は、一部のエリート研究者だけではなく、一般のエンドユーザー、教育者、福祉関係者など、さまざまな分野の人々にとっても恩恵が多く、AIと人間の距離を縮める重要なステップでもあります。今後、この分野でどのような実利用や発展が生まれるのか、ぜひ注目していきたいところです。