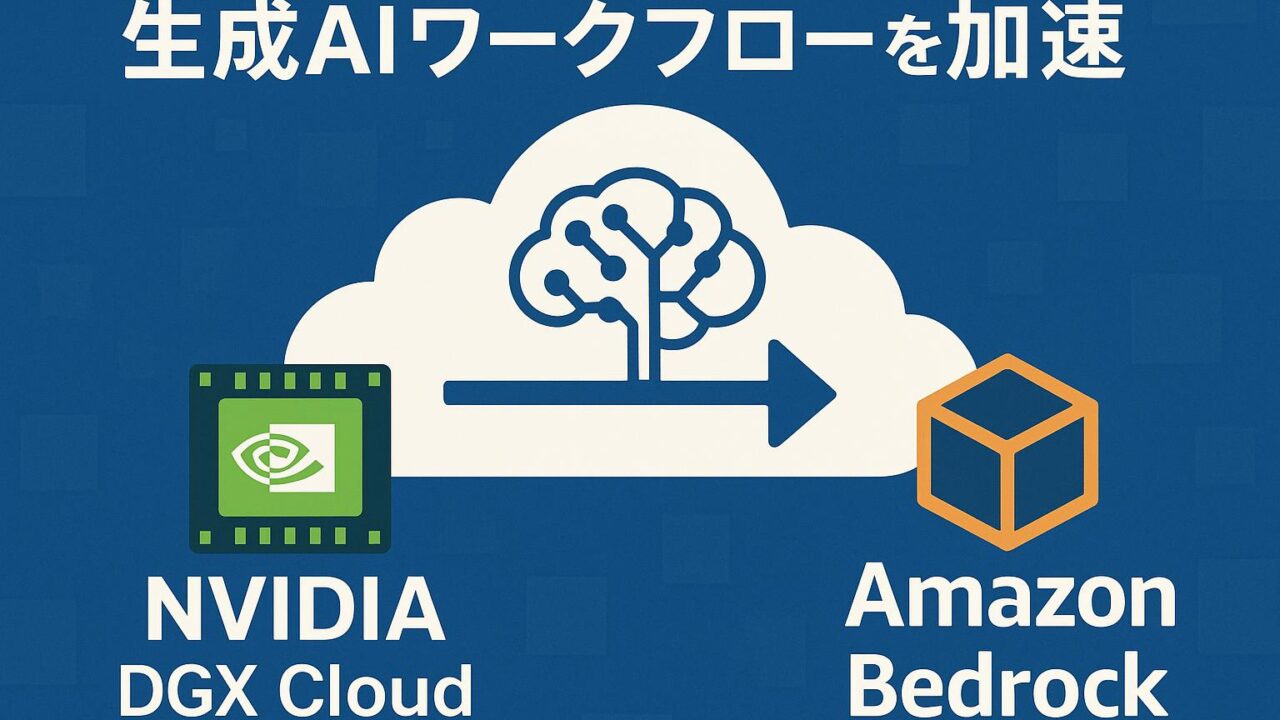

生成AIワークフローを“加速”する — AWSにおけるNVIDIA DGX CloudとAmazon Bedrock Custom Model Importの活用

生成AIの可能性が日々拡大する中で、企業や開発者はますます高性能で柔軟性のあるAIインフラストラクチャとモデル運用の仕組みを求めています。特に大規模言語モデル(LLM)や画像生成ツールといった生成AIの有効活用は、研究・開発のスピードと創造的なアウトプットのクオリティを劇的に押し上げる要素となっています。

そんな中、NVIDIAとAWS(Amazon Web Services)は、NVIDIA DGX CloudおよびAmazon BedrockのCustom Model Import機能を通じて、開発者たちにより強力で柔軟な生成AIワークフローの構築手段を提供しています。本記事では、このソリューションによってもたらされる価値と、企業がどのようにこれを活用して生成AIのプロセスを“加速”できるのかをご紹介します。

NVIDIA DGX Cloudとは?

NVIDIA DGX Cloudは、NVIDIAが提供する完全マネージド型のAIスーパークラスタをクラウド上で利用可能にするサービスです。これにより、ハードウェアの管理や構築なしに、高度なAIトレーニングやモデル微調整の作業がスムーズに行える環境が整います。

AWS上でも利用可能となったことで、EC2インスタンスやS3ストレージといったAWSの豊富なサービス群とシームレスに統合できるようになり、さらに強力なAIパイプラインの構築が可能になりました。

DGX Cloudは、大規模なGPUクラスタを備えたインフラとして、高速なトレーニングや推論に対応しています。特にNVIDIAによるソフトウェアスタック、フレームワークとの最適化が施されており、Container化されたAIワークロードのデプロイも容易です。

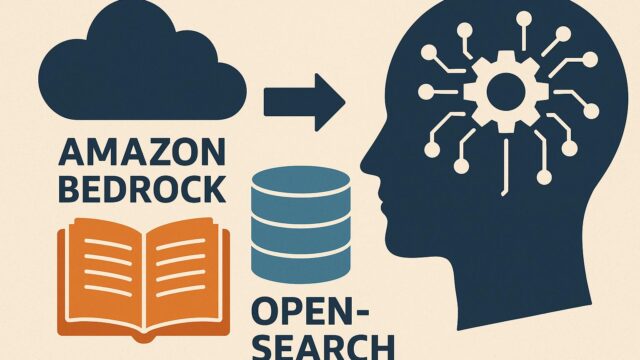

Amazon Bedrockとは?

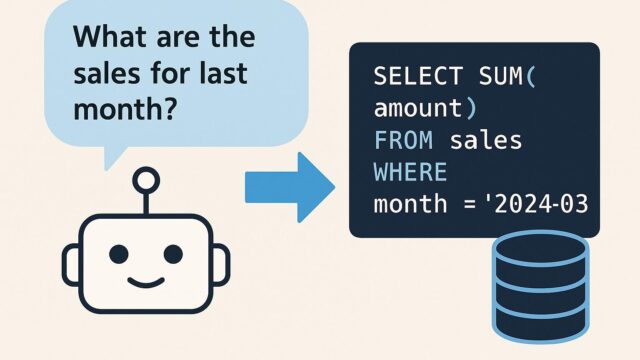

Amazon Bedrockは、複数のサードパーティーまたはAWSが提供する基盤モデル(Foundation Models)を選択し、アプリケーションへ容易に組み込むためのサービスです。特徴はAPI一つでさまざまな生成AIモデル(例えばAnthropic Claude、Stability AI、Amazon Titanなど)にアクセスできる点にあります。

そしてここに最近追加された新機能が「Custom Model Import」です。この仕組みにより、企業独自で開発またはトレーニングしたモデルを、Bedrock上にインポートし、同じようにAPI経由で活用できるようになりました。この機能の追加により、独自性のある生成AIアプリケーションの開発と運用がさらに加速されることになります。

この2つのサービスの連携:トレーニングと運用の架け橋

最大のポイントは、NVIDIA DGX Cloudでトレーニング・微調整された高度な生成AIモデルを、Amazon BedrockのCustom Model Import機能を通じて本格的な運用環境へとシームレスに移行・統合できる点です。

例えば、以下のようなユースケースが考えられます:

1. 自社の機密文書を理解するように特化された大規模言語モデルをDGX Cloud上で独自に微調整。

2. トレーニング済みのカスタムモデルをAmazon Bedrockへインポートし、REST APIとして社内外のアプリケーションで利用。

3. モデルの呼び出し、スケーリング、バージョン管理、セキュリティ制御といった運用上の複雑さをAWSで一元的に管理。

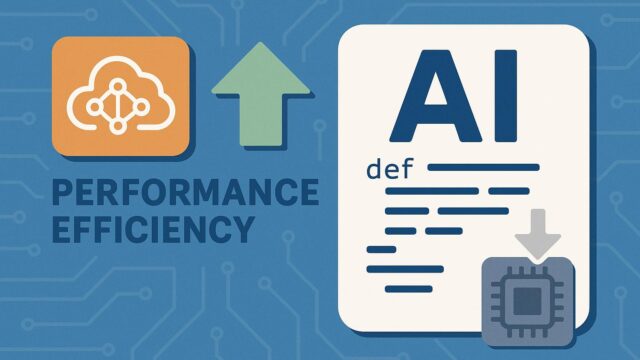

NVIDIA NIMとの連携によるさらなるパフォーマンス最適化

NVIDIAが提供するNIM(NVIDIA Inference Microservices)は、最適化された推論用のコンテナを提供する仕組みで、モデルの展開にかかる時間と手間を大きく削減します。このNIMを導入することで、DGX Cloud上で学習したモデルをBedrockに持ち込む前に、推論パフォーマンスを最適化した状態で利用できるようになります。

また、この仕組みにより、モデルの運用コスト削減やレスポンス時間の短縮も見込まれ、ビジネスにおいてより迅速な意思決定や顧客対応が可能になります。

柔軟なアーキテクチャ設計による構成例

開発者や企業が取れる一つのアーキテクチャモデルは以下のようなものです:

– データとトレーニング:S3上に保持している企業データを使い、DGX Cloud上でモデルを学習またはファインチューニング。

– モデルコンテナ化:NVIDIA NIMの仕組みに従い、モデルをマイクロサービス形式でコンテナ化。

– Bedrockへのインポート:Amazon BedrockのCustom Model Import APIを使用して、モデルをインポート。

– アプリケーション統合:Amazon API Gateway、Lambda、SageMakerなどと連携し、システム全体に組み込まれる。

総合的メリット

このような構成における最大の利点は「スピード」と「一貫性」です。

– インフラストラクチャに関わる複雑な設定や管理から解放され、本来のML開発に集中可能。

– ベンダーロックインを避けつつ、業界最高水準のハードウェアとソフトウェアを選択できる柔軟性。

– トレーニングと推論間のギャップを最小限に抑え、高精度なモデルが即座に利用可能。

– セキュリティ、コンプライアンス、可用性などエンタープライズ要件への対応も統合されたAWS環境下で一元化。

実際の導入が提示する未来像

さまざまな業種でこのような生成AIワークフローはすでに現実になりつつあります。金融業では問い合わせの自動処理、医療分野では画像解析、製造業では故障予測や製品設計のアイディエーション支援など、幅広いユースケースでの応用が進んでいます。

信頼性と拡張性、そして“迅速さ”を併せ持った生成AI基盤を構築するには、「パフォーマンス」と「オペレーションの簡易性」の両立が欠かせません。その点において、NVIDIA DGX CloudとAmazon Bedrock Custom Model Importという組み合わせは、非常に理想的な解決策と言えます。

まとめ:生成AIの“本格活用”へ向けた一歩

生成AIの発展が加速する中、単にモデルを利用するだけではなく、「いかにして自社仕様にモデルを最適化し、それを安全かつ効率的に運用するか」が次の大きな課題です。この課題に応える具体的なステップとして、NVIDIA DGX Cloudでの高性能なトレーニングとAmazon Bedrockによる柔軟なデプロイメントは、企業にとって非常に価値ある選択肢となっています。

これからの時代は、パーソナライズされたAIモデルの時代です。独自性のある、そしてユーザーやビジネス要件に最適なモデルを、迅速に市場へ届けるためのプラットフォームとして、これからますます注目を集めることでしょう。

AWSとNVIDIAの連携により実現されるこのワークフローは、生成AIの導入とスケーリングにおける最先端の姿を示しています。生成AIを単なるツールから、ビジネスの中心的戦略へと進化させるための第一歩として、今こそ導入を検討する価値があるのではないでしょうか。