現代の大規模言語モデル(LLM)の進化により、数学的な問題解決能力の深化が一層注目を集めています。複雑な計算、定理の証明、抽象的な論理推論といった高度なタスクにおいても、自然言語で書かれた問題文を理解し、解答を導き出す力が求められています。こうしたニーズに応えようと、多くの研究者が数学に特化したLLMの開発に取り組んでいます。

今回紹介する論文「A Practical Two-Stage Recipe for Mathematical LLMs: Maximizing Accuracy with SFT and Efficiency with Reinforcement Learning」は、そうした取り組みの中でも特に実用的かつ高精度なアプローチを提示しています。本論文では、数学問題に特化したLLMを訓練するための実践的な二段階学習手法が提案されており、それぞれの段階が異なる目的に特化して機能することで、最終的に高精度かつ効率的な数学LLMの実現を目指しています。

本記事では、この論文で提案されたアプローチの構造とその利点について解説し、数学分野におけるLLMの実用化可能性を掘り下げます。

LLMsと数学の難しさ

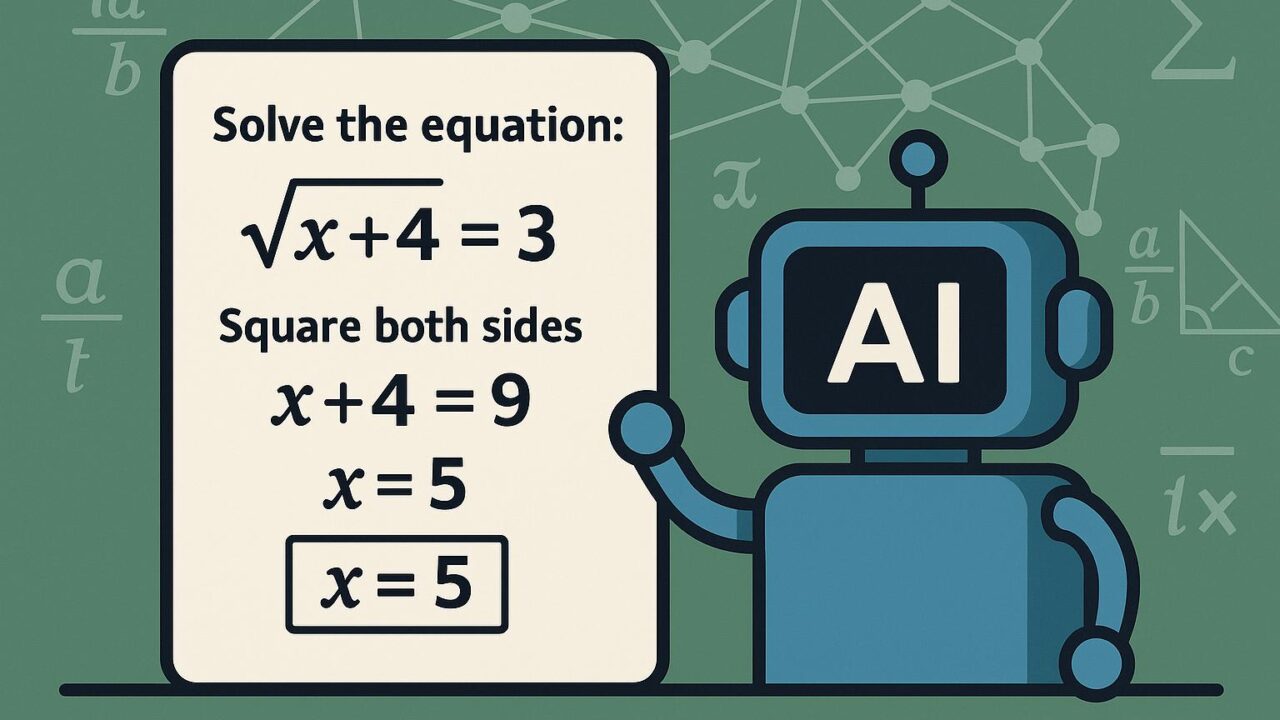

通常の言語処理タスクと比較して、数学的推論にはより厳格で構造的なロジックが求められます。自然言語では文脈の曖昧さがある程度許容されますが、数学においては正確な記述、論理進行、数値的整合性が不可欠です。たとえば、単純な計算ミスや誤った定理適用があれば、即座に誤答と判定されます。

このような精密性が必要なタスクにおいて、人間の数学者に近い振る舞いを示すLLMを作るには、従来の自然言語モデル以上に厳格かつ調整された訓練が必要です。加えて、学習中に効率良く最良の出力を生成する方法論も重要な課題として浮上してきています。

二段階の訓練フレームワーク:概要

今回の論文では以下の二段階からなるトレーニングレシピが提案されています。

第1段階:SFT(Supervised Fine-Tuning)による正確性の最大化

第2段階:RLAIF(Reinforcement Learning with AI Feedback)による効率性の最大化

この仕組みは、まず人間の解法に基づいた教師あり学習により正答率を高め、その後、強化学習を通じてより優れた探索能力と作業効率をモデルに習得させるという構成になっています。それぞれの段階には明確な目的と手法があり、バランスよく組み合わせることで数学LLMの性能を大きく向上させることが可能になります。

第一段階:正確性向上の鍵となるSFT

SFTは、事前に用意された高品質な解答ペア(問題とその正答)を元に、モデルに正確な出力パターンを学ばせる方法です。この段階では、人間の数学者あるいは既存の信頼性の高い解答データセットを利用して、モデルが「正しい解答とはどのようなものか」を理解するよう訓練されます。

数学に強いLLMを訓練する際には、このSFTが不可欠です。なぜなら、初期段階で誤った論理構造、誤算などを学習してしまうと、その後の強化学習でも誤った方向に強化されてしまうリスクがあるからです。

ここでは特に「解答の途中経過」も含めた段階的なステップ(step-by-step reasoning)を重視しています。これにより、モデルが途中で道を逸れないように、複数のステップにおいて正解に至るロジックの整合性を確保する設計がなされています。

第二段階:効率性の最大化を目指すRLAIF

SFTによって基礎的な正確性を備えたモデルは、次に効率性の向上を目指して微調整されます。ここで用いられるのがRLAIFです。これは、「Reinforcement Learning from AI Feedback」の略で、従来人間が行っていた「良い解答」「悪い解答」の判定を、AIを使って自動化した強化学習法です。

この段階では、モデルが生成した複数の解答候補のうち、AI判定システムが「より良い」と評価したものを報酬として与え、その方向にモデルを更新していきます。これにより、モデルはより短く、より直感的かつ洗練された解法を生み出すことができるようになります。

RLAIFの利点は、「人手による評価なしで」大規模な比較訓練が可能になる点にあります。これにより効率的に「最良の表現方法」や「解法のスマートさ」を習得させることができ、コストと精度のバランスが大きく向上します。

データ収集と評価方法

本論文では、モデル訓練に使用されたデータとその評価方法にも詳細に言及されています。特筆すべきは、二段階のそれぞれに異なるタイプのデータが使用されている点です。

SFT段階では、高品質な数学問題と解答ペアからなるデータセットが使用され、確実な正解を導くための学習が行われました。一方、RLAIF段階では、モデル自身が出力した解答群を相互比較し、別のAIが「どれが理にかなっているか」「どれが論理的に優れているか」を判断するためのデータを構築し、それを報酬設計に活かしています。

また、最終的なモデルの性能評価にも多角的な指標が使われています。単純な正解率だけでなく、途中計算の整合性や文脈における合理性など、数学的思考に必要な要素が幅広くチェックされており、実用的な利用に対して高い信頼性が示されています。

結果と実用的な意義

この論文における提案手法は、従来のアプローチと比較して、単なる正答率だけでなく、出力の質的向上、すなわち「読みやすく」「ロジカルで整っている」解答を生成する能力に優れていることが示されました。さらに、モデルのサイズをそこまで増やさなくても高性能な結果が得られる点も注目に値します。

これは教育現場や研究支援、工学設計など、数学的推論が必要とされるさまざまな場面において、LLMが信頼あるパートナーとして活用されうる可能性を大きく押し広げるものです。

今後の展望

今回の研究は数学分野に焦点を当てていますが、この二段階学習法は他のタスク、例えば法律、プログラミング、医療等の専門分野にも応用可能です。まずはSFTで基礎的な知識と文脈を学習し、次にRLAIFで効率性、簡潔性、応用力を磨くというこの段階的な枠組みは、より賢く、より信頼できるLLMの開発ロードマップとして広く活用されることが期待されます。

まとめ

本論文「A Practical Two-Stage Recipe for Mathematical LLMs」は、数学に特化した大規模言語モデルを訓練するための明確かつ効果的なフレームワークを提供しています。SFTによって精度を高め、RLAIFによって効率を高めるという二段階構成は、現実に即した形で数理的推論能力を強化する術として非常に有効であることが実証されました。

人間の専門家に匹敵する、あるいはそれ以上の思考力を持ったAIパートナーの誕生。その現実が、また一歩近づいているように感じられる画期的な研究成果です。今後の発展に大きな期待が寄せられます。