Mistralモデルを活用してAWS上にMCPアプリケーションを構築する方法

近年、生成AIの世界ではさまざまな大規模言語モデル(LLM: Large Language Model)が登場し、それらをどう組み合わせて実用的なアプリケーションへと進化させるかが重要なテーマになっています。特に、セキュリティやアクセシビリティ、パフォーマンスの観点から、オンプレミスやクラウド上で動作するマルチエージェントシステムやワークフロー型のアプリケーション構築のニーズは高まっています。

この記事では、AWS環境上に、効率的かつ柔軟に動作するMistralモデルを活用したMCP(Multimodal Chain-of-Thought Programming)アプリケーションを構築する方法をご紹介します。また、このモデルを活用するために、Amazon SageMaker、Amazon EC2、Amazon S3、Amazon ECS、そしてAWSのセキュリティおよびイベントドリブンアーキテクチャとの連携についても具体的に解説します。本記事を読むことで、Mistralモデルを導入・展開し、マルチステップなタスクをこなすインテリジェントなAIアプリケーション構築の第一歩を踏み出せるでしょう。

Mistralモデルとは?

Mistralは、オープンソースで展開されているLLMで、効率的かつ軽量でありながらも高精度な生成能力を持っている点で多くの注目を集めています。Ollamaというフレームワークを使用することで、ローカルやオンプレミス、さらにはクラウド上でも簡単に展開可能です。また、MistralはFlash AttentionやGroup Query Attentionなどの技術を活用しており、リソース効率の面でも優れています。

開発者や研究者にとって、Mistralは多くの可能性を秘めたツールとしての位置づけにありますが、これを運用環境で安全かつスケーラブルに活用するためには、堅牢なインフラストラクチャと運用知識が求められます。AWSが提供するツールやサービスを使えば、その基盤を容易に整えることが可能です。

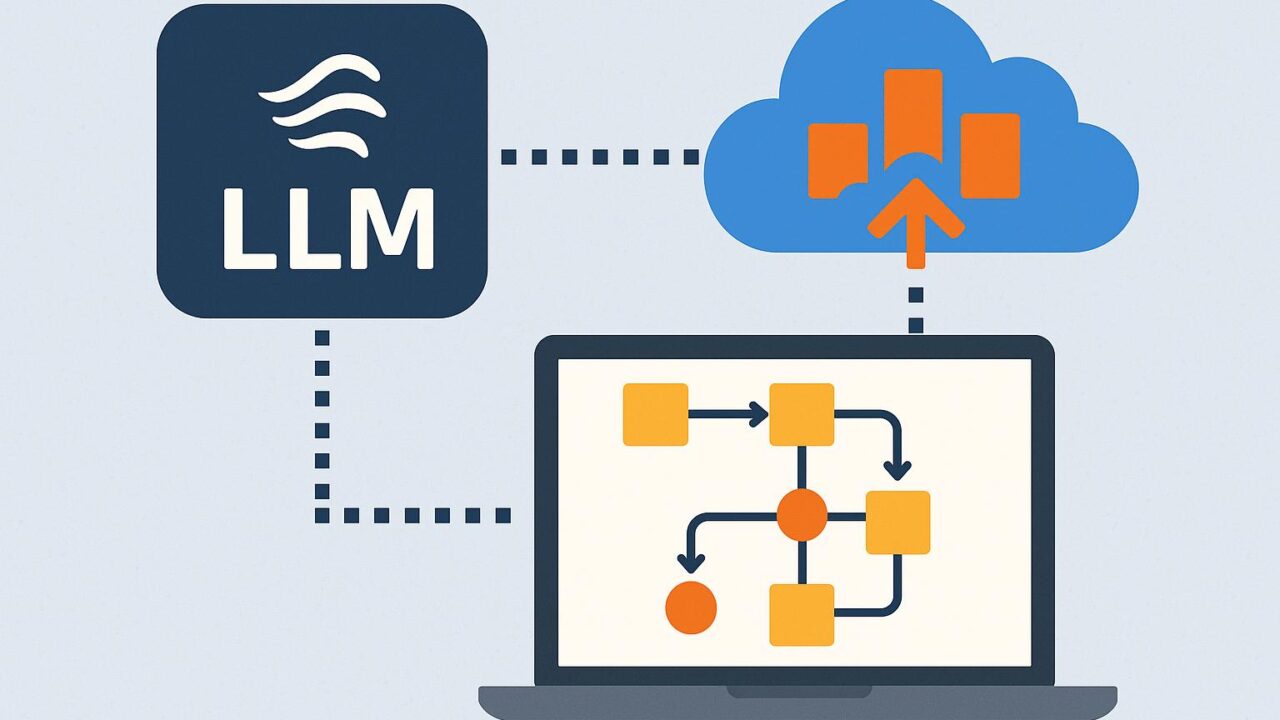

MCPアーキテクチャの概要

MCP(Multimodal Chain-of-Thought Programming)とは、複数のエージェントやアルゴリズムを組み合わせ、連鎖的にタスクを処理していくプログラミング構造を指します。これにより、単なるプロンプト応答型の大型言語モデルでは実現しきれない、複雑な論理プロセスや状態遷移に対応することができます。

一般的なMCPアプリケーションは、以下のような構成をとることが多いです:

– マルチモーダルな入力(音声、画像、文書など)

– ステートフルな推論機構

– チェーン状に構成された複数のタスクエージェント

– 永続的なメモリと履歴管理機能

– 環境からのフィードバックを取り込む能力

Mistralモデルは、このようなMCP構成において「推論エンジン」として機能し、他のオーケストレーションロジックや入力・出力処理と組み合わせることで、高機能なアプリケーションが構築可能になります。

AWS上でのMistralの展開方法

AWSを活用することで、Mistralを安全かつ高可用性なエンタープライズ環境に展開することができます。たとえば、以下のような構成が可能です:

1. モデルホスティング:Amazon EC2インスタンスを使ってOllamaをインストールし、Mistralモデルを動作させます。これにより、完全なカスタマイズとセキュリティ管理が可能になります。

2. ストレージの一元化:Amazon S3を使用すれば、モデルファイルや出力ログ、プロンプト履歴データなどを一元的かつ拡張性高く管理できます。

3. モニタリングとスケーリング:Amazon CloudWatchによるメトリクス収集、およびAuto Scaling Groupによって需要に応じたスケーリングが設定可能です。

4. フロントエンドとの連携:必要に応じて、Amazon API GatewayやAWS Lambdaを介して、フロントエンドUIや外部アプリケーションとの双方向インタラクションを構築できます。

5. セキュアなアクセス制御:IAMロールやセキュリティグループ、VPC設定を適切に設計・適用することで、高いセキュリティを維持しつつ、内部ユーザや限定的パートナーへのアクセスを許可できます。

OllamaとAmazon EC2によるローカル推論環境の構築

Ollamaは、ローカル上での言語モデルの呼び出しとインターフェースを簡略化するツールで、Mistralをはじめとする様々なオープンソースモデルに対応しています。Ollamaを使うことで、EC2インスタンス内にMistralをインストールし、APIsやCLIを通じて自由にモデル呼び出しが可能です。

この構成によって、以下の利点が得られます:

– データの完全なプライバシー保護

– カスタムプロンプトテンプレートや専用アルゴリズムとの統合

– インスタンスの性能に応じた柔軟な展開

GitHubやDocker Hubを活用して、既存のイメージを手軽に利用できるため、セットアップの時間も最小限に抑えられます。

MCPとイベントドリブンアーキテクチャの統合

MCPの真価を引き出すには、単にモデルを展開するだけでなく、イベント駆動によるタスクオーケストレーションが重要です。AWSでは以下のような設計が可能です:

– Amazon EventBridge を中心としたイベントバスの構築

– AWS Lambda による軽量なタスク処理ロジックの定義

– Step Functions による状態管理とタスク分岐の明示化

– Amazon SQS や SNS による通知と非同期処理

この仕組みを通じて、Mistralを利用した推論プロセスは、事前に定義されたトリガーや条件により自動で起動され、完了後は他の処理にパイプラインとしてつながるよう設計可能です。

マルチエージェントおよびマルチタスクによる思考フローの構築

MistralとMCPの組み合わせによって、単一の質問に答えるモデル活用よりも、より戦略的・階層的な思考プロセスが可能になります。例えば以下のような具体的活用が考えられます:

– 複雑な社内文書の要約・分類・タグ付けを段階的に実施

– ユーザーからの問い合わせを解析し、段階ごとに適切な回答を提案

– 長期的なプロジェクトの要件分析・課題抽出・改善提案の流れを自動で設計

また、ChatGPTのような単一エージェントモデルではなく、各専門領域に特化したサブモデルやサブルーチンを持つことで、各カテゴリに対して最適化された処理が可能になります。

事例紹介:社内ナレッジベースの解析支援ツール

具体的な応用事例として、ある社内向け情報システムチームが、数百ページにわたるナレッジベースの最適な構造化とユーザー対応を必要としていたケースを挙げます。

このチームでは、Mistralを使ったMCPアプリケーションを開発し、以下のような処理を行いました:

1. 全文検索と分割処理(S3とLambdaを活用)

2. 情報の分類と重要性スコアリング(Mistralで実施)

3. 注釈付きの内容を社内ポータルへ展開(API Gateway経由)

その結果、従業員による検索時間が大幅に短縮され、ユーザー満足度の向上につながったといいます。

まとめ

Mistralモデルは、オープンかつ高性能な大規模言語モデルとして、今後ますます注目を集める存在です。そしてAWSという堅牢かつ柔軟なインフラストラクチャ上でこれを運用することで、セキュリティ、スケーラビリティ、パフォーマンスの観点すべてにおいて最適な環境を整えることが可能になります。

特にMCPアーキテクチャとして展開することで、単なる質問応答ではなく、問題解決型の思考連鎖、マルチステップの意思決定支援、タスク自動化など、応用範囲は飛躍的に広がります。

これから生成AIやLLMを本格的に取り入れる企業やチームにとって、本記事がその第一歩となり、より現実的で生産的なAI活用の実現に貢献できれば幸いです。AWSの豊富な機能群と、OllamaによるMistralモデルの柔軟性を組み合わせて、次世代のインテリジェンスアプリケーションをぜひ構築してみてください。