大規模言語モデルの推論能力を強化するための新たなアプローチ ― クロスドメイン視点から見た強化学習の再検討

近年、ChatGPTなどの大規模言語モデル(LLM:Large Language Models)が急速に発展し、人間のように自然言語で推論や問題解決ができるようになりつつあります。しかし、これらのモデルの「本当の思考力(推論力)」をさらに高めるためには、単なる大量の事前学習データだけでは不十分であり、より制御された学習手法が注目されています。

その中で、強化学習(RL:Reinforcement Learning)は、モデルに「正しい答えにたどり着くための行動」を学ばせる手法として、高い期待を集めています。今回紹介する研究「Revisiting Reinforcement Learning for LLM Reasoning from A Cross-Domain Perspective」では、この強化学習を用いたLLMの推論力向上が、本当にどのように作用しているのかを詳細に分析し、新たな知見を提供しています。

なぜクロスドメイン評価が必要なのか?

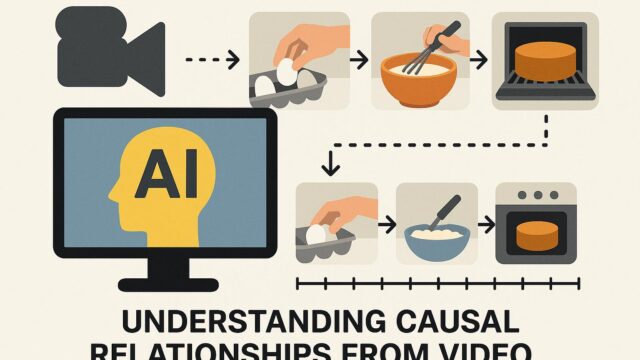

従来、多くの強化学習によるLLM研究は、数学やプログラミングのような特定ドメインに焦点を当てていました。しかし、現実には、人間のような汎用的な推論能力を求めるには、多様な領域(ドメイン)での対応力が必要です。つまり、「数学やコードに強くても、日常推論(たとえば表計算や因果関係を考える科学的思考)に弱ければ本末転倒」というわけです。

そこで本研究チームは、「Guru」と名付けられた大規模な強化学習用推論データセットを構築。数学、プログラミング、科学、論理、シミュレーション、表形式データの6領域にわたる計92,000の精査された問題と解答データを用意しました。各領域において、信頼性の高い報酬設計、重複除去、ノイズのあるデータのフィルタリングが行われることで、強化学習に適した学習素材が整備されています。

RLは知識を引き出すだけか?それとも新しい技能を学んでいるのか?

強化学習は、モデルの中に既にある隠れた知識を「引き出す」だけなのか、それとも「新しい技能を獲得させる」ものなのか―この問いは、LLMの能力向上を考えるうえで本質的です。

これまでの考え方では、LLMは主に事前学習済みの大量の知識の中から、適切なタイミングで情報を引き出す「情報再取得」型であるとされていました。すなわち、RLはその引き出し方だけを改善するという位置づけでした。

しかしこの研究では、ドメインごとの違いに注目することで、より深い理解が得られました。具体的には:

– 数学、コード、科学のような、元々の事前学習中に多く登場するドメインでは、「クロスドメインRL(例:コード分野の報酬信号で科学の推論精度が上がる)」でも効果が高い。

– 一方で、論理、シミュレーション、表形式データなど、あまり事前学習で扱われてこなかったドメインについては、特定ドメイン内のRLトレーニングが不可欠。すなわち、RLが新しい技能の学習(スキルアクイジション)を促している可能性が高い。

このことから、強化学習は単なる情報検索の補助ではなく、LLM自身の能力そのものを拡張する重要なカギであることが示唆されます。

Guruモデルの登場 ― 一般公開モデルで世界トップ水準の性能

研究チームは今回の成果をもとに、「Guru-7B」と「Guru-32B」という2つのRL訓練済みモデルを開発しました。これらは、市販・公開されているモデル群の中で、6つの領域にまたがる17のベンチマークタスクにて、従来のベースラインモデルに比べて以下のような性能向上を実現:

– Guru-7B:7.9% の精度向上

– Guru-32B:6.7% の精度向上

特に、複雑で事前学習に登場しにくいタスクでは、明確に精度が向上しています。さらに、Pass@kと呼ばれる「トップk候補に正解が含まれる確率」も改善し、実用性の高い回答生成に寄与している点も注目に値します。

技術的観点からの考察

本研究の最も価値ある点は、単にベンチマークのスコアを向上させるだけでなく、推論力の成長メカニズムを技術的に解明しようとした姿勢にあります。

特に、下記の2点は今後のRL研究やLLM設計において指針となるでしょう。

1. 報酬設計はドメイン依存で最適化すべき

→ 単一の「汎用的報酬関数」では、推論精度を向上させるには不十分。

→ それぞれの分野に応じたフィードバック設計が鍵となる。

2. Pretrainingのカバレッジに応じて、RLの効果は変動する

→ Pretraining時に少なかったドメインでは、RLが「新たな学びへの実装手段」として有効。

→ 長期的には、Limited Domainに特化したRLチューニング手法が求められる。

まとめ

この研究は、LLMの推論能力を多様な領域にわたって均等に引き上げるための新たな一歩です。私たちは今後、単なる「言葉の羅列器」としての言語モデルではなく、「本当に思考するAI」の構築に向かっていく転換点にいるのかもしれません。Guruのような取り組みがその可能性をさらに押し広げていくことでしょう。

研究のデータ、モデル、コードは以下のGitHubリポジトリに公開されています:

https://github.com/LLM360/Reasoning360