自己教師あり音声モデルはオランダ語をどこまで理解しているのか?

―言語特化型の事前学習が音声認識性能に与える影響を探る―

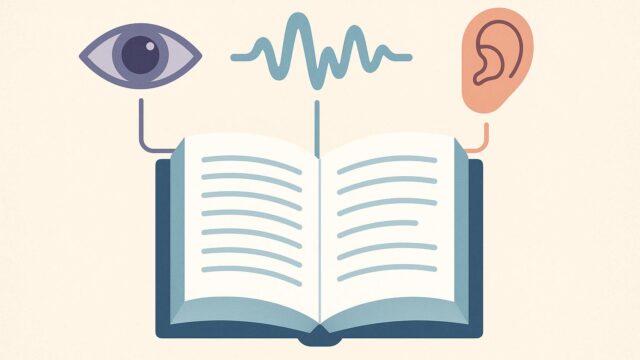

最近の音声処理の分野では、自己教師あり学習(self-supervised learning: SSL)の活用が急速に進んでいます。特に、Facebook AIが開発したWav2Vec2などの音声モデルは、未ラベルの音声データから豊富な言語的特徴(音韻、語彙、構文など)を抽出できるとして注目を集めています。しかし、それらのモデルがどれほど「言語特化型」の情報を内部表現に保持できるかについては、まだ明確に理解されていない部分が多く存在します。

今回紹介する論文「What do self-supervised speech models know about Dutch? Analyzing advantages of language-specific pre-training」では、自己教師あり音声モデルがオランダ語に特化した言語情報を、どこまで内部的に表現しうるかを定量的に評価しています。この研究は、音声認識だけでなく、多言語対応の自然言語処理モデルの設計にも重要な示唆を与えるものです。

■ 研究の概要と目的

研究者たちは、自己教師ありモデルWav2Vec2を、以下の3つの条件で事前学習し、これらのモデルがオランダ語の音韻(発音)・語彙(単語)変異などをどれだけ適切に内部表現として保持できるかを比較検証しました:

1. オランダ語の音声データのみで学習したモデル

2. 同程度の英語データのみで学習したモデル

3. 多言語(英語・ドイツ語・フランス語など)で学習した大型モデル

この構成により、少量だが言語を絞ったデータ(オランダ語特化)と、大量だが多言語混合データ(一般化されたモデル)の比較が可能になります。

■ 技術的アプローチと評価方法

評価には、「クラスタリング」や「線形分類器」など、ニューラルネットワークの内部表現から言語的特徴を抽出する技法が用いられました。特に、音素(phoneme)の識別、語彙の区別、発音的な距離の測定といった課題を通じて、各モデルの表現力を定量的に分析。

また「ゼロショット評価」として、モデルが学習していない下流タスクでの性能(たとえばASR性能)から、汎用性や言語特化性を間接的に評価する手法も採用されました。

■ 主な発見と考察

1. オランダ語で専用に事前学習されたモデルは、英語や多言語モデルに比べて、オランダ語の音韻的・語彙的な特徴の把握に優れていることが示されました。特にphoneme(音素)とword-type(語種)の識別性能が高い傾向にありました。

2. 多言語モデルは一般化力こそ高いが、特定言語(今回の場合、オランダ語)における表現力は限定的。これは、「量より質」の問題と言えます。すなわち、多言語であっても、その言語の特徴が十分にカバーされていなければ内部での表現が不十分になる可能性があります。

3. クラスタリングや線形分類器による計測では、オランダ語特化型モデルの方が音素ごとの分離度(distinctiveness in internal space)が高いことが観測され、このことはASR(自動音声認識)性能の向上とも相関していました。

4. ゼロショット性能、つまり学習に使っていない新しいタスクへの適応力においても、オランダ語特化モデルはオランダ語タスクに限っては非常に効率的に働きました。ただし、他言語タスクへの拡張性は劣る場合もありました。

■ 技術的な重要ポイント:Wav2Vec2のようなSSLモデルにおける言語特化学習の利点

自己教師あり学習では、ラベルなしの大量データを使用してモデルが「何かしらの抽象的な知識」を獲得します。その精度や内容は、トレーニングされたデータの性質、範囲、音素体系、イントネーションの傾向に強く依存します。本研究の結果、「自国語に特化した事前学習」は、他の言語や混合データによる汎用的な学習を上回って、より効率よく言語固有の特徴(発音パターン、語彙分布など)を内部に保持しうる可能性が示されました。

特に少数言語やリソースが限られた言語で音声認識性能を高めたい場合、その言語に特化したトレーニングは、自己教師あり学習において非常に有効な戦略だといえるでしょう。

■ 社会的・実用的意味

オランダ語は比較的リソースのある言語とはいえ、英語などに比べるとデータ規模は限定されています。今後、アフリカ諸語、アジアの方言、少数民族の言語など、非常に小規模なデータしか取得できない場面においても、「言語特化型」のSSL事前学習は、その限界を克服する手段として期待できます。

また、公共機関や教育機関での音声認識システムで、特定言語(例えば南アフリカのズールー語やカナダのフランス語など)に特化した音声AIを構築する際に、本研究のアプローチは非常に参考になるものです。

■まとめ

この研究は、自己教師あり音声モデルにおいて「言語特化型」の事前学習が、特定言語における内部表現の精度を大きく向上させることを明確に示しました。音声認識や言語処理において、単なるデータ量だけに頼らず、「特定性」や「構造適合性」に着目したアプローチの重要性が再確認されたといえるでしょう。今後の多言語対応AIや、リソースの限られた言語のデジタル支援に向けた重要な技術的知見となるはずです。