生成AIの進化は、ビジネスや研究の現場における情報探索の方法に新たな可能性をもたらしています。その中でも、RAG(Retrieval-Augmented Generation)というアーキテクチャは、大量の非構造化データと生成AIの能力を組み合わせ、前例のない豊かな回答を実現可能にしています。この記事では、Amazon Bedrock上において、LlamaIndexとMistralを活用してエージェント機能を持つ高度な知識探索アプリケーションを構築する方法が紹介されています。以下では、この記事の内容を基に、どのような特徴や技術的なポイントがあり、どのようなメリットがあるのかをわかりやすく解説していきます。

目次

1. エージェント的RAGアプリケーションとは?

2. なぜAmazon Bedrockを使うのか?

3. 使用される主要コンポーネント:LlamaIndexとは?

4. 高性能な言語モデル:Mistralの概要

5. アーキテクチャの全体像

6. ステップ・バイ・ステップ:実装の流れ

7. エージェント機能の統合

8. セキュリティとスケーラビリティ

9. 応用例:どのような業務に役立つのか?

10. まとめ

1. エージェント的RAGアプリケーションとは?

RAG(Retrieval-Augmented Generation)は、単に生成AIに質問して答えを得るのではなく、大量の外部情報(ベクトルDBやドキュメントストアなど)から関連資料を検索し、それをもとに回答を生成するスタイルのアプローチです。

そして、それにエージェント機能を結びつけたものが「エージェンティックRAGアプリケーション」です。これは、1つの質問に対してただ回答を生成するだけでなく、複数ステップにわたってデータを検索・要約し、必要に応じて自動的に情報取得のプロセスを進めるような“思考プロセス”を内包したシステムです。

例えば、ユーザーが「2023年のAI技術の発展について概要を教えて」と質問したとき、システムはまず関連文書を検索し、それらを読み解き、さらに情報が不足していれば追加の問い合わせを自律的に行うという動作が可能になります。

2. なぜAmazon Bedrockを使うのか?

Amazon Bedrockは、さまざまな生成AIモデル(Anthropic、AI21 Labs、Meta、Amazon Titanなど)をAPI経由で簡単に活用できるマネージドサービスです。インフラの構築が不要で、セキュリティもAWSネイティブな仕組みによって担保されているため、エンタープライズレベルの安全性と拡張性が求められる商用環境でも安心して使用できます。

Bedrockを使う利点は以下の通りです:

– 複数の高性能なLLM(大規模言語モデル)を単一インターフェースで統合使用可能

– データはAWS環境内にとどまり、セキュリティとガバナンス管理がしやすい

– サーバレスな構成でスケーラブルかつコスト効率が高い

3. 使用される主要コンポーネント:LlamaIndexとは?

LlamaIndex(旧称:GPT Index)は、外部の非構造化データを生成AI(LLM)と連携させるためのミドルウェアのような存在。データのインデクシング、検索、取り出し処理を簡単に統合し、生成AIからの質問に対して、文脈と根拠となるデータを的確に渡すサポートをしてくれます。

LlamaIndexのメリット:

– 多様なデータソース(ファイル、API、データベースなど)から容易にインデックス作成が可能

– ChatGPTのようなLLMに特化したクエリ処理ができる

– データ構造が柔軟で、カスタムモジュールとの連携も容易

4. 高性能な言語モデル:Mistralの概要

Mistralは、高い性能と効率性を兼ね備えた新しいLLMであり、特にコード生成や高度な推論に強みがあります。Amazon Bedrockでは、Mistralをモデル選択肢の1つとして導入しており、その精度と応答速度の高さから今回のエージェント型RAGシステムにも適しているとされています。

Mistralの特長:

– より小規模でも高品質なアウトプットが得られるためコスト効率が良い

– マルチタスク処理に適しており、複雑なプロンプトでも的確に対処可能

– 意味論的理解力が高く、入力文章の文脈に非常に敏感

5. アーキテクチャの全体像

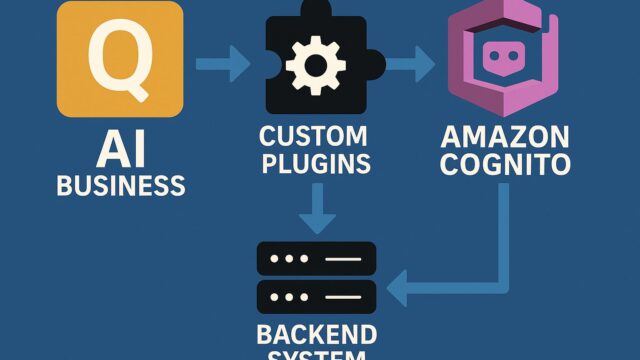

このエージェンティックRAGアプリケーションは、以下のような構造で構築されます:

– フロントエンドUI: ユーザーからの入力を受け取り表示するインターフェース

– Bedrock API: Mistralなどのモデルを呼び出す役割

– LlamaIndex: 検索・取得されたデータをベクトル形式で管理

– VectorDB(例:FAISS、Pinecone、OpenSearchなど): 文書検索のためのバックエンド

6. ステップ・バイ・ステップ:実装の流れ

(1)データの準備とインデクシング

企業内部のWord、PDF、HTMLなどの文書をLlamaIndexによって読み込み、インデックシングします。

(2)ベクトルデータベースへの格納

インデックスされたデータはベクトルDBに格納され、意味理解に沿った検索が可能な状態になります。

(3)プロンプト設計

Mistralに向けたプロンプトを設計し、情報取得 + 応答生成のワークフローを作成します。

(4)エージェントロジックの設定

LlamaIndexのツール連携機能を使い、質問に対して複数のアクション(検索→取得→要約→再質問)を実行できるようエージェントの「思考ループ」を構築。

(5)Bedrock経由でMistralを呼び出す

検索文書とプロンプトを組み立て、Bedrock API経由でMistralを呼び出し、応答を画面やAPI出力として返します。

7. エージェント機能の統合

LlamaIndexを利用することで、RAGの振る舞いにエージェント的動作を追加できます。このエージェントは、ChatGPTのようなモデルに「これは何をするための情報収集か?」という自己ループを設定し、回答が不足していれば追加の情報取得を繰り返すことができます。

さらに、サードパーティツールとの統合も容易であり、社内データベース、インターネット上の情報、あるいはAPI経由の外部データも処理対象とすることができます。

8. セキュリティとスケーラビリティ

Amazon Bedrock上に構築されるため、データはAWSのセキュリティ基準に則った保護がされています。アクセス制御、監査ログ、暗号化オプションもそろっており、企業での本番利用で求められる要件を満たします。

また、サーバレスベースであるため、負荷に応じて自動スケールし、多数のユーザが同時利用してもレスポンスが落ちにくいという利点も大きいです。

9. 応用例:どのような業務に役立つのか?

このエージェント型RAGアプリケーションは、以下のような業務に有効です:

– 顧客からの質問に対するFAQボット(社内ナレッジデータと連携)

– 法務・契約文書の要約と検索

– コールセンターオペレーター支援(リアルタイム情報探索)

– 医療、製薬業界での論文検索と分析

– エンジニア向けコード検索および生成支援

10. まとめ

生成AIの真価は、「どのように活かすか」によって大きく変わります。今回紹介されたAmazon Bedrock上のLlamaIndexとMistralを活用したエージェント型RAGアプリケーションは、従来型のチャットボットや質問応答システムに比べて大幅に知的な動作が可能となっています。

企業のDX推進において、既存の文書資産の活用は避けて通れないテーマですが、本ソリューションはまさにその橋渡しとして非常に有望です。現実の業務ニーズに直結した応答生成が求められる中で、今回の構成はその課題を効率的に解決する道を示してくれるでしょう。

AI技術の進化は速いですが、このようにしっかりとしたアーキテクチャ設計とセキュリティ体制のもとで活用することで、信頼性の高い知識発見を実現する第一歩となるのです。