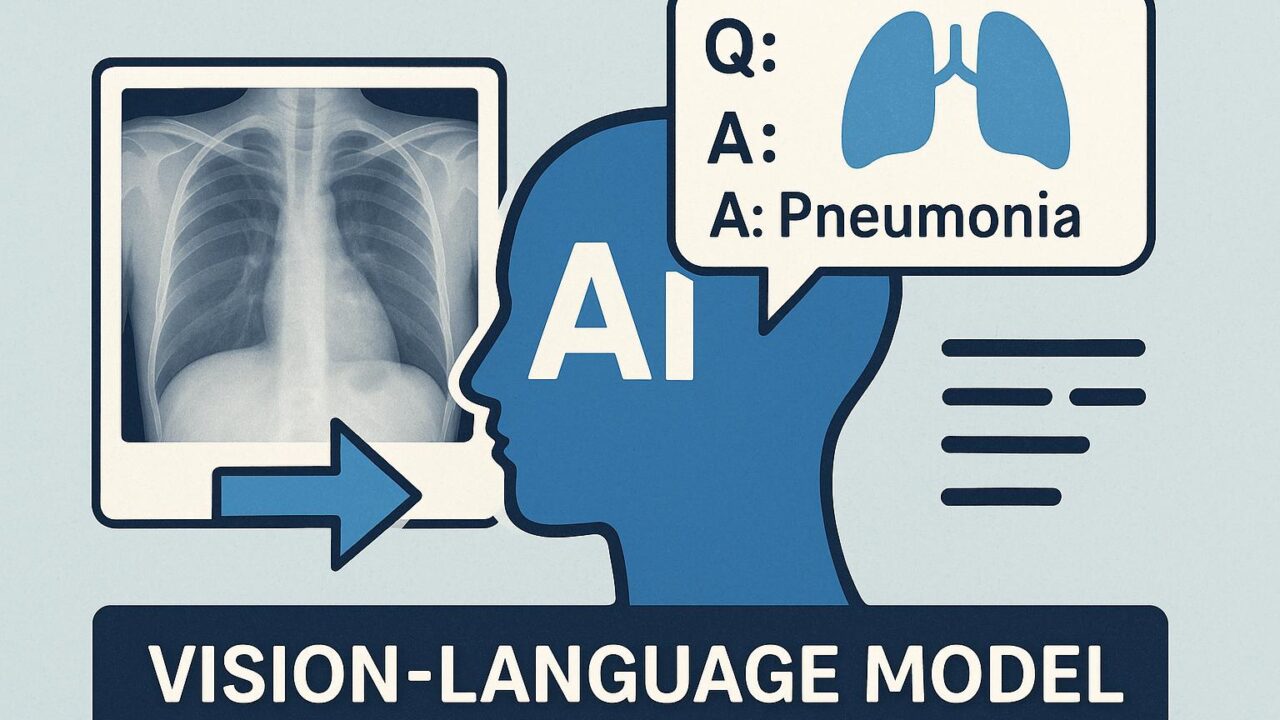

近年、医療分野におけるAIの応用が急速に進展しており、なかでも画像と自然言語を組み合わせた「大規模画像-言語モデル(Large Vision-Language Models、以下 LVLMs)」は、胸部X線画像の解析においても期待されています。自動で診断レポートを生成したり、医療に関する質問に画像をもとに回答する「Visual Question Answering(VQA)」などのタスクで成果を挙げつつあります。

しかし、これまでLVLMsを評価する基準は、最終的な診断結果だけに注目しており、「診断結果に至るまでの推論プロセス」が医学的に正しいかどうかは、あまり評価の対象になっていませんでした。

この課題に対処するため、MITを中心とした研究チームは、構造化された医学的推論力をLVLMsが持っているかどうかを評価できる新たなベンチマーク「CXReasonBench(シーエックス・リーズン・ベンチ)」を開発し、論文として発表しました。

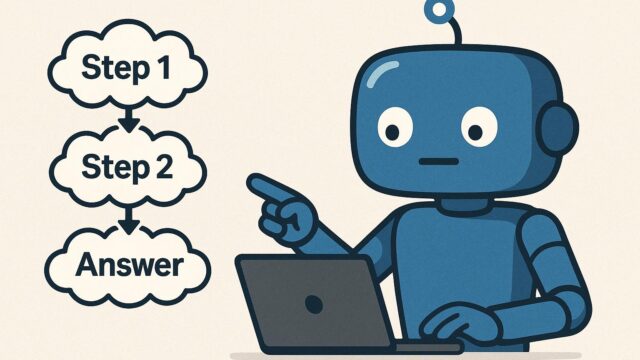

■構造化診断推論とは?

現実の医療現場では、医師は「画像を見る → 解剖学的な構造を特定する → 測定や確認を行う → 指標と照らして判断する → 最終判断を下す」といった複雑な推論プロセスを経て診断を行います。

単なる「この患者は肺炎である」といった結論だけでなく、「胸部X線画像のここにこのような特徴が見える → この位置関係や大きさは正常時と比べて異常である → これは診断基準で定義された閾値を超えている → よって肺炎である」といった、段階的で根拠に基づいた構造的な判断が重要です。

こうした構造化された推論力こそが、AIが医療現場で安全に活用されるために必要とされているものなのです。

■CheXStructとCXReasonBenchの仕組み

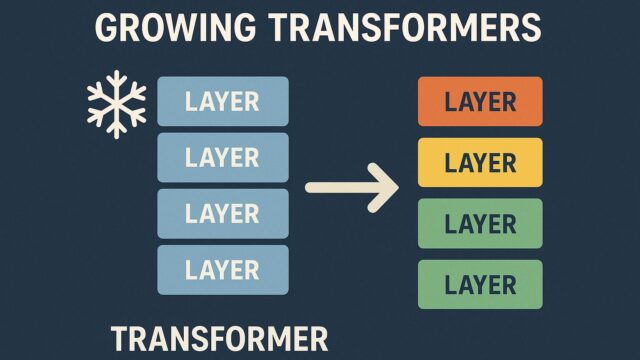

研究チームはまず、「MIMIC-CXR-JPG」という、1万件以上の実際の胸部X線画像とそれに対する診断結果が紐づいたオープンデータを活用し、「CheXStruct(チェックス・ストラクト)」という自動処理パイプラインを構築しました。

CheXStructは以下のような推論ステップを自動的に生成します:

– X線画像から肺や心臓などの解剖学的部位をセグメンテーション

– 解剖学的ランドマーク(目印)を抽出

– 心胸比(心臓の幅/胸郭の幅)や肺野の透過度などの診断用指標を測定

– 医学的な診断閾値と比較して異常の有無を判断

さらに「CXReasonBench」はこのCheXStructによる構造化推論ステップを活用し、「LVLMがこのような複雑で段階的な医学的思考パターンを学ぶことができるか?」を評価するベンチマークです。

このベンチマークでは、

– 解剖学領域を画像上で正確に指し示せるか(Visual Grounding)

– 正しい基準に基づいて測定や判断ができるか

– 段階的なステップを経て診断に至れるか

といった多角的な評価項目が設定されています。

実際にこのベンチマークでは、12の診断関連タスクに渡って18,988件のQA対と1,200症例が用意されており、LVLMによる「多段階・多分岐的な臨床推論能力」を検証できます。

■最先端のLVLMでも「想像以上に苦戦」

本研究の注目すべき結果は、「現在最も優れたとされる10種類のLVLM」であっても、この構造化された診断推論においては高精度なパフォーマンスを発揮できなかったという点です。

具体的には:

– 多くのモデルが画像内の解剖学的部位を正しく同定できない

– 測定値を元に閾値を当てはめるといった基本的な判断を間違える

– テキスト知識は持っていても、画像での具体的な特徴と結びつけられていない

など、根本的な理解や医学的な思考に基づく推論ができていないことが明らかになりました。

これは、多数のネット上の一般画像と言語を学習してきたLVLMにとって、胸部X線という「非常に専門的かつモノクロで微妙な情報」を含む画像を医学的な文脈で理解することがまだ難しいということを示しています。

■技術的観点から見た意義と今後の展望

本研究は、単にLVLMの性能を測る基準を変えたというだけでなく、AIが「医学的文脈で信頼できるロジックを持った推論を行えるか」という、より深い問題提起をしています。

従来のベンチマークでは、最終的な診断結果さえ正しければ良しとされていたのに対し、CXReasonBenchは「なぜその診断に至ったのか?」を問う構造的なアプローチで、AIの医療応用においては非常に重要な観点です。

今後AIが医療現場で使われるためには、以下の技術的発展が必要とされるでしょう:

– 医療画像に特化した学習データの増強

– 医師の推論過程を模倣した構造化モデルの導入

– 定量的な測定や閾値判断といった「数式ベースの医学知識」の明示的な学習

また、CXReasonBenchのような透明性の高い評価基準の登場により、「AIの何が足りないのか」「どのような情報を学習すべきか」がより明確になりました。このような高精度で構造的なベンチマークは、信頼できる医療AI開発の要となるでしょう。

論文・データ・コードはすべてGitHub上でオープンに公開されており(https://github.com/ttumyche/CXReasonBench)、今後さらなる研究者や医療AI開発者によるコントリビューションが期待されています。