本記事では、Amazon Web Services(AWS)が提供する最新の生成AI(ジェネレーティブAI)サービスを活用し、マルチモーダルなRetrieval-Augmented Generation(RAG)アプリケーションを構築する方法をご紹介します。RAGアーキテクチャは、生成AIモデルに最新の情報を付加し、高精度かつユーザーニーズに即した回答を生成するための効果的な手法です。特に、Amazon BedrockとそのKnowledge Bases、Data Automationといった新しい機能を用いることで、従来よりも迅速かつ柔軟にRAGアプリケーションが構築可能となりました。

本記事は、AWS公式ブログ「Building a multimodal RAG based application using Amazon Bedrock Data Automation and Amazon Bedrock Knowledge Bases」の内容をもとに、生成AIを活用したマルチモーダルRAGアプリケーションの仕組みや、その構築方法について分かりやすく解説します。

RAGとは何か?従来のLLMとの違い

大規模言語モデル(LLM: Large Language Model)は、驚くほど自然な文章生成ができる反面、知識の更新頻度が低く、古い情報を返すことがしばしばあります。たとえば、「2024年の法制度に関する質問」に、モデルの学習時点(たとえば2022年まで)での情報をもとに回答してしまうと、ユーザーに誤った判断を与える可能性があります。

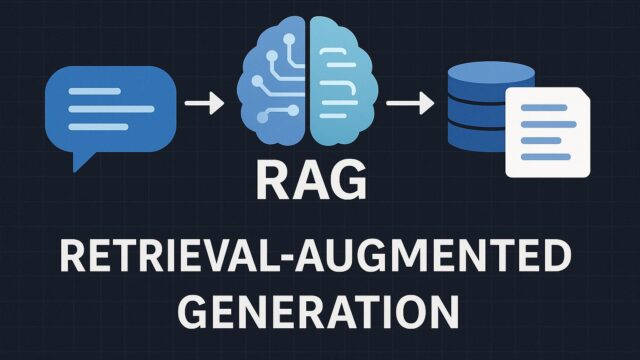

そうした課題を解決するために登場したのがRAG(Retrieval-Augmented Generation)です。これは、質問に対して事前に関連する外部データ(ドキュメント、マニュアル、FAQなど)を検索・取得し、その文脈をもとにLLMが回答を生成するという仕組みです。これにより、常に最新かつ正確な情報に基づいた応答が可能になります。

RAGは以下の2つの主なフェーズから構成されます:

1. リトリーバル(検索):質問の意図に近い情報をドキュメントストアや外部データソースから検索

2. ジェネレーション(生成):取得した情報をプロンプト文に組み込み、LLMに回答を生成させる

Amazon Bedrockとは?

Amazon Bedrockは、AWSにおける生成AIアプリケーションの構築を支援するフルマネージドサービスです。Anthropic Claude、Meta Llama 2、Amazon Titanなど、複数のLLMをAPIとして簡単に利用できる点が特徴です。Amazon Bedrockを用いることで、LLMの選定・管理・インフラ構築の煩雑さを回避しつつ、高度なAIアプリケーションを迅速に展開可能となります。

加えて、Amazon Bedrockでは、Bedrock Knowledge Basesと呼ばれる機能が提供されており、これはユーザー独自のドキュメントやデータソースをベースにRAGアプリケーションを構築するための重要なコンポーネントです。また、Data Automation機能によってデータの変換や同期などのプロセスも自動化され、開発者がよりロジック部分に集中できる環境が整っています。

マルチモーダルRAGとは?

ここで、従来のテキスト情報のみを扱うRAGから一歩進んだ「マルチモーダルRAG」についてご紹介します。マルチモーダルとは、「複数のデータ形式を統合する」ことを意味します。たとえば、テキスト・画像・音声・動画など、異なる形式の情報を適切に処理し、LLMに連携することで、より包括的で直感的な回答を提供できるようになります。

本記事で紹介されたデモケースでは、「画像とテキストの両方を理解し、それに基づいてユーザーの質問に回答する」というマルチモーダルAIエージェントの構築に成功しています。これは、たとえばカスタマーサポート、教育分野、製品マニュアル参照など多岐にわたる用途があり、今後のAI活用シナリオの可能性を広げるものです。

アーキテクチャの全体像

今回紹介された構成は、以下のようなコンポーネントで構築されました。

1. フロントエンド:Amazon S3を使ってホスティングされた簡易的なWeb UI(ユーザーが質問や画像をアップロードする部分)

2. バックエンド:

– AWS Lambda:入力の前処理・API呼び出しのルーティング

– Amazon API Gateway:HTTP APIの公開

– Amazon Bedrock:LLM呼び出し(Anthropic Claudeなど)

– Amazon Bedrock Knowledge Bases:関連情報の検索・強化

– Amazon Kendra:エンタープライズ向け検索バックエンド

– Amazon DynamoDB:チャット履歴やメタデータの保存

– Amazon S3:アップロードされた画像やファイルの保存

3. 分析・ログ用途:

– Amazon CloudWatch:ログモニタリングやエラー検知

– Amazon CloudTrail:すべてのAPI呼び出しログの保存

この構成により、ユーザーが入力したテキストや画像に対し、自動的に関連情報を検索し、高品質な回答をリアルタイムで生成するシステムが運用可能になります。

Knowledge BasesとData Automationの連携

新たに追加された2つの重要な機能「Bedrock Knowledge Bases」と「Data Automation」は、今回のアプリケーション構築において中心的な役割を果たしています。

Knowledge Basesは、構成したデータソース(たとえばPDF、Word、HTMLなど)をベクトルデータベースに変換し、Amazon Kendraなどの検索エンジンと連携することで、意味的な一致性をもとに最適なドキュメントをLLMで使用できるようにする仕組みです。

Data Automationは、対象とするデータソースの更新・変換・同期を自動的に行うフレームワークです。企業内のドキュメント管理ソリューション(SharePointやGoogle Driveなど)とも連携でき、RAGアプリケーションで使用する知識の最新性を保証します。

開発者の役割は、どのデータをKnowledge Baseへ登録するか、回答生成のプロンプトテンプレートをどう設計するかという論理構築部分に集中することが可能になり、効率的かつ堅牢なRAGアーキテクチャの構築が実現されます。

活用ユースケース

AWSが提案するこのマルチモーダルRAGソリューションは、さまざまな業界・ユースケースに応用可能です。以下はその例です:

1. 医療分野:

医師や看護師が患者の診療データ(テキスト・X線画像など)を同時に解析し、診断支援やアドバイスを生成

2. 法律・コンプライアンス:

法的文書や契約書を読み解き、質問に対して関連する条文や文書を引用しながら回答

3. カスタマーサポート:

製品マニュアルとユーザーが撮影・送信した製品画像を併せて参照し、具体的な解決策を提案

4. eラーニング:

教材(PDFや図版)と質問を統合し、理解促進のための対話型チューターを自動化

まとめ

生成AIの発展とともに、AIアプリケーションは従来の“モデル精度頼み”から、“どのような文脈でどのようなデータを補強するか”を技術戦略の中心に据えるようシフトしています。今回ご紹介したAmazon Bedrockの機能群、特にKnowledge BasesおよびData Automationは、この潮流において極めて有用なツールであり、RAGアーキテクチャを手元で簡単に実装できるようになります。

開発者にとっては、エンタープライズアプリケーション開発の時間とリソースを大幅に削減できる一方、ユーザーにとってはよりパーソナライズされ、信頼性・利便性の高いAI体験が提供可能になるでしょう。

多くの分野での導入が視野に入る今、マルチモーダルRAGアーキテクチャは、まさに生成AI新時代の起点となるべきテクノロジーです。AWSを活用することで、そのスタートラインに立つことがこれまでになく容易になっています。

参考リンク:

公式ブログ原文:https://aws.amazon.com/blogs/machine-learning/building-a-multimodal-rag-based-application-using-amazon-bedrock-data-automation-and-amazon-bedrock-knowledge-bases/