音声認識と話者識別の革新:Hugging Face Inference Endpointsで可能になる次世代AI音声処理

近年、人工知能(AI)による音声認識技術(ASR: Automatic Speech Recognition)は目覚ましい進化を遂げています。特に、会議やインタビューといった多人数が関与する音声データにおいては、誰がいつ話したのかを正確に識別する「話者識別」(diarization)が重要な役割を果たします。この分野において、Hugging Faceが発表した最新のイノベーション「Powerful ASR + diarization + speculative decoding with Hugging Face Inference Endpoints」は、音声処理のあり方を根本から変えるポテンシャルを秘めています。

本記事では、Hugging Faceが提供するこのソリューションがどのような技術的要素で成り立ち、現実世界の応用においてどのような可能性を切り開くのかを、分かりやすくご紹介します。

音声認識+話者識別:これまでの課題

これまで音声認識と話者識別は、それぞれ異なるプロセスで行うのが一般的でした。まず音声ファイルをテキストに変換(ASR)し、その後で話者の切り分け(diarization)を行うという流れです。この2段階の処理は、モデルの推論負荷が高く、出力されたテキストと話者のタイムスタンプがずれるなど、実用上の問題も多く存在しました。

特に、会議録や電話会話のようなリアルタイムあるいは長時間の音声を扱う場面では、処理速度と精度のバランスが大きな課題となっていました。また、あらかじめ決められた話者数でなければ認識精度が下がる場面や、話者がすぐに交代するカジュアルな会話への対応が困難なこともありました。

Hugging Face Inference Endpointsとは?

こうした従来の制約を乗り越えるために、Hugging Faceが開発したのが「Inference Endpoints」です。これは、自分だけのパフォーマンスチューニングが施された機械学習モデルをクラウド環境に最適導入できるソリューションです。

つまり、開発者はHugging Face Hubにあるモデルを選択し、そのまま数クリックでエンドポイントとして稼働させることができるというものです。この環境を使えば、自分に最適な音声認識+話者識別モデルをクラウドで高速かつ柔軟に動かすことが可能になります。特に、常時起動可能でスケーリングも自動、セキュリティも担保されるこの仕組みは、多くのビジネス現場での即時使用を可能にしています。

Whisperモデルとpyannote.audioの統合

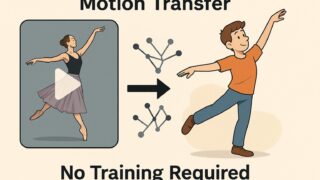

今回紹介されているのは、OpenAIが開発した「Whisper」モデルを使った音声認識と、「pyannote.audio」という話者識別ライブラリを組み合わせたソリューションです。

Whisperは高度なノイズ耐性と多言語対応力を誇る音声認識モデルで、一般的なバックグラウンドノイズや話者のアクセントにも非常に強い認識性能を示します。一方、pyannote.audioは、会話中の誰がどのセクションを話したかを高精度に認識し、タイムラインごとに切り分けて表現する力に優れています。

これらをHugging FaceのInference Endpoints上で統合すれば、音声から直接「誰が何をいつ話したか」という情報を一挙に取得できるワンステップなワークフローが実現されます。これは、従来の非統合的なアプローチに比べ、精度や可読性が飛躍的に向上することを意味します。

Speculative Decodingの導入:推論の高速化への鍵

さらに、今回の発表でもう一つ注目されるのが「Speculative Decoding」と呼ばれる技術の導入です。これは、Transformer系の大規模言語モデルや音声認識モデルで使用される次の単語予測工程を高速化する手法です。

具体的には、「推定モデル(Draft Model)」を用いて短時間で予想される出力候補を提示し、本命モデルがそれらを検証していくという仕組みです。この仕組みにより、推論スピードが劇的に向上しながらも、出力のクオリティは高品質に保たれます。

このテクニックを音声認識に活用することで、従来よりも低レイテンシかつ高精度なテキスト化が可能になり、リアルタイムでの文字起こしなどに非常に有望とされています。

ユースケース:業務効率化とアクセシビリティ向上の鍵に

この統合ソリューションの活用場面は非常に広範囲に及びます。例えば以下のようなユースケースが想定されます。

– オンライン会議の自動文字起こしと議事録作成:話者ごとの発言を忠実に記録することで、議論の透明性向上と聞き逃しの防止に役立ちます。

– カスタマーサポート通話の解析:顧客とオペレーターの発言を分離して記録することで、顧客対応の質の監査や改善に役立ちます。

– 教育・講義コンテンツの字幕生成:複数人によるディスカッション形式の講義でも、誰が話したか明示されたスクリプトが得られます。

– 医療通訳・診療記録の自動化:ドクターと患者の会話をログとして残す際にも実用的です。

さらに、音声認識と話者識別の自動化は、聴覚障害を持つ方々への情報提供手段としても非常に強力なツールとなりうるでしょう。

まとめ:次世代の音声AIが既に現実のものに

Hugging Faceが提供する「ASR + Diarization + Speculative Decoding」の統合ソリューションは、音声認識技術の可能性を一段と広げる革新的な提案です。単なる音声の文字起こし以上に、「誰が何を話したのか」を高精度でリアルタイムに抽出することで、デジタルコミュニケーションの質と効率を格段に向上させることができます。

しかも、それがクラウドベースで簡単に活用可能という点で、開発者だけでなく多くの企業・団体にとって実用的かつすぐに導入可能な技術となっています。

今後、こうした技術がさらに洗練されることで、より多くの人々がAIの恩恵を享受できる時代が訪れることでしょう。音声という情報源の価値が、テキストと同等、あるいはそれ以上に評価される未来へと一歩近づいたとも言えるのではないでしょうか。