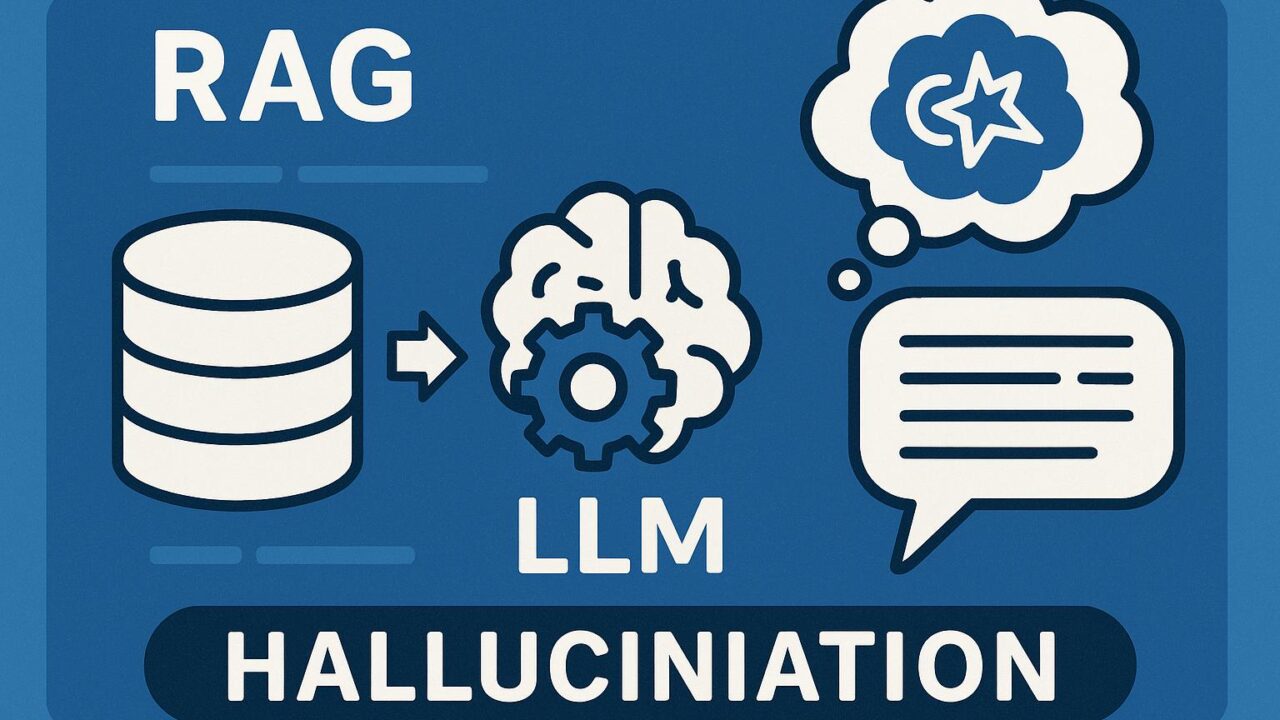

近年、生成AIの発展によって、自然言語を使ったさまざまな対話システムやコンテンツ生成ツールが急速に普及しています。その中でも、特に注目を集めているのが「RAG-based systems(Retrieval-Augmented Generation)」と呼ばれる手法です。これは、大規模言語モデル(LLM)と外部データベース(ドキュメントや検索システム)を組み合わせることで、より現実に即した回答やコンテンツ生成を目指すアーキテクチャです。

今回紹介するAWSの公式ブログ「Detect hallucinations for RAG-based systems」では、RAGを活用したシステムにおける「ハルシネーション(hallucination)」の発生問題に焦点を当て、それをどのように検出し、品質を向上させていくかという点にフォーカスしています。本記事では、このAWSの技術情報を元にしつつ、RAGやハルシネーションの基本的な考え方から、課題、そしてその解決策までをわかりやすく解説していきます。

RAGとは何か?

まず、RAG(Retrieval-Augmented Generation)に関する基本的な理解から始めましょう。RAGは、「情報検索(retrieval)」と「大規模言語モデルによる生成(generation)」の2つを融合させたアプローチです。通常のLLMは、学習時点で取り込んだ知識だけを元にテキストを生成しますが、新しい情報や特殊な専門知識などを必要とする場合には不十分なケースがあります。

RAGではこの課題を補うために、生成前のステップで関連するドキュメントを外部から検索(例えばElasticsearchやAmazon Kendraなど)し、それらを基にLLMがテキストを生成します。これにより、現実に即したより正確で情報に基づいた出力が可能になると期待されています。

ハルシネーションとは何か?

RAGの利点は上記のように多くありますが、万全なわけではありません。その中で大きな課題として取り上げられるのが「ハルシネーション(幻想)」です。これは、生成された内容が信頼できる情報源に基づいていない、つまり「事実ではないにもかかわらず、もっともらしく見える内容」が出力されてしまう現象を指します。

特にRAGにおけるハルシネーションは厄介です。なぜなら、生成された内容が一見すると検索されたドキュメントに基づいているかのように見えるためです。ユーザが提示された情報を信用してしまう可能性が高く、それが誤情報として広がるリスクも伴います。

具体例を挙げると、法律関連の文書に基づいて回答するはずのRAGシステムが、「○○という法律は2020年に改正された」と出力するが、実際のドキュメントにはそのような記述が一切ない、といったケースが該当します。

AWSが提案するハルシネーション検出の仕組み

AWSでは、このRAGシステムでのハルシネーションを検出するために、効果的な手法を提案しています。以下にその代表的なアプローチを紹介します。

1. ゴールドスタンダードとの比較

まず基本的な方法として、LLMが生成した回答と、人間が正確と判断した「ゴールドスタンダード」回答を比較することです。これは主にテストフェーズで用いられる方法で、処理の妥当性を人間の評価者が確認する手段です。

ただし、この方法には当然ながら時間とコストがかかります。全件手動でチェックするのは現実的ではないため、大量のデータを扱う本番システムには向かないという課題があります。

2. パッセージとの整合性チェック(検出器の利用)

次に紹介されたのが、「出力された回答と、検索ドキュメント間の整合性を自動的にチェックするモデル(Detector)」の活用です。AWSでは、LLMに対してドキュメントの範囲内にあるかどうかを明確に確認させ、それがどのドキュメントから根拠を得ているかを示す手法を採用しています。これはファクトチェッカーのように、出力された内容が根拠資料と一致しているかを自動で評価するシステムです。

具体的には、BERTやRoBERTaなどの事前訓練済みのトランスフォーマーモデルを使って、文と文の意味的な類似性や矛盾を検出するアルゴリズムを応用し、LLMの出力とドキュメントの間に矛盾がないかを確認するという流れです。これにより、ハルシネーションの可能性がある出力を高い精度で検出することが可能になります。

3. メタデータによる文脈管理とQAモデルの活用

ここで重要なポイントとして指摘されていたのが、「文脈をいかに管理するか」という視点です。RAGシステムでは、検索で得られた複数のパッセージ(文書片)をどのようにLLMに与えるかが大きな鍵になります。AWSでは、ドキュメントから抽出されるパッセージにはメタデータ(出典、信頼度、ドキュメントIDなど)を付与することで、後工程でのトラッキングやハルシネーション検出に活用しています。

また、質問応答スタイルのQAモデルを導入することで、「この質問に対してこのドキュメントは十分な情報を持っているか?」、「それに基づいてLLMの回答は妥当か?」を多角的に評価できます。これは信頼性の定量的な測定にもつながるため、より透明性の高いシステム運用を可能にします。

実装と評価

記事内では、これらの手法を使ってどのようにハルシネーションの確率を下げるかを実際に検証した結果も紹介されています。評価には、Precision(適合率)、Recall(再現率)、Accuracy(正確性)などの指標が使われました。

例えば、DetectorモデルとQAモデルを併用することで、通常のハルシネーション検出率よりも20%以上の精度向上が得られたという報告もされています。こうした数字は、最終的にユーザーの信頼性やプロダクト品質に直結する要素であるため、ビジネスにおける価値も非常に大きいといえます。

よりよいRAGシステムのために

AWSが開発しているハルシネーション検出の技術は、単に正確性を高めるだけでなく、「生成AIを安心して使えるものにする」という視点で非常に有意義です。特に医療、法律、教育、金融など、正確性が強く求められる業界においては、単なる生成の能力以上に、「間違いがないこと」「出力の根拠が明確であること」が求められます。

RAGは、そのような信頼性重視のユースケースでの利用に適したアプローチですが、同時にその課題やリスクも理解しておく必要があります。そして、今回のようなハルシネーション検出手法を組み合わせることで、より実用的で安全なAI応用が可能になるのです。

まとめ

生成AIは急速に進化し、私たちの生活やビジネスに数々の利便性をもたらしつつあります。その中で、RAGのようなアーキテクチャは、正確な情報生成に欠かせない技術の一つとして多くの注目を集めています。

しかし、「正しい情報」を生成するためには、ハルシネーションのような根本的な課題を解決する必要があります。AWSが提案する多段的なハルシネーション検出手法は、この分野における大きな前進であり、他の開発者や研究者にも参考になる内容です。

RAGシステムの導入や検討を進めている方にとって、本記事で紹介された仕組みや考え方は、今後の品質管理やシステム設計において重要なヒントになるはずです。今後もこうした進化を注視しながら、安全性と信頼性のある生成AIの実現に向けた一歩を着実に進めていきましょう。