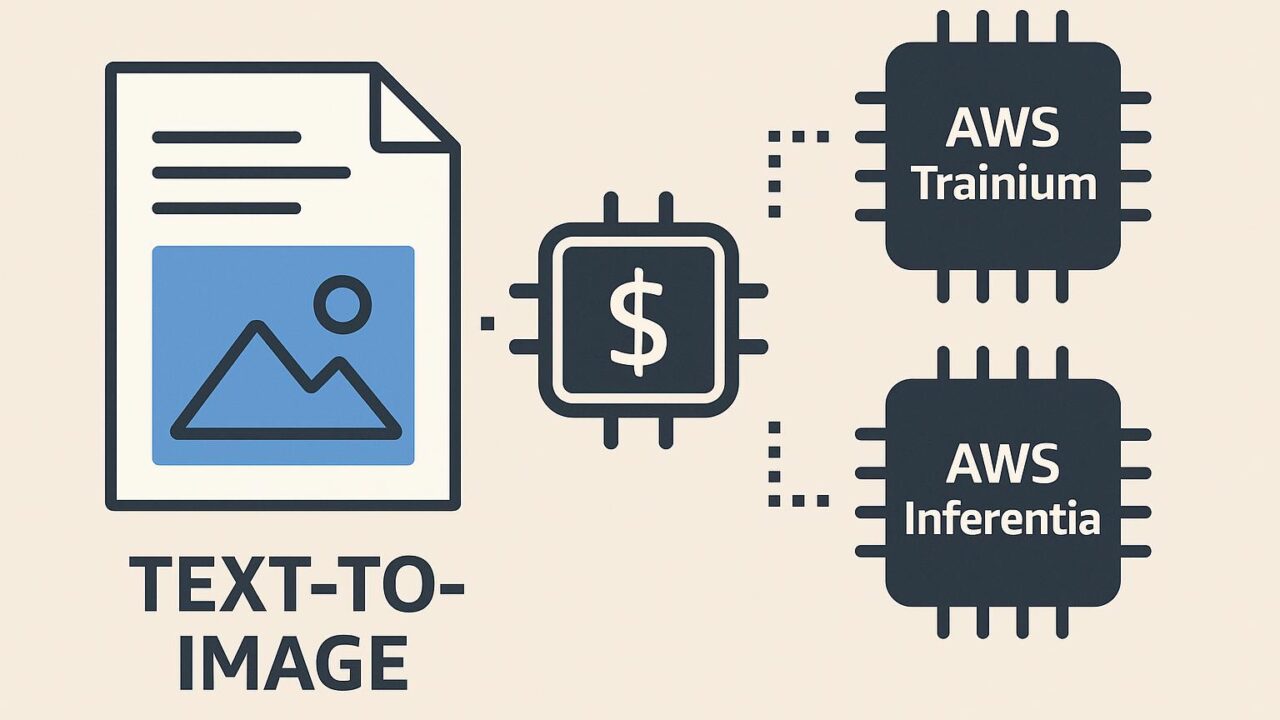

AI画像生成をコスト効率よく実現する:PixArt-Σ 推論によるAWS TrainiumとAWS Inferentiaの活用

近年、生成AI(Generative AI)の発展が目覚ましくなり、画像生成の分野ではテキストから高品質な画像を生成するモデルが注目を集め続けています。このようなAI画像生成技術は、広告、ゲーム開発、映画制作、Eコマースなど多岐にわたる業界で応用が進んでおり、実用性の高さを背景に企業や開発者から強い関心が寄せられています。

ただし、こうした高度なAIによる画像生成は、その精度と高性能ゆえに、大量の計算資源を必要とする場合があります。特に生成モデルのトレーニングや推論(inference)に要するコストは多くの開発者や企業にとって無視できない課題です。

こうした中、Amazon Web Services(AWS)は、コスト効率と性能を両立するためにGPUではなく、独自開発した機械学習専用チップ「Trainium」および「Inferentia」(第2世代)を提供しています。これらのカスタムASIC(特定用途向け集積回路)は、AWSが独自に開発したもので、高性能でエネルギー効率にも優れた機械学習ワークロード実行環境として注目されています。

今回は、最新の生成AIモデルである「PixArt-Σ(PixArt-Sigma)」をAWS TrainiumとAWS Inferentiaを用いて推論することで、コストを抑えながら高品質な画像生成を達成するソリューションが紹介された、AWS公式ブログの内容をわかりやすく解説します。

PixArt-Σとは?

PixArtシリーズは、テキストから高画質な画像を生成することを目的とした、大規模な学習に基づく拡散型変換モデル(Diffusion Transformer)です。特にPixArtにおいては、Text-to-Image(T2I)生成において、推論速度・画質の両面で優れた性能を発揮することが知られています。

PixArt-ΣはPixArtシリーズの最新モデルであり、小さなモデルサイズでも非常に高い画像生成の品質を実現するという特徴を持っています。この特性により、PixArt-Σは推論ワークロードにも最適化されているため、コスト効率のよい画像生成が現実のものとなります。

しかしながら、このような生成モデルに対してGPUベースのインスタンスを用いると、ハードウェアコストが高騰する可能性があるため、より安価かつ電力効率の高い推論環境が求められてきました。ここで、その解決策として注目されるのが「AWS Trainium」と「AWS Inferentia」なのです。

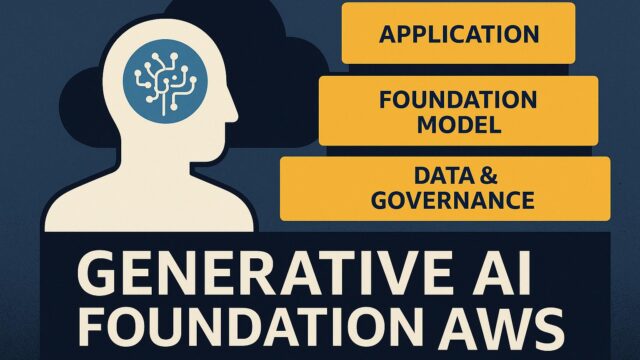

AWSが提供するカスタムAIチップ:TrainiumとInferentia

AWSは、GPUに依存しない新しい次元の機械学習専用プロセッサを開発しました。Trainiumは機械学習モデルのトレーニングに最適化されたチップであり、一方、Inferentia2(Inferentiaの第2世代)は推論用に設計されたカスタムチップです。これらは、Amazon EC2上で実行可能なNeural Computeインスタンス(Trn1, Inf2など)として提供されています。

– AWS Trainium(Trn1インスタンス):

トレーニング向けであり、大規模モデルの学習コストと時間を削減可能。

– AWS Inferentia2(Inf2インスタンス):

推論向けに設計されており、低コスト・低遅延・高いエネルギー効率が特徴。

これらのチップは、機械学習用に最適化されたTensorFlowやPyTorch、Hugging Face Transformersなどとも連携可能であり、既存のML/DLワークフローを大きく変えることなく導入できます。

PixArt-Σ + AWS環境による推論アーキテクチャ

今回のAWS公式ブログでは、PixArt-Σモデルを以下の組み合わせによって構築し、運用する一連のパイプラインが示されています:

1. Hugging Faceのtransformersライブラリに統合されたPixArt-Σモデルを使用。

2. モデルは、AWS Trn1上でトレーニングされた後、NeurIPS 2023で公開された「Optimum Neuron」ライブラリを用いて、Inf2(Inferentia2)インスタンス向けに最適化。

3. テキスト入力に基づいて画像を生成する推論処理は、Neural Cacheと呼ばれるNeurIPSで発表されたキャッシュ機能を活用し、高速化と低消費電力化を達成。

4. マルチインスタンスでのスケーラビリティも確認され、複数のInferentia2インスタンスで安定した推論速度を確保。

これらの実装はすべて、標準的な機械学習ツールセットとインフラで構成されているため、すでにAWS環境を利用している開発者やデータサイエンティストにとって導入のハードルは低く、コスト節約効果を実感しやすくなっています。

推論コストと性能の観点からの比較

GPUおよびカスタムASIC両方のインスタンスにおける推論性能を比較した実験によると、GPU(例:g5.xlarge)に対してInf2.xlargeでは、同等以上の生成速度を実現しつつ、約22%~37%のコスト削減が可能であると報告されています。PixArt-Σは軽量で高性能なモデルであり、NeurIPSで発表されたように、キャッシュ最適化を活用することで大幅な推論速度の向上も確認されました。

以下は主な性能ならびにコスト面でのまとめです:

– 品質:PixArt-Σは高い画像品質を実現(主観的評価でも非常に高いスコア)

– 推論時間:GPUとほぼ同等だが、レスポンスタイムがわずかに早い

– コスト:GPUと比較して20%以上の削減

– スケール:Inf2インスタンスを容易にスケールアウト可能

AI導入におけるコスト効率は、ただ単に処理速度だけでなく、電力効率やインフラコスト、モデルの展開やメンテナンスの容易さも含めた全体的なTCO(Total Cost of Ownership)で考える必要があります。その点で、AWS TrainiumとInferentiaベースのソリューションは、PixArt-Σのような最新の生成AIモデル展開に対し、現実的かつ優れた選択肢といえるでしょう。

今後の展望と実用シナリオ

このようなコストパフォーマンスに優れたAI画像生成技術は、企業のマーケティングオートメーション、パーソナライズされたデザイン生成、ソーシャルメディア向けのコンテンツ制作などに広く応用されていくと考えられます。

さらに、教育やヘルスケア業界などリアルタイムでの画像生成を必要とする領域でも、低遅延・低コスト・高効率を実現するには、カスタムAIハードウェアの活用が重要となります。

また、フルマネージドなAI開発環境であるAmazon SageMakerや、Hugging FaceのようなMLOpsプラットフォームと連携することで、よりスムーズなモデルデプロイや、エンドツーエンドのワークフロー構築が可能です。

まとめ

PixArt-Σは、小型でありながら非常に高品質な画像を生成できる次世代の生成AIモデルであり、特にコストとエネルギー効率を重視するシナリオにおいて、その真価を発揮します。AWS TrainiumおよびInferentia2を用いた最適化と推論により、多くのユーザーにとって現実的かつ効率的なAI生成技術の導入が実現しました。

コスト効率・性能・スケーラビリティのすべてを考慮した時、今回紹介されたPixArt-ΣのAWS上での活用事例は、これからのAI画像生成の実用的な標準モデルとなりうるポテンシャルを持っています。

AIの民主化が進む現在、こうしたテクノロジーの進歩によって、より多くの人々がアイディアを視覚化し、創造する力を手に入れることが期待されます。AWSとPixArt-Σによる革新的な取り組みは、AI開発の未来にとって大きな布石となることでしょう。