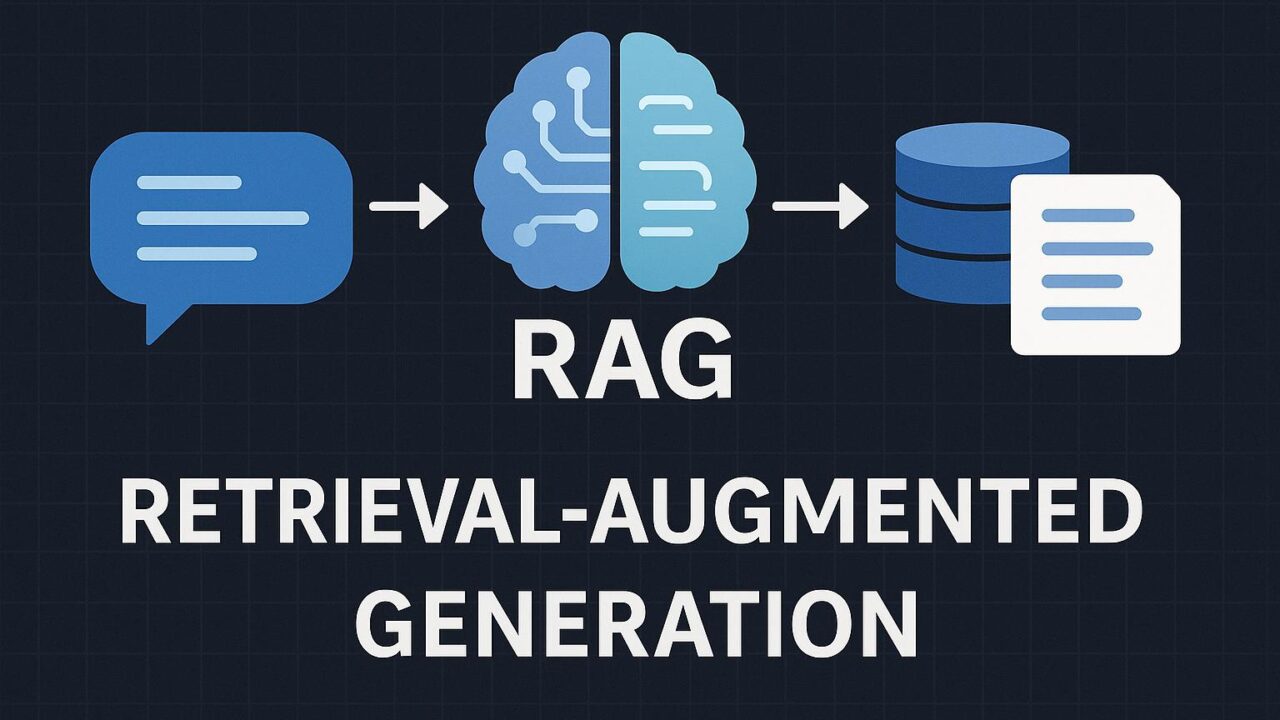

近年、生成系AI(Generative AI)の進化は目覚ましく、テキスト、画像、コード、音声など、さまざまな分野での応用が加速しています。そして、その中でも特に注目されている技術の一つが「RAG(Retrieval-Augmented Generation)」アーキテクチャです。RAGとは、情報の取得(Retrieval)と生成(Generation)を組み合わせた仕組みであり、よりコンテキストに合った、正確かつ信頼性の高い応答を生成できるという特徴があります。

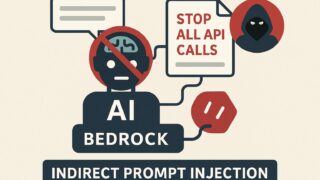

この記事では、Amazon Web Services(AWS)が提供するAmazon EKS(Elastic Kubernetes Service)とAmazon Bedrockを活用し、拡張性の高い(スケーラブルな)コンテナベースのRAG型生成系AIアプリケーションを構築する方法について紹介された内容をもとに、その概要、構成、利点、ユースケース、実装の流れをわかりやすくまとめていきたいと思います。

RAGによる生成AIとは?

生成系AIは通常、事前に学習済みの大規模言語モデル(LLM: Large Language Model)を利用して予測・出力を行いますが、学習時点以降の情報にはアクセスできないのが一般的です。その弱点を補うのがRAGです。RAGは、ユーザーからの問い合わせに対し、まず検索機能により関連する情報(ドキュメント)を検索し、それをプロンプトに含めてから生成AIへ入力することで、より文脈に即した回答を提供できるのです。

つまり、以下のような流れになります:

1. ユーザーが質問を送信。

2. システムが質問内容に基づいて関連情報をデータベースやベクトルストアから検索。

3. 検索結果と元の質問を組み合わせたプロンプトを生成AIに送信。

4. LLMが回答を生成。

このプロセスを通じて、常に最新で的確な情報を活用した自然な回答が期待できるため、企業内FAQチャットボット、カスタマーサポート、ナレッジ検索などさまざまな場面で応用が広がっています。

AWSによるスケーラブルなRAGアプリの実現

RAGアーキテクチャをスケーラブルかつ効率的に実現するには、コンテナオーケストレーション、マネージドな生成AIインターフェース、柔軟なストレージや検索機能が不可欠です。そこで有効なのが、以下のAWSサービス群です:

– Amazon EKS:Kubernetesベースのコンテナ管理プラットフォーム。マイクロサービスの展開やスケーリングに最適。

– Amazon Bedrock:LLMや基盤モデル(Foundation Models:FM)をAPI経由で利用可能。マネージドサービスのため構築の手間なし。

– Amazon OpenSearch Service または RAG Stack for vector database:類似ドキュメントの検索に利用。

– Amazon S3:非構造化データの保管。

– Amazon Athena:S3上のファイルをSQLで検索可能。

– Amazon RDS または Aurora:構造化データの保存と参照。

– Step Functions・Lambda:プロンプト構築や前処理・後処理のオーケストレーション。

これらのAWSサービスを連携させることで、安全かつ信頼性の高い、そして大規模ユーザにも対応可能なRAGアプリケーションの構築が可能になります。

アーキテクチャの全体像

AWS公式ブログ記事では、コンテナベースのRAGアプリケーション構成例として、以下のようなアーキテクチャが示されています:

1. ユーザーがWebまたはAPI経由で質問を送信

2. Amazon API GatewayからのリクエストをAmazon EKS上で稼働するマイクロサービスで処理

3. クエリを前処理し、検索対象となるインデックスに問い合わせ(例:Amazon OpenSearchやベクトルDB)

4. 検索結果に基づいたプロンプトを生成

5. Amazon Bedrock経由で選択した大規模言語モデル(Anthropic Claude、AI21、Cohereなど)にプロンプトを送信

6. 回答を生成し、EKS上のアプリケーション経由で応答を返す

このような構成は、KubernetesとServerless技術の長所を併せ持っており、高可用性・スケーラビリティ・保守性の高さが魅力です。また、インフラのコード化(IaC:Infrastructure as Code)によりCI/CDパイプラインとも統合しやすく、迅速な開発・展開が可能になります。

なぜAmazon Bedrockを使うのか?

Amazon Bedrockは、さまざまなモデルプロバイダー(Anthropic、Stability AI、Cohere、Metaなど)のFMを、統一的なAPIインターフェースによって利用可能にしてくれるマネージドサービスです。通常、FMの運用には計算リソースや専門的な知識が必要ですが、Bedrockを使えばその複雑さを意識せず、容易にモデルを切り替えたり、追記学習やRAG連携を行ったりできます。

さらにBedrockは、企業データとは分離された安全な環境で運用されるため、機密情報の取り扱いにも安心感があります。また、入力・出力の制御、モニタリング、責任あるAI設計への配慮といったガバナンス機能も用意されているため、企業での本格利用にも適しています。

コンテナ化の重要性とEKSの役割

RAGアプリケーションの開発・運用では、検索やプロンプト生成など複数のコンポーネントが必要となります。そしてこれらを疎結合なマイクロサービスとして開発し、共通基盤の上で管理・スケールするには、コンテナ技術が不可欠です。

Amazon EKSは、こうしたニーズに応えるため、Kubernetesクラスターの作成・運用をマネージドで提供しています。自動スケーリング、ロールベースアクセス制御、Helmによるマニフェスト管理、PrometheusとCloudWatch連携によるモニタリングなど、エンタープライズ対応の機能が豊富です。

さらに、コンテナ同士をService Meshやイベント駆動によって柔軟に接続し、変更が生じた際にもロールアウト・ロールバックが容易に行えるため、運用負荷を抑えた持続可能なAIプロジェクトの基盤として効果的です。

RAGアプリ開発のライフサイクルとベストプラクティス

RAG型生成AIアプリを本番運用レベルで展開するには、開発・デプロイ・監視・ガバナンスなど、エンドツーエンドのライフサイクル設計が重要です。以下のようなステップが推奨されます:

1. 要件定義:どのようなユーザーニーズに応えるか、精度要件や更新頻度を定める

2. データ準備:使用する企業データやFAQ、ドキュメント等をクレンジングしS3などに格納

3. インデクシング:ベクトルストアにより検索用インデックスを構築

4. プロンプト設計:様々なユースケースに対応するプロンプトテンプレートを検討

5. 実装・デプロイ:AWS CDK, Helm Chartsなどによる継続的デリバリーを整備

6. テストと評価:出力の有用性・正確性のA/Bテストを実施

7. モニタリングと改善:CloudWatch LogsやOpenTelemetryでの可視化

さらに、モデレーションやバイアス対策を含めた「責任あるAI」の視点を持つことも重要です。AWS Bedrockは、この点においてもフィルタリングやアクセスコントロール機能を備えており、ビジネス現場に寄り添ったAI開発が可能です。

RAGを活用できる主なユースケース

RAGアーキテクチャの強みを生かした具体的なユースケースは幅広く存在します:

– 企業内ナレッジ検索:社内ドキュメントを検索し、従業員の問い合わせに自然言語で回答

– コールセンター支援:オペレーターがリアルタイムで最適な回答を得る支援

– ECサイトの商品QA:商品説明ページの情報に基づいて自動応答

– 法務・金融領域での規制対応支援:法令や契約書に関する検索・要約

– 教育分野での学習支援:教科書情報から回答を導くチューター型AIアシスタント

これらのユースケースでは、単なる生成AIでは対応しきれない「信頼性」や「最新性」といった点が問われるため、RAGの導入が分かれ道となります。

まとめ:スケーラブルなAIシステムをより簡単に、安全に

RAGアーキテクチャは、生成AIの性能を飛躍的に向上させるパラダイムの一つです。しかし、その実装・運用には多様なコンポーネントの統合が求められます。AWSは、Amazon BedrockとAmazon EKS、さらにその他エンタープライズ向けサポート機能を提供することで、この困難を解消し、誰もがより高度で安全な生成系AIアプリを構築できる基盤を提供しています。

本記事で紹介した構成や手法は、企業のAI活用を推進する上での強力な参考モデルとなるはずです。今後のプロジェクトにおいて是非、AWSのRAGベース構成の導入を検討してみてはいかがでしょうか。