近年、人工知能(AI)技術はめざましい進化を遂げ、その応用範囲は急速に広がっています。中でも、画像と言葉の両方を理解し、統合的に処理できるVision Language Models(視覚言語モデル:VLMs)は、AIの新たなステージを切り開く存在として注目を集めています。この記事では、Hugging Faceが公開した記事「Vision Language Models Explained」に基づき、視覚と言語を融合するモデルがなぜ重要なのか、どのように機能するのか、そして今後どのような可能性を秘めているのかをわかりやすく解説していきます。

1. 視覚と言語が交差する世界

人間は、日常的に周囲の視覚的な情報と、それに関連する言語の情報を統合して理解しています。例えば「赤い車が走っている」という一文は、色や形、動作など複雑な視覚情報と、それを表す言葉の抽象的な関係性で成り立っています。このようなマルチモーダル(多様式)な情報処理をAIに担わせようというのが、Vision Language Models(以下VLMs)の狙いです。

これまで、文章を処理する言語モデル(例:BERT, GPT)や画像を解析する視覚モデル(例:ResNet, ViT)は別々に発展してきました。しかし、実世界のタスクには視覚と言語の融合が不可欠な場面が多くあります。例えば、画像に対して自然言語で説明するキャプション生成、画像に対する質問応答(Visual Question Answering)、画像をもとに自然に会話するChatbotなど、さまざまな応用が考えられます。

2. VLMsの仕組み:どうやって「見る」と「話す」を統合するのか?

VLMsは、画像とテキストという2つの異なる形式のデータを処理するため、まずそれぞれの情報を特徴ベクトルと呼ばれる数値表現に変換します。画像には画像エンコーダ(例えばCLIPのVision Transformer(ViT)ベースの構造)、テキストにはテキストエンコーダが使用されます。

それぞれのエンコーダから得られた特徴は、共通の空間にマッピングされ、モデルは画像とテキストの意味的な対応を学習します。これにより、「犬がボールで遊んでいる」というテキスト表現と、その文に合致する画像表現とがリンクされるのです。

3. VLMの代表例とその進化

Hugging Faceが紹介している記事では、現在のVLM技術の主な系統として3つの代表的アプローチが挙げられています。

① CLIP系モデル(Contrastive Learning)

OpenAIが開発したCLIP(Contrastive Language-Image Pretraining)は、膨大な画像とテキストの組み合わせから、画像と文が一致するように特徴を学習するモデルです。CLIPでは、テキストと画像のペアを「意味的に合っているかどうか」で分類するタスクを通じて学習が行われます。画像と文が一致するペアの距離が縮まり、不一致のペアとは遠ざかるよう特徴空間が形成されます。

② エンコーダ-デコーダ型モデル

画像を視覚エンコーダで処理した後、その情報をもとにテキストを生成するアーキテクチャです。画像説明文の生成(Image Captioning)や、視覚に基づく質問応答(VQA)などが主な応用例です。最近では、BLIP2のように、画像特徴を言語入力に変換可能なプレトレーニングが行われたモデルも登場しており、テキスト主体の大規模言語モデル(LLM)へのアドオンのような形で動作します。

③ マルチモーダルトランスフォーマー(Fusion-based)

画像とテキストの両方を統一したTransformer構造で同時に処理するモデルです。最初から視覚と言語を融合的に扱う設計となっており、相互の情報を参照しながら学習するため、画像の文脈をさらに正確に扱うことが可能です。

4. Hugging Faceが提供するツールとエコシステム

VLM技術を研究・開発する上で、Hugging Faceは重要な役割を果たしています。彼らは、Transformersライブラリを通じて、画像と言語の統合モデルを簡単に利用できる環境を提供しています。中でも、「transformers」ライブラリver4.26以降では、VisionEncoderDecoderModelなどのクラスを用いて、画像キャプショニングモデルなどを数行のコードで構築することが可能です。

また、Hugging Face Hubには、BLIP、CLIP、Flamingoなど、さまざまなVLMモデルの事前学習済みモデルが公開されており、具体的なユースケースに応じたモデルを自由に探索し、活用することができます。

5. VLMの社会的意義と課題

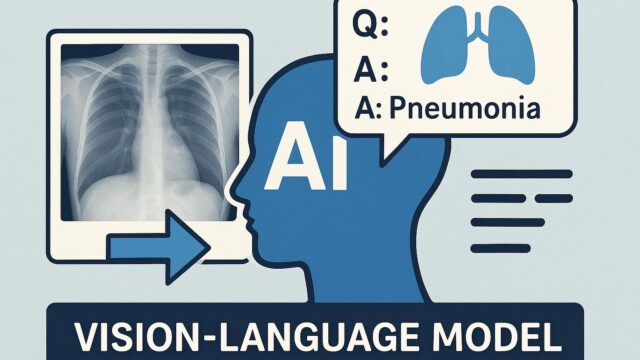

VLMは、画像と言葉の両方を同時に理解しながらタスクを遂行できるため、視覚障がいのある方への支援、教育用途、医療分野での画像解析など、社会的に重要な貢献が期待されています。

一方で、新しい課題も指摘されています。例えば、画像と文の対応関係が曖昧だったり、訓練データにバイアス(偏り)がある場合、モデルが誤解を起こす可能性もあります。また、不適切な生成(誤った説明、不正確な回答)を防ぐ仕組みも今後さらに求められるでしょう。

6. 今後の展望:AIの「見る力」と「話す力」の融合がもたらす未来

VLMの可能性は非常に広範囲です。今後、VLMが進化することで、より洗練されたマルチモーダルアシスタントの誕生、実用的なロボットへの搭載、医療や教育といった専門分野での支援など、様々な応用が現実味を帯びてくるでしょう。

さらに、近年注目されている「マルチモーダルLLM」(例えば、OpenAIのGPT-4がマルチモーダル対応であることが知られています)との連携も鍵を握る要素です。テキストだけでなく、画像、音声、動画といった多様な情報を一元的に処理できるAIシステムが登場することで、人間のように自然で多感覚的な対話が可能になることが期待されます。

まとめ

Vision Language Modelsは、「見る」と「話す」を統合するという、AIにとって革命的な進化を体現しています。膨大な画像とテキストの情報を活用し、両者の意味的な接点を見つけ出すことにより、より高度で自然な情報理解が可能になりつつあります。

これまでテキストや画像の解析はそれぞれ別個に扱われていましたが、VLMの登場により、これらが一体化し、より人間的な「知的理解」へと近づいています。今後、研究と実装がさらに進んでいくことで、私たちの日常や専門的な活動の中に、より自然に、そして有益にVLMが溶け込んでいく未来が訪れることでしょう。

技術の発展を正しく理解し、社会に有意義な形で活用することが、私たちユーザーや開発者、そして企業のこれからの大きな使命になっていくのではないでしょうか。