近年、生成AIと大規模言語モデル(LLM)の革新が加速している中で、マルチモーダルモデルの活用が注目を集めています。これらのモデルは、テキストだけでなく、画像や音声など複数の情報源を統合して処理することが可能であり、非常に多様な応用が期待されています。特にMeta社の「Llama 3.2」のような大規模で性能の高いAIモデルを、各業界のニーズに合わせてチューニングする動きが進んでいます。

本記事では、Amazon Bedrockを活用してMeta Llama 3.2のマルチモーダル・ファインチューニング(微調整)を行う際のベストプラクティスについてご紹介します。これにより、開発者や研究者がより効率的かつ安全にAIを活用するための道筋を理解することができます。

Amazon Bedrockとは

Amazon Bedrockは、Amazon Web Services(AWS)が提供するマネージドサービスで、様々な基盤モデル(foundation models)をAPI経由で簡単に利用することを可能にします。コーディングレスでモデルを呼び出したり、カスタムチューニングを行うことができ、企業や開発者にとってAI導入のハードルを下げてくれます。

中でも、Anthropic、AI21 Labs、Stability AI、Metaなど複数の企業が提供するモデルを統合的に利用できるのが最大の特長です。従来であれば大規模な計算資源やMLエキスパートが必要だったタスクも、Bedrockならアプリケーションに統合されたインターフェースを通じてシームレスに行うことが可能です。

Llama 3.2とは

Metaが2024年に発表したLlama 3.2は、テキストとビジュアルデータの両方を処理できるマルチモーダル大規模言語モデルです。前モデルであるLlama 2が自然言語処理に特化していたのに対し、Llama 3.2では画像解析能力が加わることで、チャットボットやデータ要約、画像認識、ドキュメント解析などの用途にさらに幅広い対応が可能となっています。

このような強力な性能を持つLlama 3.2を各組織のニーズに合わせてファインチューニングすることで、例えば業界特化型のチャットアシスタントや、専門性の高い画像診断ツールなど、より高度なAIソリューションが実現可能となります。

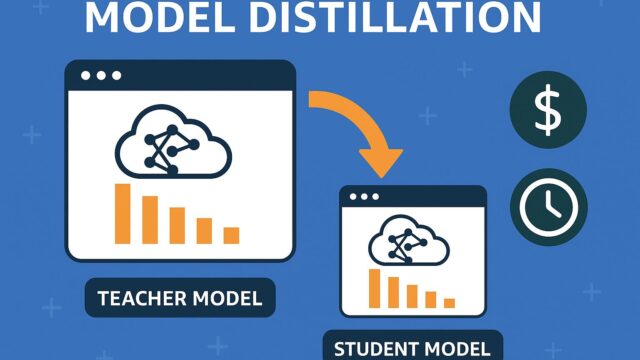

マルチモーダルファインチューニングとは

ファインチューニングとは、既存の大規模言語モデルを特定の用途やデータドメインに適合させるプロセスです。マルチモーダルモデルにおいては、テキストと画像のペアを使って、モデルがそれらの関連性を正しく理解し、推論できるように学習させます。

一例として、製造業におけるトラブルシューティングマニュアルや、医療における画像付き診察記録などが含まれるデータセットを使ってファインチューニングを行うことで、Llama 3.2が実際のオペレーションに近い形で機能するようになります。

Amazon Bedrockを用いたファインチューニングのベストプラクティス

ここからは、実際にAmazon Bedrockを使ってLlama 3.2のマルチモーダル・ファインチューニングを行う際に有効なベストプラクティスをご紹介します。

1. 適切なデータの準備とラベリング

まず第一に重要なのは、モデルに与えるデータの質と整理方法です。マルチモーダルモデルは、テキストと画像の間に意味的な関連性があることを前提として学習します。つまり、入力として使うテキストと画像には明確で一貫したペアリング関係が必要です。

例えば、製品マニュアルの項目に装置の写真が添付されているといったように、テキストが画像の内容を説明しているペアが理想です。画像とキャプションを混在させてモデルに渡すのではなく、一つ一つの入力が論理的に結びついている必要があります。

2. データの多様性と包括性

モデルの汎用性と公平性を高めるために、性別、人種、言語、文化的背景といった多様性に配慮したデータセットを組むことが推奨されます。これにより、モデルが特定の属性に偏らずに推論を行える可能性が高まり、より一般的な利用に耐えうるものとなります。

また、データの収集元に信頼性があり、使用許諾の範囲内でファインチューニングを行うことも、倫理的・法的観点から極めて重要です。

3. セキュリティとプライバシーの配慮

マルチモーダルデータにはしばしば個人情報が含まれる可能性があります。画像による個人の特定や、テキスト中の氏名、住所、医療情報などがその例です。Amazon Bedrockでは、こうしたセンシティブな情報に対しても暗号化やアクセス制御を設定できるため、必ず適切なセキュリティポリシーを設計しておきましょう。

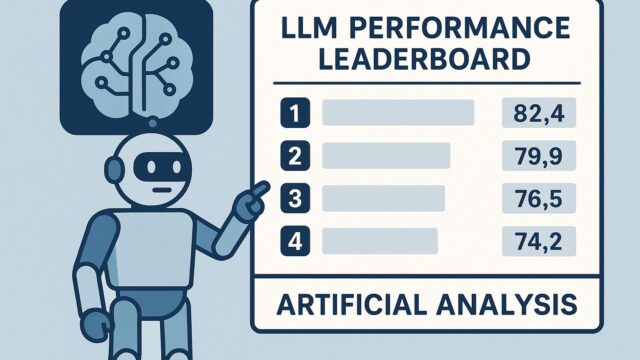

4. 評価手法とベンチマーク

ファインチューニングされたモデルの性能を評価するには、あらかじめ定めたベンチマーク指標や評価データセットが必要です。マルチモーダルモデルの場合、単純なテキスト出力のみで評価するのではなく、「どれだけ正確に画像の内容を理解しているか」や「タスクに対する応答の一貫性」といった複数の観点から品質を分析する必要があります。

AWSでは、こうした評価フェーズを自動化するためのツールやスクリプトも提供されているため、それらを活用することで開発効率と客観性を高めることができます。

5. 持続的なパフォーマンス監視とフィードバック

ファインチューニング後のモデルは、運用に入った後も状況の変化に合わせて再調整やアップデートを行う必要があります。Bedrockは、モデルの応答ログを収集・分析する機能を提供しており、これをもとに品質低下の兆候を早期に検知することが可能です。

また、ユーザーから得たフィードバックをトレーニングデータに取り込み、定期的にモデルを再学習させることで、価値のあるユーザーエクスペリエンスを維持できます。

6. 高性能GPUインフラの活用

マルチモーダルモデルの学習には高い計算資源が求められます。Amazon Bedrockでは、このような負荷の高い処理もマネージドで提供されており、NVIDIA H100やA100といった高性能GPUのパワーを活かすことができます。

さらに、スケーラビリティを重視したい場合には、BedrockとAmazon SageMakerを組み合わせて、トレーニング環境をより柔軟に設計することも可能です。

応用分野の広がり

Llama 3.2とAmazon Bedrockを組み合わせたマルチモーダルAIの活用には、実に多様な応用分野が考えられます。たとえば:

・医療業界における画像診断補助

・法律分野での裁判資料の要約と視覚的分類

・製造業での部品の自動識別と修理手順の提示

・教育分野における図解付き教材生成

・金融業界での視覚的報告書の解析

これらは一例にすぎませんが、現場で実際に使われるAIとしての必然性が高く、今後もこうした応用が加速していくと予想されます。

まとめ

Amazon BedrockとMetaのLlama 3.2を使ったマルチモーダルファインチューニングは、現代のAI戦略を加速させる強力な手法です。十分に整備したデータと倫理的配慮、そして高品質な技術基盤があれば、業界を問わず、革新的なAIソリューションを現実のものとすることが可能です。

今後もAIの民主化と実用化が進むにつれ、こうしたツールやプラクティスは、ますます多くのユーザーにとって身近で重要なものとなっていくでしょう。AIを適切に活用するためには、技術だけでなくそれを取り巻く環境への理解も深めていくことが求められています。

マルチモーダル生成AIの未来はすでに始まっており、その可能性は私たちの手の中にあります。