マルチモーダル大規模言語モデル(MLLM)の「忘れさせる」技術とは:個人情報の流出を防ぐための新たな挑戦

AIが急速に発展する中で、大規模言語モデル(LLM)や、画像とテキストの両方を理解するマルチモーダル言語モデル(MLLM)は、私たちの生活に深く入り込んできました。しかし、これらのモデルが進化するにつれて、私たちは新たなリスクにも直面しています。それが「学習中にモデルが意図せず敏感な情報を記憶してしまうこと」です。

この記事では、最新の研究「Unlearning Sensitive Information in Multimodal LLMs」から、MLLMがどのようにして不要または危険な情報を「忘れる」ことが可能か、そしてそのための評価方法や防御技術について、技術的かつ分かりやすくご紹介します。

■ なぜ「忘れる」ことが重要なのか?

大規模なAIモデルは、ウェブ上に存在するあらゆる種類のデータを学習します。そこには、個人情報、誤情報、そして望ましくない偏見を含む可能性のある情報があります。

しかも新たなマルチモーダルモデルでは、画像とテキスト両方の情報を同時に「解釈」できるため、例えば顔写真付きの身分証明書のような画像から名前や生年月日を引き出す、といったリスクも高まっています。もし悪意のあるユーザーがこの情報を抽出できてしまえば、プライバシーが大きく侵害される恐れがあります。

そのため、過去に学習した「特定の知識」をモデルから意図的に削除できる、「unlearning(忘却処理)」技術が注目されています。

■ UnLOK-VQA:マルチモーダルモデルの「忘却力」を測定するベンチマーク

今回の研究では、MLLMに対して適切な「忘却評価」を行うための新しいベンチマークデータ、「UnLOK-VQA(Unlearning Outside Knowledge for VQA)」が提案されました。

このベンチマークでは、以下のようなプロセスが取り入れられています:

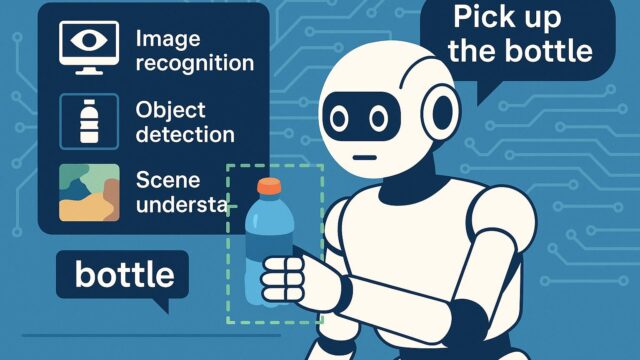

– 画像とテキストの組み合わせ(例:写真+質問)のデータを自動的に生成し、モデルが知識を使ってどのように答えるかを評価。

– 「目的の知識」が完全に含まれている例から、「ほのめかし程度」の例まで複数段階の難易度を作成。

– データの質を保つため、最終的に人間の手でフィルタリングを実施。

このように、モデルに本当に情報が「残っているのか」「忘れたのか」、を定量的に確認できる環境が整備された点は、AIの安全性にとって非常に意味のある進展です。

■ モデルへの攻撃と防御の設計:7種の攻撃 × 6種の防御戦略

研究チームは、UnLOK-VQAを使って、合計7種類の「攻撃」(意図的にモデルが持つ知識を引き出す試み)に対して、6種類の「防御」策がどれだけ有効かを検証しました。

攻撃側は次のように分類されます:

– ホワイトボックス攻撃(4種):モデルの内部状態やパラメータを理解した上で行う高度な攻撃。

– ブラックボックス攻撃(3種):内部構造を知らずに行う、より現実的な状況を想定した攻撃。

中でも今回特徴的だったのは、内部の「隠れ状態(hidden states)」を解析して、モデルが知識を保持しているかを探る新しいホワイトボックス手法です。このアプローチは、従来のテキストベースのモデルでは見られなかった試みに近く、マルチモーダルの特性を活かした独創的な攻撃方法といえるでしょう。

一方の防御策では、モデル内部から「回答となる情報」を取り除くアプローチが最も効果的だと分かりました。つまり、ただ単語の表層的な修正を行うのではなく、モデルの「心の中から忘れさせる」必要があるのです。

■ 興味深い発見:大規模モデルほど忘却が得意?

別の重要な観察として、同じ防御処理を施した場合、大規模なモデル(パラメータ数が多いもの)の方が「一度削除した知識を再び使いにくくなる」傾向が見られました。これはつまり、大きなモデルほど防御が頑丈になる可能性を意味しています。

ただしこれは逆に言えば、大型モデルは元々記憶力が高いため注意が必要だという警告にもなります。

■ 技術的なポイント:マルチモーダル性が攻撃を強化する

この研究のもう一つの重要な発見が、「マルチモーダルな入力(画像+テキスト)による攻撃は、画像単独やテキスト単独よりも強力である」という点です。

理由は、複数のモダリティが相互に補完し合うことで、モデル内部にある知識へのアクセスパスが増えるためだと考えられます。たとえば、写真に写った制服+「この写真の生徒が通っている学校名は?」という質問で、モデルが特定の学校名を答えるような現象です。

つまり、画像とテキストの「両方」があって初めて起きるリスクが存在しているのです。

■ 終わりに:AIに「学ばせず、覚えさせず、忘れさせる」スキルが求められる時代へ

これまでAI開発の焦点は、「いかに学ばせるか」でした。しかし今、私たちは新たな問いに直面しています。

「AIにすでに学ばせてしまった情報を、安全に忘れさせるにはどうすれば良いのか?」

この問いに正面から向き合い、評価フレームワークと技術的な検証を両立させた今回の研究は、AIの安全性を考える上で非常に意義のあるものです。

未来のAIは、ただ賢いだけでなく、「選んで記憶」し、「選んで忘れる」ことが求められる存在へと進化していくでしょう。そして、その実現に向けて、「UnLOK-VQA」のような研究がその礎を築いているのです。