現代の生成AI(Generative AI)技術は、私たちの日常生活にさまざまな形で影響を与えています。特に、自然言語処理の分野では大規模言語モデル(LLM: Large Language Model)が著しい進化を遂げており、タスク指向のエージェント開発においてもその恩恵を受けています。Amazonが提供する「Amazon Bedrock」は、開発者がさまざまな基盤モデルを選択し、それらを統合することで、強力かつ柔軟なAIアプリケーションを構築するためのプラットフォームです。

今回ご紹介するのは、Amazon Bedrockで開発したエージェントの性能を、信頼性が高く実用的な手法で評価するための取り組みです。具体的には、オープンソースの評価フレームワーク「RAGAs(Retrieval-Augmented Generation Assessment)」と、LLM自体を判定者(ジャッジ)として活用する「LLM-as-a-judge」というアプローチを組み合わせた評価方法がテーマとなっています。本記事では、それらの手法の概要と、その組み合わせがどのようなメリットをもたらすのかについて解説いたします。

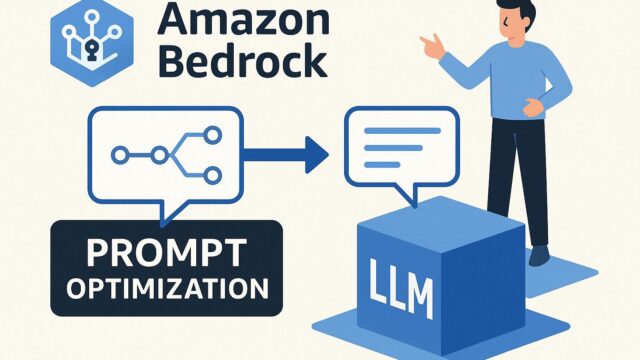

Amazon Bedrockとは?

Amazon Bedrockは、開発者がさまざまな生成AIモデルを使ってアプリケーションを簡単に構築・統合できるように設計されたマネージドサービスです。Anthropic、AI21 Labs、Meta、Cohere、Stability AI、さらにはAmazon自身が開発したTitanモデルなど、さまざまな高性能な基盤モデル(Foundation Models: FMs)を選択できるのが特徴です。開発者はこれらのモデルをプログラミングや機械学習の専門知識がなくてもAPIベースで利用可能であり、迅速かつ柔軟にAIソリューションを立ち上げることができます。

Bedrockエージェントは、これらの基盤モデルを活用してユーザの自然言語リクエストを処理し、関連する外部ツールやカスタムデータソースと連携しつつ、タスクの自動化や問題解決を行います。例えば、FAQに自動応答するチャットボットや、社内システムから必要な情報を引き出してレポートする業務支援ツールなどが挙げられます。

しかし、タスクが高度化するにつれて、エージェントがどれくらい正確かつ有用な応答を生成しているかを定量的に把握することが、ますます重要になっています。

エージェント評価の課題

たとえ強力なLLMを使用していても、エージェントが必ずしも常に正確で有益なアウトプットを生成できるとは限りません。特に、複数のステップを踏む推論や、多数の外部情報へのアクセスが必要となるような複雑なタスクでは、モデルのパフォーマンスが問題となりやすい傾向があります。

そのため、エージェントの応答品質やタスク達成能力、妥当性などを客観的に評価する必要があります。これまでの評価手法では、人手での評価、つまりヒューマンジャッジが主流でしたが、これは時間とコストがかかる上、再現性に乏しいという課題があります。そこで注目されているのが、半自動的かつ再現性の高いLLMベースの評価手法です。

RAGAs: Retrieval-Augmented Generationの評価指標

「RAGAs(RAG Assessment)」は、情報検索(Retrieval)と自然言語生成(Generation)の組み合わせである「RAG(Retrieval-Augmented Generation)」モデルに特化した評価フレームワークです。オープンソースとして提供されており、エンドツーエンドのRAGアプリケーションパイプラインの評価や健全性の可視化を目的としています。

RAGAsでは、主に以下のような指標を使って、検索精度と生成内容の有用性を分析します。

– アンサーワースネス(Answer Worthiness):クエリに対して有意義な回答が生成されているかどうか

– カレントネス(Correctness):出力の正確性

– コンシステンシー(Consistency):生成内容が検索された情報と一貫しているか

– アグリゲーション(Faithfulness):応答に含まれる情報が元の文書ソースに忠実であるか

こうしたスコアは、モデルやデータの特性を客観的に比較・分析するために役立ちます。

LLM-as-a-judgeの活用

「LLM-as-a-judge」は、文字通りLLMを判定者として活用する評価アプローチです。これは、人間の代わりにLLMが一連の応答や推論過程を評価することで、大規模なタスクに対する一貫性と自動化を提供します。LLMは、与えられた入力文と出力文に対して複数の観点からスコアリングやフィードバックを行うことで、評価のプロセスを人間よりも迅速かつ詳細にこなすことが可能です。

ただし、LLM-as-a-judge手法を実用化するには、評価設計を行い、過度に主観的なスコアにならないよう配慮する必要があります。そのため、評価プロンプトのチューニングや過去の人間評価結果との整合性の検証が必要不可欠です。

RAGAs + LLM-as-a-judgeの組み合わせによる恩恵

今回紹介されたアプローチでは、RAGAsによる構造化された評価指標に基づいてLLMを評価者として用いることで、Bedrockエージェントのパフォーマンスを総合的かつスケーラブルに評価できます。これにより、以下のようなメリットが得られます:

1. 評価の自動化とコスト削減:

これまで手動評価に頼っていた部分をLLMが担うことで、大量のケースに対して効率的な評価が可能になります。

2. 一貫性と再現性:

同じ評価設定を再利用することで、一貫した基準でタスクを比較できるようになります。これはエージェント性能の進化を長期的に監視する上で非常に有用です。

3. 開発サイクルの促進:

エージェントのパフォーマンス改善やモデル選択の際に、クイックフィードバックを受け取ることで、より高速な開発・改善が可能になります。

使用方法と検討事項

記事中では、Amazon Bedrockで開発されたエージェントを対象に、RAGAsによるベンチマーク評価の手順と、LLM(例えばClaudeなど)を評価者として使用するプロセスが紹介されています。

開発者は、以下のようなフローで評価プロセスを実行します:

– ベンチマーククエリと期待される成果物(意図的にデザインされた「テストシナリオ」)を用意する。

– Bedrock上のエージェントにクエリを投げ、生成された応答を収集する。

– RAGAsフレームワークを用いて、各応答に対するスコアを計算する。

– LLMが各出力を精査し、スコアや構造化されたフィードバックを提供する。

このようにして、複数の観点からエージェント性能を可視化・評価できるようになります。

ただし注意点として、LLMが定めるスコア評価は必ずしも100%正確とは限らないため、人間によるダブルチェックや基準となるベンチマークとの整合性は最低限確保すべきです。また、評価するLLMの選定(例えば、Claude、Titan、Jurassicなど)も、結果に影響を与える可能性があります。

今後の展望とまとめ

評価スキームの高度化は、生成AIアプリケーションの品質と信頼性を担保するうえで、今後ますます重要になるでしょう。今回のAmazonの取り組みでは、RAGAsフレームワークとLLM-as-a-judgeの融合によって、従来困難だったエージェント評価をより効率的かつ標準化された方法で実現可能にしました。

Bedrockを利用している開発者は、こうした評価機構を取り入れることで、煩雑な性能検証タスクの自動化が図れ、迅速かつ持続的な品質向上や改善が可能になります。また、このアプローチはAmazonのBedrockに限らず、他のRAGベースシステムやチャットボット開発にも応用の利く普遍的な方法である点も注目すべきです。

AI時代の開発は、「作ること」と同じくらい「評価すること」が重要な時代に突入しています。評価が的確でなければ、どんなに高精度のモデルでも実運用では信頼されません。今後も、生成AIの性能を効果的に評価するためのツールやフレームワークは進化を続けるでしょう。開発者はそれらを柔軟に取り入れ、模索と改善を繰り返すことによって、より良いAI体験をユーザーに提供できるようになるはずです。