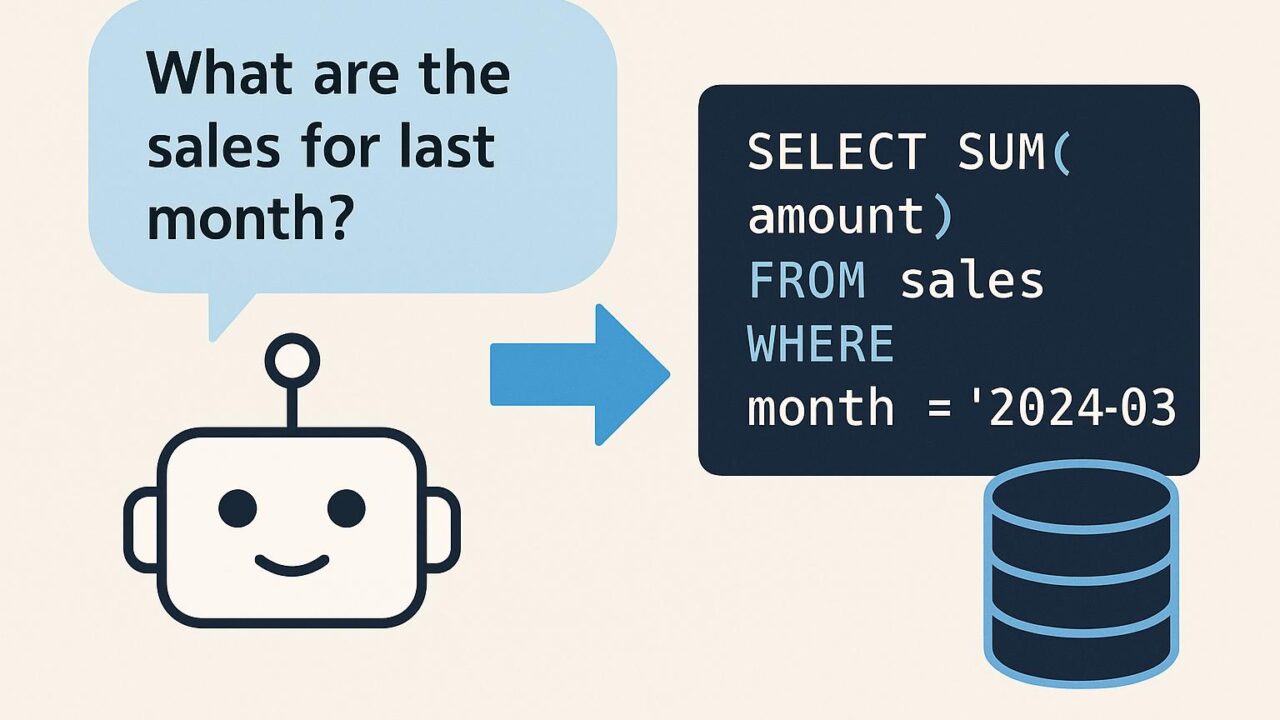

近年、ChatGPTやClaudeなどの大規模言語モデル(LLMs:Large Language Models)の進化により、自然言語処理は大きな革新を遂げています。その応用範囲は広がり続け、ビジネスの現場でも実用的なソリューションとして多くの注目を集めています。中でも特に関心を集めているのが、自然言語での問いかけをSQL文に変換する「自然言語からSQLへの生成(Natural Language to SQL, NL2SQL)」という技術です。

従来、業務データにアクセスし、意味のあるインサイトを得るためには、データベース構造やSQLクエリに関する深い専門知識が必要でした。しかし、NL2SQL技術により、誰もが「この商品の売上は先月と比べてどう変わった?」といった自然な言葉で問いかけるだけで、データベースから正確な回答を得られる未来が現実になろうとしています。

今回は、Amazon Web Services(AWS)による技術ブログ「Enterprise-grade natural language to SQL generation using LLMs: Balancing accuracy, latency, and scale」の解説を基に、企業環境でNL2SQLを実現するための設計思想と技術戦略についてご紹介します。この記事では、LLMsを利用した自然言語からのSQL生成を、「精度(Accuracy)」「レイテンシ(Latency)」「スケーラビリティ(Scalability)」の3つの観点からどうバランス良く構築するかが詳しく論じられています。

企業向けNL2SQLの可能性と課題

多くの企業では、データドリブンな意思決定が求められています。営業、マーケティング、財務、製造など、あらゆる部門が大量の業務データを蓄積し、有効活用するためにBI(ビジネスインテリジェンス)ツールやダッシュボードを導入しています。しかし、BIツールの多くはSQLに基づいて構築されており、ユーザーが自分でクエリを記述する必要がある場合も少なくありません。

この壁を取り払う技術として、NL2SQLに注目が集まっています。ユーザーがデータベースのスキーマ構造や結合条件を知らずとも、自然言語でのリクエストに基づいて適切なSQLが生成され、バックエンドのデータウェアハウスから情報を取得できます。

ただしこの実現にはいくつかの大きな課題があります。

– 発話の曖昧さや構文の多様性に対応する必要がある

– データベースの構造やドメイン知識の理解を要する

– クエリの実行速度(レイテンシ)を抑える必要がある

– 複数ユーザー・大量クエリに対応できるスケーラブルな構成が求められる

AWSによるエンタープライズ向けNL2SQL設計の概要

AWSは、LMMs(大規模言語モデル)とAmazon Web Servicesのサービス群を活用し、このような課題に対応する高度なNL2SQLプラットフォームの構築フレームワークを提案しています。具体的には、以下のようなコンポーネントで構成されています。

1. クエリ理解と前処理

ユーザーからの自然言語クエリを最初に受け取り、意図の把握(インテント認識)を行います。ここでは、Amazon BedrockやOpenAI APIなど複数のLLMが活用され、その文脈認識能力によってより正確な意図が特定されます。

さらに、企業固有の用語やドメイン知識も考慮するため、カスタム辞書や類義語辞書を設定し、曖昧な表現への対応も進められます。

2. スキーマコンテキストの拡張提供

SQL生成において最も重要なのは、文脈に応じた正確なスキーマ情報の提供です。一般的なプロンプトでは、単にテーブル名やカラム名などの構造情報を渡すだけですが、AWSのアプローチでは追加的に以下のような情報を組み込みます:

– テーブル間のリレーション

– 各カラムの説明(メタデータ)

– チームや部門による使用頻度などのヒント

このような文脈をLLMに供給することで、よりセマンティックに適したSQLが生成されやすくなります。

3. SQL生成プロセス

生成エンジンには、以下のような2つのアプローチが活用されます。

– プロンプトベースのSQL生成:LLM単体に文脈情報を提示し、直接的なプロンプティングによってクエリを生成します。

– チェーンオブソート(Chain-of-Thought)の活用:クエリ解釈→構成→検証のフレームをステップごとに管理し、LLMが思考を分割しながらより論理性の高いSQLを生成する方法です。

また、生成されたSQLに対しては構文チェックやセキュリティフィルターを通し、誤ったデータ取得や意図しない情報漏洩を防止します。

4. 高速性とスケーラビリティの実現

LLMsをリアルタイムで呼び出す場合、とかく“遅い”という問題が発生しがちです。AWSではレイテンシ低減のため、以下のような施策が取られています:

– プロンプトキャッシング:同一のクエリに対しては生成済みのSQLを再利用する

– マルチエンジン選択:複数のLLMベンダーを組み合わせて、コストと速度の最適化を図る

– コンテキスト圧縮:LLMへの入力長を削減する前処理機構

また、ユーザー数の増加に対応するスケーラビリティにも大きな工夫があります。LLMエンジンの横並行呼び出しによるスループットの向上や、AWS Lambdaなどサーバレスアーキテクチャによる自動スケーリングが取り入れられています。

5. 継続的学習とチューニング

LLMsの応答は、トレーニングデータとプロンプトに依存します。初期段階では正確性に限界もありますが、AWSの提供するサービス群では、ユーザーの入力と生成結果をログとして記録し、継続的なチューニングとパーソナライズが可能です。

– 評価結果のフィードバックループによる精度改善

– ドメイン固有モデルの活用(例:Amazon SageMakerによるファインチューニング)

– ユーザ毎にフィルタリングされたテンプレート活用

エンタープライズ導入における利点と今後の展望

このようにして構築されたNL2SQLソリューションは、以下のような企業導入の利点を持ちます。

– ノンテクニカルな社員でも分析できるデータ民主化の推進

– アドホックなレポート作成の迅速化と人的コストの削減

– セキュリティルールに基づくクエリ自動制御によるガバナンスの向上

– 部門横断的な意思決定の加速

さらに将来的な展望として、NL2SQLではなく「NL2BI(自然言語からBI)」「NL2Action(自然言語から実行)」へと展開が期待されています。つまり、SQL生成を飛び越えて、自然言語から即座にBIダッシュボードを表示したり、ワークフローを実行するといった、よりダイナミックなデータ活用が可能となるのです。

まとめ

自然言語からのSQL生成におけるAWSのアプローチは、LLMsの性能を引き出しつつも、現実的な運用に適した工夫が詰まっています。精度、速度、安定性といった要件を満たしながら、最終的にはデータ利活用を社内の誰もが行える体験へと昇華していくビジョンを掲げています。

データ活用が重要性を増す今日、NL2SQLは極めて実用性の高い技術です。AWSのような基盤技術を活用しながら、皆さんのビジネスに「言葉だけでクエリできる世界」を実現していくことは、これからの競争優位性を高めるために不可欠な一歩となるでしょう。

技術の進化により、私たちはより直感的に、そしてよりスマートにデータと付き合える時代に移行しつつあります。NL2SQLはその道を切り開く技術として、今後さらなる普及と発展が期待されます。