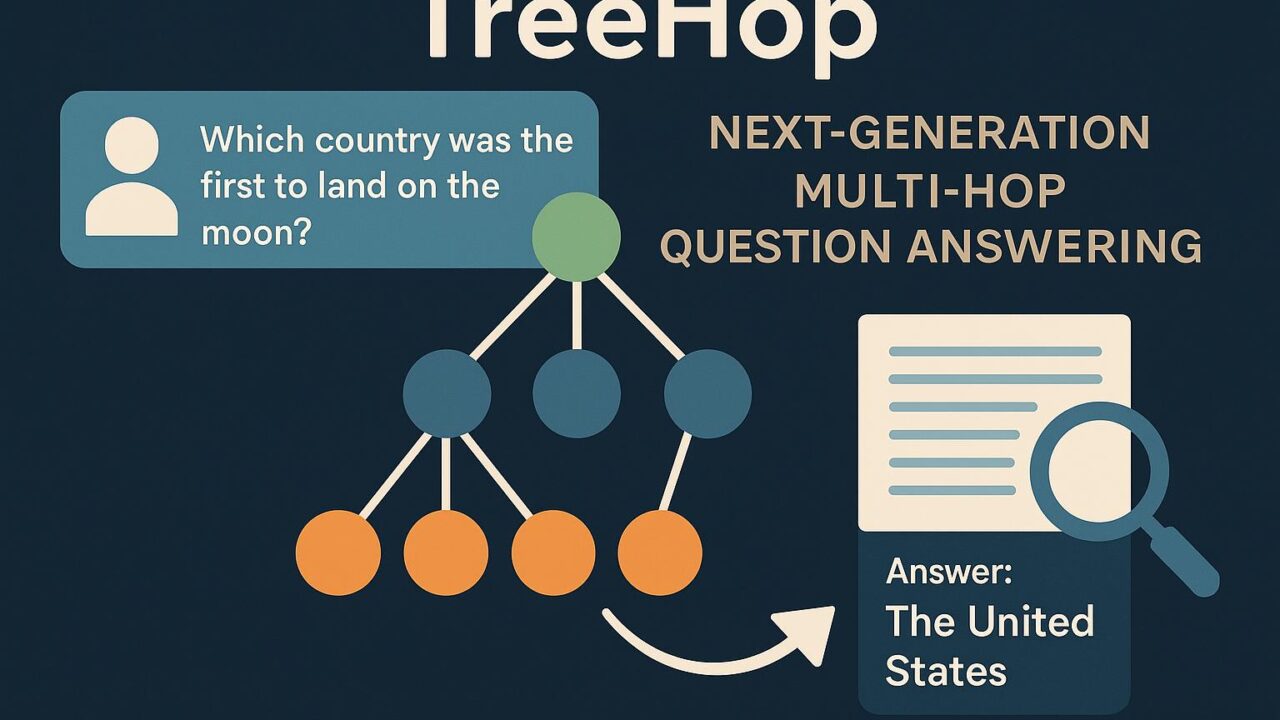

複雑な質問への素早い解答を実現する新技術 ― TreeHopが切り開くマルチホップ質問応答の次世代

近年、生成型AIと情報検索を組み合わせた「RAG(Retrieval-Augmented Generation)」技術が注目を集めています。特に、Wikipediaのような巨大な知識ベースから正確な情報を引き出すマルチホップ質問応答(Multi-Hop Question Answering, 以下MHQA)は、AI研究における重要なテーマです。しかし、これまでの手法には一つの大きな課題がありました。「推論のたびに大規模言語モデル(LLM)を何度も呼び出さなければならないため、計算コストが膨大になる」という点です。

この課題に対して、今回紹介する研究「TreeHop: Generate and Filter Next Query Embeddings Efficiently for Multi-hop Question Answering」は革新的な解決策を提示しています。TreeHopは従来のやり方を根本から見直し、LLMに頼らず、よりシンプルかつ高速にマルチホップ質問応答を実現する新しい枠組みを提案しています。

■ TreeHopとは何か?

TreeHopは、長く複雑な質問に答える過程を「埋め込み(embedding)空間」だけで処理しようというアプローチです。簡単に言うと、質問文や文章節の意味を数値ベクトルで表し、それらを元に次の情報を検索していくのです。

通常のMHQAでは、「質問 → 情報検索 → 結果をもとに質問を書き換える → 再び検索…」というステップを、LLMを数回使いながら繰り返します。この「Retrieve → Rewrite → Vectorize → Retrieve」というサイクルは高精度ですが、計算時間がかかりすぎて実用化には不向きです。

TreeHopではこの流れを、「Retrieve(検索)→ Embed(埋め込み更新)→ Retrieve」のシンプルなループに置き換えます。質問の意味情報は、前の検索で得られた文章や埋め込みと融合されて動的に更新されます。つまり「次に何を検索すべきか」を、LLMでなくベクトル操作だけで判断していくのです。

■ なぜLLMを使わなくても高性能なのか?

この設計にはいくつかの技術的な工夫があります。最重要なのは「意味の融合(semantic fusion)」です。TreeHopでは、前ステップの質問ベクトルと、取り出した文書の埋め込みを融合し、新しい質問ベクトルを生成します。これにより、検索対象が徐々に絞られ、より正確な回答に近づいていくという仕組みです。

例えば、「どの国が初めて月面着陸に成功したか?」という複雑な質問に対して、1回目の検索で「アポロ計画」や「NASA」などの関連情報が返ってきたとします。TreeHopはこれを受け取り、元の質問と意味的に統合し、「アポロ11号の月面着陸日時」や「ミッションの参加者」などより絞り込まれた検索意図を次に生成します。こうした更新が、すべて埋め込み空間内で済む点が画期的なのです。

■ 無駄な検索を防ぐ「探索終了ルール」

もう一つの技術的な強みは、過剰な検索処理をカットする「停止判定ルール」です。検索ステップのたびに新しい情報を得ても、ある段階でそれ以上の収穫が期待できない場合があります。TreeHopでは、事前に定めたルールにより、検索結果の変化が小さいと判断すれば処理を終了し、最終的な回答生成に移るようになっています。

これにより、性能を保ちながらも時間や計算資源の無駄を極限まで削減することができます。この「効率性」と「精度」のバランスは、実用的なAI応答システムでは欠かせない設計思想です。

■ 驚異的な性能:99%のスピード向上、1/20以下のパラメータ数

TreeHopの有効性は、ベンチマークによっても証明されています。代表的な3つのMHQAデータセット(HotpotQA、MuSiQue-full、IIRC)での実験結果によると、TreeHopは他の最先端RAG手法と同等の精度を維持しながら、計算待ち時間(レイテンシー)を約99%削減するという結果を出しました。さらに、使用するモデルのパラメータ数はわずか0.4%〜5%程度。これはサービス提供時のサーバー負荷やコスト削減にも直結する、大きなメリットです。

■ 今後の展望:エッジAIやモバイルでも動作する高効率設計

TreeHopのように「軽量かつ精度の高い処理」が可能な技術は、今後のAI活用において非常に重要な位置づけになります。特に、スマートフォン上での音声アシスタントや、エッジコンピューティングが求められる現場、さらには通信環境が限定される医療・災害現場にも適応が期待されます。

また、TreeHopはすでにオープンソースでGitHubに公開されており(https://github.com/allen-li1231/TreeHop)、研究や産業利用にもすぐ活用可能です。開発者が独自のタスクやデータにカスタマイズする余地も大きく、今後さらなる発展が見込まれます。

■ おわりに

TreeHopは、AIによる複雑な質問応答タスクの応答速度とコストを大幅に改善する技術であり、実用AIのさらなる普及に拍車をかける可能性を秘めています。「LLMは万能ではない」という認識のもと、効率的でスマートな設計を追求する姿勢が、これからのAI社会を支える重要な鍵になるでしょう。

大規模言語モデルに依存しない、より軽量で実用的なAI技術を追求する上で、TreeHopはその最前線に立っている一例と言えるでしょう。