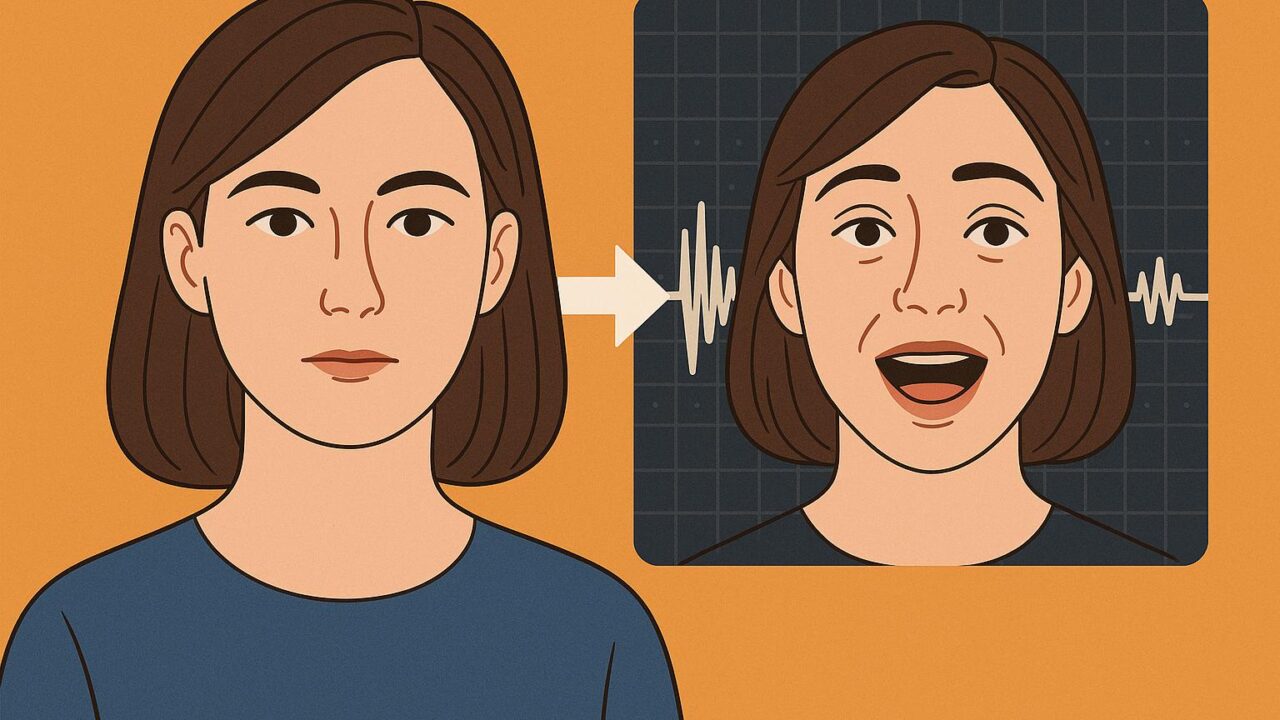

感情豊かな「しゃべる顔」を再現する新技術:DICE-Talkの革新とは?

近年、「Talking Head Generation(THG)」と呼ばれる技術分野が急速に発展しています。これは、静止画の人物がまるで話しているかのように唇を動かし、自然な表情で会話している動画を生成するAI技術です。映画の吹き替えやバーチャルキャラクター、あるいはビデオ会議アプリなど、さまざまな分野での応用が期待されています。

この分野では近年、拡散モデル(Diffusion Models)と呼ばれる画像生成技術を背景に、音声と口の動きをピッタリ合わせたリアルな映像を作ることに成功してきました。しかし、実際に感情を込めた「話す顔」を作るとなると、まだ課題が残っていました。たとえば「怒っている」や「喜んでいる」といった感情表現をうまく再現しようとすると、話している人の顔の個性(アイデンティティ)まで歪んでしまったり、感情が不自然だったりするケースがあったのです。

この問題を解決するために、新たに提案されたのが「DICE-Talk(Disentangle Identity, Cooperate Emotion-Talk)」という技術です。これは、音声から感情表現を抽出しつつ、話している人物の個性をきちんと保つことを目指した、極めて洗練された技術体系です。

DICE-Talkの革新ポイントは以下の3つです:

1. 音声と映像の感情を一緒に捉える「分離型エンコーダー」

まず、DICE-Talkでは「感情エンコーダー」と呼ばれるコンポーネントで、音声と映像から感情を読み取ります。このとき、単に感情を抽出するだけではなく、話者の個性と切り離して「感情だけ」を抽象度の高い特徴ベクトルとして表現します。これにより、感情表現を変えても顔の個性が保たれるようになるのです。

技術的には、このエンコーダーはクロスモーダル・アテンション(Cross-modal Attention)を使って、音声と映像の情報を統合します。そしてその結果を「感情に特化したガウス分布」として出力します。ガウス分布を用いることで、感情のあいまいさをうまくモデル化し、より滑らかな感情表現を可能にします。

2. 感情の相関を利用する「Emotion Bank」機構

感情は単純に一種類ずつ存在するものではなく、お互いに似ていたりグラデーションのようにつながっていることがあります。例えば「驚き」は「恐怖」や「喜び」と部分的に似ています。

DICE-Talkでは、こうした「感情間の関係性」(相関)に着目し、Emotion Bank(感情バンク)という仕組みを導入しています。これは、事前に多数の感情特徴をベクトル量子化(Vector Quantization)という技術で整理・圧縮し、今ある感情と似た感情を探しながら感情表現を強化していくものです。

さらに注目すべきは、マルチヘッド・アテンション(Multi-Head Attention)を使って感情特徴の加重平均をすること。これにより、似通った感情が連携しあって、より自然で連続的な感情表現が可能になります。

3. 自然な感情表現を目指す「ラテント空間での感情判別」

生成された表情が本当に正しい感情を表現しているかどうかを確かめるには、ラテント空間と呼ばれる中間表現の次元で感情分類を行います。これにより、ただ見た目が感情っぽいだけでなく、内部的にも「これは怒り」「これは悲しみ」と分類できるような一貫性のある表情が作れるのです。

実験結果とその有効性

この技術は、MEADやHDTFといった感情付き顔データセットを用いて検証されました。その結果、従来の手法に比べ、感情の的確さやリアルさが大幅に向上。しかも、唇の動き(リップシンク)についても既存技術と同等以上の精度を保てたという成果が得られました。

さらに、ユーザー評価においても「この顔はちゃんと喜んでいるように見えるか?」といった主観的な意見を多数収集し、DICE-Talkが提供する豊かな表情表現が好意的に受け止められたことが報告されています。

技術的な意義と今後の展望

DICE-Talkの最大の技術的貢献は、感情と個性という相反する要素を巧みに「分離し、協調」させた点にあります。感情を抽象化し、共通性を利用しながらも、個別性(ID)は保つというアプローチは、今後のマルチモーダル生成AI技術に大きな影響を与えるでしょう。

将来的には、この技術が拡張され、もっとリアルなビデオ通話、映画・ドラマの自動吹き替え、あるいは心理的フィードバックを必要とする教育や医療、メンタルヘルスに応用される可能性があります。

また、「未学習の顔(新しい人物)」でもちゃんと感情表現ができるという特性は、汎用的なキャラクター生成や、ユーザーに合わせたカスタマイズ性の高いAIアバター開発にも貢献していくでしょう。

まとめ

DICE-Talkは、話す顔に「感情の深み」を与える新しい生成技術です。音声の感情を読み取り、IDと切り離しながらも豊かな表情で自然に話す映像を作成可能にします。これにより、単なる「口パクアバター」の域を超え、人間らしい会話体験を提供する基盤技術として期待されます。今後もこの分野から目が離せません。