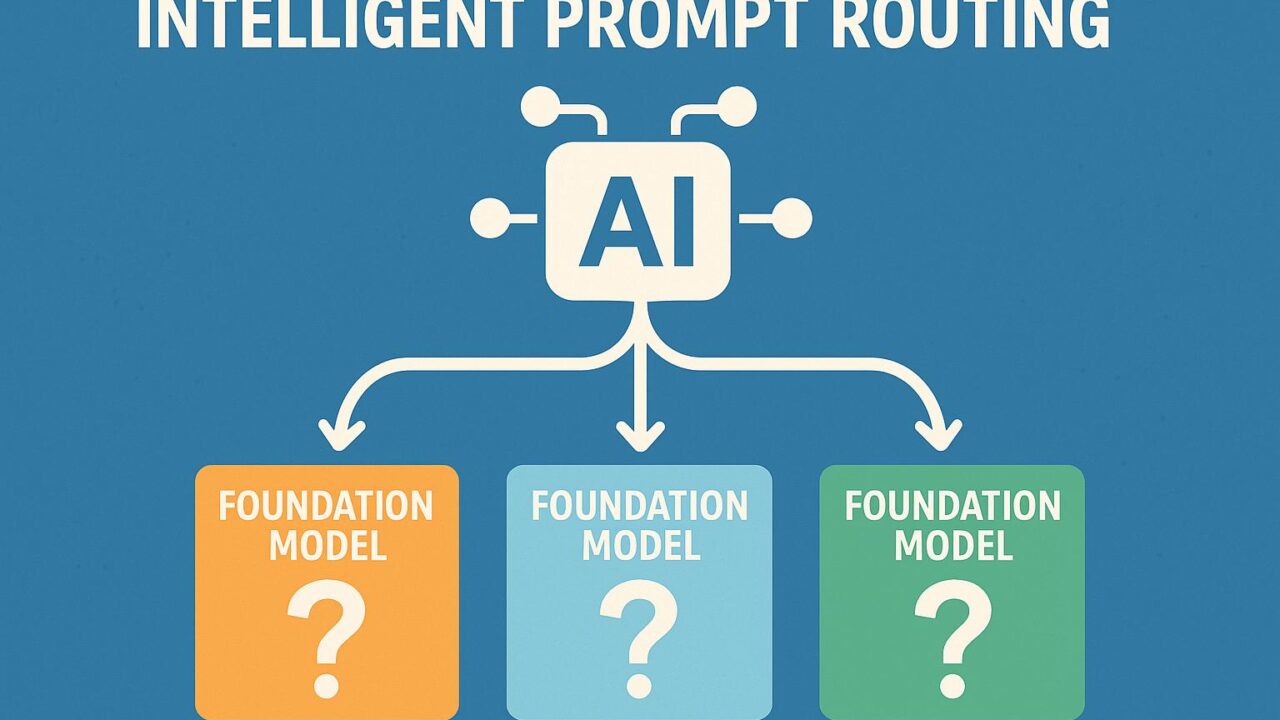

近年、生成系AIの活用がビジネスや開発の現場で急速に広まりつつあります。その中で、複数の基盤モデル(Foundation Models: FM)からニーズに最適なものを選択するという課題に直面することも多くなっています。モデルには価格、応答速度、性能、応答フォーマットの違いなど、数多くの変数があるため、ユースケースや要件に応じて最適な選択をすることは非常に難しい課題といえるでしょう。こうした課題を自動で解決する仕組みの一つが、AWSが提供するAmazon Bedrockの新機能「Intelligent Prompt Routing(インテリジェント・プロンプト・ルーティング)」です。

本記事では、Amazon Bedrockに新たに追加されたこの「Intelligent Prompt Routing」機能について、その仕組みやユースケース、導入によって得られるメリットなどを詳しく解説します。特に、コストや応答速度(レイテンシ)の最適化に寄与するという点が注目されており、多くのAWSユーザーにとって有用な情報です。

この機能の概要と目的

まず、Intelligent Prompt Routingとは一体どのような機能なのかを見ていきましょう。

この機能は、プロンプトの入力に対して、Amazon Bedrock上で利用可能な複数の基盤モデルの中から最適なモデルを動的に選択・利用するというものです。たとえば、高速で安価な応答が求められるタスクでは軽量なモデルを、高度で複雑な自然言語処理にはより高性能なモデルをといった具合に、タスクの特性に応じたルーティングを自動的に行ってくれます。この自動選択では、ユーザーがあらかじめ設定した優先基準(価格重視、速度重視、高精度重視など)にもとづき、最適だと思われるモデルが選ばれる仕組みです。

従来は開発者自身がモデルを手動で選ぶ必要があり、その都度テストやチューニングを行う必要がありました。Intelligent Prompt Routingによってこれらが省略され、AI導入の障壁が大きく下がると期待されています。

モデル選択アルゴリズムの概要

本機能の中核には、Amazon Bedrockに内蔵されている「モデルメタデータデータベース」と「推論時最適化コンポーネント」があります。これらは、プロンプトの種類や目標とする出力といった情報をもとに、適切な基盤モデルを評価・選定します。

例えば、コード生成、Eメール文作成、FAQ応答、要約といったプロンプトタイプに対して、以前の問い合わせデータやシステムログを活用しながら、応答品質、レイテンシ、コストを加味した最適なモデルが動的に判断されます。

また、この自動ルーティングは将来的にユーザーごとのカスタマイズも可能になる予定で、個別のポリシー(例:この業務ではClaudeを優先する、こちらではAnthropicのモデルは避ける、など)に従った柔軟な運用も視野に入れられています。

導入メリット|コスト削減と応答時間の改善

Intelligent Prompt Routingの大きな利点の一つは、コストの効率化です。仮に常に高性能なモデルを利用していた場合、それが必要なケースは限られているにも関わらず無駄に高額な費用が発生してしまいます。ルーティングにより、軽量モデルで十分な処理には安価なモデルを、自動的に使い分けることができるため、全体コストを効率良く削減することが可能です。

また、応答時間(レイテンシ)についても同様です。業務やサービスで即時応答が要求される場面では、軽量で高速なモデルが選ばれ、ユーザー体験が改善されます。このように、ユースケースに応じた動的な最適化は、実運用において非常に大きな価値を持ちます。

さらに、今後の利用データが蓄積されれば、ルーティング精度の向上も期待できます。経験を積むほどに、より賢く、より効率的なプロンプトルーティング環境が実現されることになるでしょう。

ユースケース:どのようなシナリオで利用されるのか

Intelligent Prompt Routingの活用が見込まれる典型的なシナリオとして、次のようなケースがあげられます。

1. サポートチャットボット

カスタマーサービスにおいて、ユーザーからの問い合わせ内容に応じてモデルが動的に選択されます。製品情報の提供には低価格なモデル、クレーム対応には高精度なモデルなど、ケースに応じて適切にルーティングされたチャット体験が提供できます。

2. コンテンツ生成プラットフォーム

ブログ記事や広告、Eメールなどの文書を自動生成するプラットフォームでは、長く複雑な文章であれば高精度モデル、短いテンプレート文章では軽量モデルを使い分けることで、品質を維持しつつコストを最小化することができます。

3. エンタープライズ利用

エンタープライズ環境では、様々な業務アプリケーションでLLM(大規模言語モデル)が利用されるようになっています。社内報告書の要約、法務文書の分類、技術文書の自動生成などにおいて、Intelligent Prompt Routingを導入することで、システム全体のパフォーマンスと運用コストを効率的に管理できます。

統合と使い方

この機能は、2024年4月よりAmazon Bedrockのコンソール経由で利用できるようになっています。設定方法も非常にシンプルで、以下の流れとなります。

1. Bedrockコンソールから「Intelligent Prompt Routing」を有効化

2. 推論リクエストに対して、ベースとなるプロンプトタイプや優先事項を設定

3. アプリケーションからBedrock APIを呼び出し、ルーティングされたモデルの出力を取得

開発者やデータサイエンティストが特別な機械学習知識を持っていなくても簡単に扱うことができ、迅速にアプリケーションへ組み込むことができる点も魅力です。

まとめ:よりスマートに生成AIを活用するために

Amazon BedrockのIntelligent Prompt Routingは、今後ますます高度化・多様化する生成系AIのニーズに対応するための強力なツールです。自動で基盤モデルを選択し、コストや応答時間を最適化するというこの仕組みは、ビジネスや開発の現場においてとても大きな価値を持ちます。

特に、まだ生成AIの全体像や活用法について十分に理解が進んでいない企業やチームにおいては、このような自動最適化の仕組みを用いることで、安心かつ効果的にAIを業務へ導入することができます。

生成AIの民主化が進む今、こうした道具を積極的に活用していくことで、誰もが簡単に高性能AIを利用できる時代がすぐそこまで来ていると言えるでしょう。Intelligent Prompt Routingは、まさにその一歩となる技術と言えるのではないでしょうか。今後の発展と、多彩な応用事例にも大いに期待したいところです。