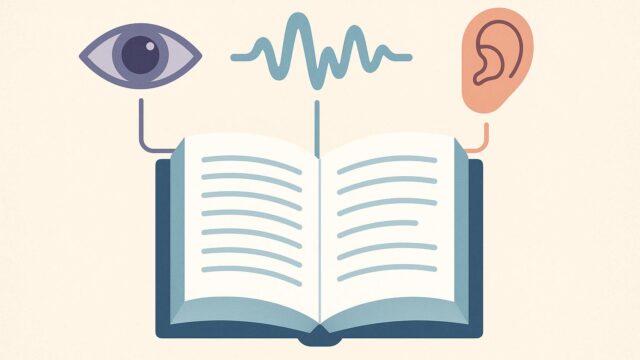

近年、AIと自然言語処理(NLP)の進化はますます加速しており、新しい技術が次々と登場しています。その中でも、埋め込みモデル(embedding models)は、テキストデータから意味を理解し、機械が人間のように言語を「理解」するための核となる技術です。多くの人がChatGPTや検索エンジン、推薦システムなどを日常的に利用していますが、それらの背後にも埋め込みモデルが大きく貢献しています。

今回は、2024年5月にHugging Faceから発表された「Matryoshka Embedding Models(マトリョーシカ埋め込みモデル)」について、そのコンセプトと意義、そして可能性について解説していきます。

マトリョーシカとは?

馴染みのある人も多いかもしれませんが、マトリョーシカとはロシアの伝統的な入れ子式の人形のことです。一体の人形の中に、だんだんと小さい人形が次々に収まっている構造をしています。見た目も可愛らしく、複雑なものがシンプルに格納されている様子は、視覚的にも直感的な魅力があります。

今回のHugging Faceによる埋め込みモデルの発表では、そのマトリョーシカの構造にヒントを得て、「入れ子」状の埋め込み表現を実現するアーキテクチャが提案されました。それが「Matryoshka Representation Learning(MRL)」です。

Matryoshka 埋め込みモデルとは?

MRLは、従来の埋め込みモデルで直面していたトレードオフ――「正確性を維持したまま、複数のサイズで効率よく利用できるか」という課題を解決するための新しいアプローチです。これまでの多くの埋め込みモデルは、事前に定められた特定の次元(たとえば384次元や768次元)で最適化されています。しかし、使用するアプリケーションや計算リソースに応じて、より小さい次元を必要とする場合や、より高精度な表現のために高次元を使いたい場合もあります。

MRLでは、埋め込みベクトルがマトリョーシカ人形のように設計されています。すなわち、たとえば768次元のベクトルの中に、最初の128次元だけを使っても十分な意味情報を保持できるように訓練されています。そのため、状況に応じて128、256、384、512、768と埋め込みの一部だけ取り出して使うことができるのです。

これにより、以下のような利点が得られます:

1. 柔軟性のある推論:リソースに応じて次元数を変更できるため、小型デバイスでも高効率なモデル運用が可能

2. 再学習不要:一度訓練されたモデルを、別の用途で別の次元数で再利用可能

3. 多目的対応:同じ埋め込みモデルを、検索エンジン・分類・クラスタリングなど、複数のタスクに柔軟に適応

どのように訓練されるのか?

MRLは、コントラスト学習(contrastive learning)という手法で訓練されます。これは、意味的に似ている文とそうでない文の距離が、埋め込み空間において適切に反映されるように学習を進めていく方法です。

最大の違いは、レイヤー的に埋め込みベクトルを「スライス」しても、高次元と同様の意味レベルを保持するように設計されている点です。これは、各ベクトルスライスがそれぞれ情報的に均等な意味を持つよう訓練されていることを意味しています。

Hugging Faceの研究チームは、これを可能にするために「Matryoshka Loss」という新しい損失関数を導入しました。この損失関数は、ベクトル全体の類似性だけでなく、その中間部分スライス同士の類似性も同時に考慮することで、すべての範囲で適切な表現ができるように学習を行います。

他のアプローチとの比較

これまでにも、汎用性のある埋め込みモデルの開発は行われてきました。たとえば、MiniLMやDistilBERT、e5などは、小型化や効率化に焦点を当てたモデルですが、これらは主に1つの固定次元において最適化されています。

一方で、Matryoshkaモデルは複数の次元に対応し、そのどれを使っても性能を大きく劣化させないという性質を持っています。以下の実験では、同じモデルを128、256、384、768次元などで使用した場合でも、精度の劣化が驚くほど少なかったと報告されています。

このような特徴により、MRLは既存のモデルと比較して、より一般的で柔軟性の高いアプリケーションへの適用が可能になります。

どこで使えるのか?

この技術の応用先は実に多岐にわたります。たとえば:

– コンテンツ検索やレコメンドエンジン:高速なベクトル検索が必要なシステムにおいて、リソースに制約のあるデバイスでは128次元、クラウド上では768次元などの使い分けが可能

– チャットボットやAIアシスタント:リアルタイムで自然言語理解を行う際、性能とリソースバランスを柔軟に調整

– タスク間転移学習(transfer learning):一つのモデルをベースに、異なるサイズのタスクにそのまま流用可能

さらに、Hugging Faceでは、このモデルをオープンソースで公開しており、誰でも無料で試すことができます。モデルは、「matryoshka-L6-v1」など複数のサイズが用意されており、用途に応じて調整が可能です。

最後に:未来への可能性

MRLは、同じ埋め込みモデルをマルチな環境で最適に利用するという、まさに「エレガント」とも言える解決策を提示しました。このアプローチは、省メモリ・高速処理・柔軟性の3拍子を揃えており、今後のAIアプリケーションにおいて非常に重要な役割を果たすと考えられます。

また、オープンソースでの公開により、多くの研究者や開発者が自分のプロジェクトにMEL(Matryoshka Embedding Learning)を応用できるようになったことも大きな意味を持ちます。

今後さらに多くの改良や発展が加えられれば、誰もが最適な埋め込みモデルを持ち歩き、用途に応じて「スライス」して使う、そんな時代も遠くないかもしれません。

新しい技術の誕生はいつも、人々の課題に対するひとつの「創造的な解」となります。MRLもまた、その代表例として、これからの自然言語処理に大きな可能性をもたらしてくれるでしょう。