Salesforceに学ぶ:Amazon SageMaker AIで実現する高性能な機械学習モデル運用

今日のビジネス環境では、人工知能(AI)と機械学習(ML)の導入が企業の競争力を高めるうえで重要な要素となっています。特に大規模なデータを扱い、高速かつ正確な意思決定を求められる企業にとって、それらの技術を効果的に運用するための基盤作りは非常に重要です。CRM(顧客関係管理)業界のリーダーであるSalesforceも例外ではありません。

Salesforceは自社のAIプラットフォーム「Einstein」を通じて、何百万もの企業ユーザーに日々AIの力を届けています。その裏側では、優れたインフラとプロセスの連携により、膨大な規模のAIワークロードを効率的に処理する必要があります。そんなSalesforceがどのようにAmazon SageMakerを活用して、高性能なAIモデルの開発・運用(MLOps)を実現しているのかをご紹介します。

目次

1. Salesforceと機械学習の役割

2. 高性能なモデル運用の課題

3. Amazon SageMakerによる課題解決

4. 効率的なモデルデプロイ戦略

5. モデル運用のアーキテクチャと工夫

6. 継続的な性能監視と改善

7. 今後の展望と学び

8. まとめ

1. Salesforceと機械学習の役割

Salesforceは、Einsteinと呼ばれるAIプラットフォームを通じて、営業やマーケティング、カスタマーサービスなど幅広い領域でAIによる機能向上を提供しています。たとえば、営業の成約率を予測したり、最適な次のアクションをレコメンドするなど、Einsteinはユーザーの日常的な業務体験を賢く、迅速にサポートしています。

このような高度なAI機能は、Reliable(信頼性)、Scalable(拡張性)、Performant(高性能)なMLライフサイクル管理を必要とします。Salesforceのような巨大なSaaS企業の場合、年間数十億件に及ぶ予測リクエストをリアルタイムで処理できるアーキテクチャが要求されるのです。

2. 高性能なモデル運用の課題

AIの実運用においては、モデル開発が成功しても、それをスムーズに本番環境へと展開(デプロイ)し、安定して運用し続けるには多くの課題が存在します。具体的な課題として以下が挙げられます。

– 多様なモデルとユースケースへの対応

– 巨大なトラフィックの取り扱い

– リソース最適化とコスト効率

– 継続的な性能モニタリングと改善

– 再現可能なデプロイメントパイプライン

これらの課題に対し、SalesforceではAmazon SageMakerを戦略的に活用し、スケーラブルかつ再利用可能なMLOps基盤を構築しています。

3. Amazon SageMakerによる課題解決

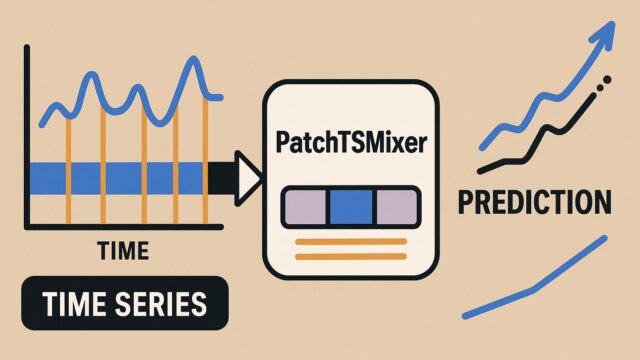

Amazon SageMakerは、AWSが提供する統合機械学習サービスであり、機械学習モデルの構築、トレーニング、デプロイメント、管理を容易にします。Salesforceでは、多数のモデルを効率的に運用するために、特に以下のSageMaker機能を活用しています。

– SageMaker Hosting:本番環境でのモデルデプロイとスケーラビリティ

– Multi-Model Endpoints(MME):複数モデルを1つのエンドポイントで動的に対応

– SageMaker Pipelines:開発から運用までのCI/CD処理を自動化

– SageMaker Model Monitor:モデルの性能異常検知やドリフト検出

4. 効率的なモデルデプロイ戦略

Salesforceでは多数のモデルを運用する必要があるため、効率的なモデルデプロイが不可欠です。その中核をなすのが「MME(マルチモデルエンドポイント)」です。

通常、AIモデルはそれぞれ別個に動かす必要がありますが、MMEを使えば、複数のモデルを一つの推論エンドポイントにまとめ、アクセス時に必要なモデルのみをロードし利用することができます。これにより、

– リソースの最適化(GPUやインスタンスタイプの削減)

– デプロイ時間の短縮

– モデルの頻繁な更新に柔軟対応

といった利点を享受できます。これによりSalesforceは、800以上の異なるモデルを持ちながらも安定的な本番環境を維持し、SLA99.9%以上で24時間365日稼働させています。

5. モデル運用のアーキテクチャと工夫

Salesforceが採用しているモデル運用アーキテクチャでは、モデルをそれぞれコンテナ化し、再利用可能なテンプレートとして構成しています。これは以下のメリットをもたらしています。

– 新規モデルへの迅速な対応

– バグ修正時の展開コスト削減

– 異なるMLフレームワーク(XGBoost、LightGBM、PyTorchなど)への柔軟性の担保

また、モデルの重量や推論時間によって異なるインスタンスプールにアサインするなど、動的なリソース管理も取り入れられています。これによりモデルのスループットとコスト効率がバランス良く保たれているのです。

6. 継続的な性能監視と改善

MLモデルの性能は時間の経過とともに劣化(ドリフト)する可能性があるため、運用中にその性能を常時モニタリングする仕組みが重要です。Salesforceでは、Amazon SageMaker Model Monitorを利用し、以下の観点で監視を行っています。

– 入力データの特性変化(データドリフト)

– 出力予測の分布変化

– レスポンスタイムの異常値

トリガーとなる異常が検知された際は、再トレーニングやアラート発出が行われ、安定したパフォーマンス維持への対応が徹底されています。また、A/Bテストを通じて新モデルの評価を行い、常に最良のモデルが本番環境で使用されるよう運用がされています。

7. 今後の展望と学び

SalesforceにおけるMLOpsの取り組みから、多くの企業が得られる学びがあります。

– 高トラフィック環境であっても、適切なツールとアーキテクチャを選択すれば、高性能かつスケーラブルなMLシステムを運用できる

– デプロイの効率を上げ、モデルを柔軟に管理できるしくみ(MME)は、AI導入の壁を低くする

– 継続的な監視と改善サイクルの自動化が、長期的なAI成功のカギ

AIは実験で終わるのではなく、成果をビジネスに繋げてこそ価値があります。今回のSalesforceの事例は、まさにその好例と言えるでしょう。

8. まとめ

Salesforceは、Amazon SageMakerを中心に高度に自動化されたMLOps基盤を構築し、Einsteinという優れたAI製品群を支えています。その成果は、数億件に及ぶ予測リクエストに対しても、高い可用性と性能を発揮するシステムを動かしているという事実に現れています。

AI導入における共通の課題──運用効率、コスト、スケーラビリティ、予測精度──を克服するヒントはこの中に詰まっています。Amazon SageMakerのような強力なツールと、柔軟で再利用可能なアーキテクチャ設計を取り入れることで、企業のAI活用は次のステージへと進化していくことでしょう。

今後もSalesforceの取り組みから、多くの企業や開発者たちがヒントを得て、AIの社会活用がさらに加速することが期待されます。ビジネスプロセスの革新を目指すすべての方々にとって、今回の取り組みは大きな指針となるに違いありません。